VLFly:基于开放词汇目标理解的无人机视觉语言导航

- 2025-07-21 08:00:00

作者丨视觉语言导航

编辑丨视觉语言导航

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

作者:Yuhang Zhang, Haosheng Yu, Jiaping Xiao, Mir Feroskhan 单位:南洋理工大学 论文标题:Grounded Vision-Language Navigation for UAVs with Open-Vocabulary Goal Understanding 论文链接:https://www.arxiv.org/pdf/2506.10756 项目主页:https://zzzzzyh111.github.io/VLFly/ 代码链接:https://github.com/zzzzzyh111/Vision-Language-Fly (coming soon)

主要贡献

提出针对无人机的视觉语言导航框架VLFly,能够实现开放词汇目标理解以及无需针对具体任务微调的零样本迁移,使无人机能够仅基于自然语言指令和自身单目相机捕获的视觉信息进行导航。 设计了模块化的VLN组件,包括自然语言理解、跨模态目标定位以及可导航航点生成模块,有效地弥合了语义指令与连续无人机控制命令之间的差距。 在多样化的模拟和真实世界环境中进行了广泛的评估,证明了VLFly在基于无人机的VLN任务中具有强大的泛化能力,并且优于所有基线方法。

研究背景

视觉语言导航的重要性: 使机器人能够根据自然语言指令执行复杂任务,是机器人学和人工智能领域的一个重要目标,尤其在家庭协助、城市检查和环境探索等自主导航场景中具有广泛的应用前景。 现有研究的局限性: 传统方法:如基于同时定位与地图构建(SLAM)和结构运动(SfM)的导航,虽然在低级导航和建图任务中表现出色,但无法解释高级语义意图或整合自然语言输入。 端到端学习方法:利用深度神经网络直接将原始感官输入映射到输出动作,虽然有潜力,但存在样本效率低、对训练数据过度依赖、泛化能力受限等问题。 模块化学习方法:结合了传统和端到端方法的优点,但依赖于大规模真实世界数据集,且存在模块间误差累积和有限的人类水平推理能力。 现有的VLN方法:大多数针对地面机器人,假设离散的动作空间,不适合空中导航,且在真实世界无人机VLN任务中的适用性尚未得到充分探索。

研究方法

问题定义

任务定义:将无人机的视觉语言导航(VLN)任务定义为一个部分可观测马尔可夫决策过程(POMDP),由状态空间 、动作空间 、观测空间 和状态转移概率 组成。 状态和动作:在每个时间步 ,无人机接收自然语言指令 、目标图像 和自身视角观测 。动作 是一个连续控制空间 中的线性和角速度命令。 观测:观测 是无人机单目相机捕获的连续 RGB 帧序列。 目标:无人机需要根据部分观测和语义信息导航到目标位置,而无需知道真实环境状态 。

整体框架

框架组成:VLFly框架由三个模块组成: 指令编码模块:将自然语言指令转换为结构化文本提示。 目标检索模块:通过视觉-语言相似性匹配,从预定义的图像池中选择与提示最相关的图像。 航点规划模块:根据自身视角观测和目标图像生成可执行的航点轨迹。 工作流程: 指令编码:输入指令通过LLaMA语言模型转换为标准化的文本提示。 目标检索:利用CLIP模型将文本提示和图像编码到共享嵌入空间,通过相似性匹配选择目标图像。 航点规划:结合当前和过去的视觉观测以及目标图像,生成未来航点轨迹。 动作执行:将航点轨迹转换为连续的控制命令,由无人机实时执行。

模块细节

指令编码模块

功能:将自然语言指令转换为结构化文本提示,以便后续模块进行目标图像检索。 实现: 使用LLaMA语言模型对输入指令进行编码,生成上下文化表示。 通过自回归生成任务特定的提示文本,格式为“Goal Image: a photo of [selected item]”。 示例: 输入指令:“Fly where a student can keep textbooks.” 输出提示:“Goal Image: a photo of backpack.”

目标检索模块

功能:从预定义的图像池中选择与文本提示最语义相关的图像。 实现: 使用CLIP模型将文本提示和图像编码到共享嵌入空间。 计算文本提示和每个图像的相似度分数,选择相似度最高的图像作为目标图像。 公式: 相似度分数: 概率分布:

航点规划模块

功能:根据自身视角观测和目标图像生成未来航点轨迹。 实现: 输入包括当前和过去 个时间步的视觉观测以及目标图像。 使用图像编码器对每个观测图像进行编码,生成特征向量。 通过目标融合编码器将当前观测和目标图像的特征进行融合。 使用Transformer解码器生成未来航点轨迹。 输出: 预测到达目标所需的步数 。 未来 个时间步的相对航点 。

动作执行

功能:将航点规划模块生成的连续轨迹转换为可执行的动作命令。 实现: 使用PID控制器将航点转换为线性和角速度命令。 动作命令直接由无人机实时执行。 公式: 航点缩放: 其中, 是最大允许线速度, 是控制频率。

实现细节

测试环境: 模拟环境:在Unity中构建,运行在配备NVIDIA GeForce RTX 4090 GPU的工作站上,控制频率约为15 Hz。 真实世界环境:在配备NVIDIA GeForce RTX 4070 GPU的笔记本电脑上运行,控制频率约为7-10 Hz,具体取决于通信延迟和机载传感器条件。 模块部署:所有模块均使用其默认预训练参数,无需额外训练。 输入输出:系统接收无人机单目相机捕获的RGB图像和文本指令,并直接输出动作命令,由无人机远程执行。

模拟和实验

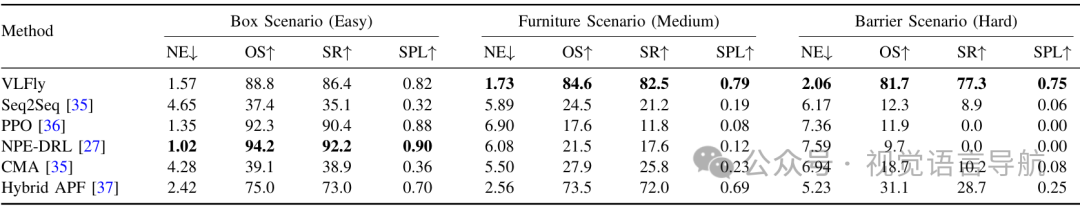

评估指标和基线方法

评估指标: 成功率(SR):无人机到达目标的百分比。 Oracle成功率(OS):轨迹中任意点是否在成功阈值(0.5米)内的百分比。 按路径长度加权的成功率(SPL):任务成功和路径效率的综合指标。 导航误差(NE):无人机最终位置与目标之间的平均欧几里得距离。 基线方法: Seq2Seq:基于循环策略的序列到序列模型,预测基于RGB-D输入的动作原语。 PPO:基于强化学习的策略优化方法,直接从RGB图像输出连续动作命令。 NPE-DRL:结合非专家模仿学习和强化学习的混合学习框架。 CMA:基于跨模态注意力的VLN模型,联合处理视觉观测和自然语言指令。 Hybrid-APF:基于人工势场的经典路径规划方法。

模拟环境中的比较

环境设置:构建了三种不同复杂度的模拟环境: 简单盒子环境:用于训练某些基线方法。 中等复杂度的家具环境。 复杂障碍物环境:具有不规则障碍物。 实验结果: VLFly在所有指标上均优于基线方法,尤其是在未见过的环境中表现出强大的泛化能力。 Seq2Seq和CMA:虽然在训练环境中表现良好,但在未见过的环境中性能显著下降。 PPO和NPE-DRL:在训练环境中表现良好,但在未见过的环境中容易过拟合。 Hybrid-APF:在结构化环境中表现良好,但在复杂环境中容易陷入局部最小值。

真实世界实验

实验设置: 室内环境:构建了包含多个不同纹理和颜色的立方体障碍物的测试场景,目标对象包括背包、玩具和AprilTag等。 室外环境:更具挑战性,具有更大的空间开放性、动态光照变化和更多的背景杂乱,如密集植被。

实验结果: VLFly在室内和室外环境中均表现出色,对于直接指令的成功率为83%,对于间接指令的成功率为70%。 轨迹可视化:展示了无人机在不同指令下的飞行轨迹和预测航点,证明了VLFly能够有效避开障碍物并导航到目标位置。 鲁棒性:VLFly能够克服由光照变化、纹理变化和无人机动力学差异引起的模拟到真实世界的差距。

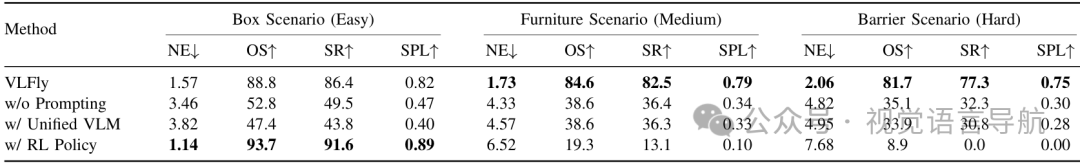

消融研究

实验目的:验证VLFly中每个模块的有效性。 变体设计: 无提示(w/o Prompting):直接使用原始语言指令进行目标检索。 统一VLM(w/ Unified VLM):用统一的视觉-语言模型(如BLIP)替换指令编码和目标检索模块。 强化学习策略(w/ RL Policy):用基于强化学习的策略网络替换航点规划模块。

实验结果: 无提示:在间接指令下性能显著下降,说明指令编码模块对语义推理的重要性。 统一VLM:无法有效处理间接指令,说明模块化设计的优势。 强化学习策略:在未见过的环境中表现不佳,说明航点规划模块的泛化能力更强。

结论与未来工作

结论: VLFly是一个专为无人机设计的新型VLN框架,能够仅使用自身单目相机捕获的视觉信息进行导航,无需外部定位或主动测距传感器。 它通过指令编码模块将自然语言转换为结构化文本提示,目标检索模块将这些提示与语义目标对齐,航点规划模块从自身视角观测中生成可解释的轨迹,从而实现了强大的泛化和鲁棒性。 未来工作: 扩展航点规划模块的训练数据集,以支持无人机的全三维机动。 探索VLMs在开放世界环境中动态识别目标候选对象的潜力,将其与目标检测或分割技术相结合。

本文只做学术分享,如有侵权,联系删文

声明:本文内容及配图由入驻作者撰写或合作网站授权转载。文章观点仅代表作者本人,不代表科技区角网立场。仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

点击这里

扫码添加微信

扫码添加微信

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊