华为CloudMatrix 384与英伟达NVL72对比

- 2025-07-30 10:15:10

公众号记得加星标⭐️,第一时间看推送不会错过。

来源:内容编译自theregister 。

Nvidia 已获准恢复向中国出口其 H20 GPU,但尽管该芯片可能供应充足,但该地区的芯片仓库运营商现在拥有更强大的替代品。

其中最有前景的是华为的 CloudMatrix 384 机架系统,该系统于本周在上海举行的世界人工智能大会 (WAIC) 上进行了展示。

该系统搭载了这家中国IT巨头最新的昇腾(Ascend)神经处理单元(NPU)P910C。假设你能拿到它,这款芯片承诺浮点性能是H20的两倍多,而且内存容量更大,尽管速度更慢。

然而,华为的 CloudMatrix 系统显然比英伟达符合制裁规定的芯片要高得多。与英伟达基于 Blackwell 的GB200 NVL72机架系统相比,华为最大的芯片拥有约 60% 的密集 16 位浮点性能,大约两倍的内存带宽,以及略高于 3.5 倍的 HBM。

一家实际上被西方芯片技术列入黑名单的公司是如何做到这一点的?很简单:CloudMatrix 384 非常庞大,其加速器数量是 Nvidia NVL72 的 5 倍多,占地面积是 Nvidia NVL72 的 16 倍。

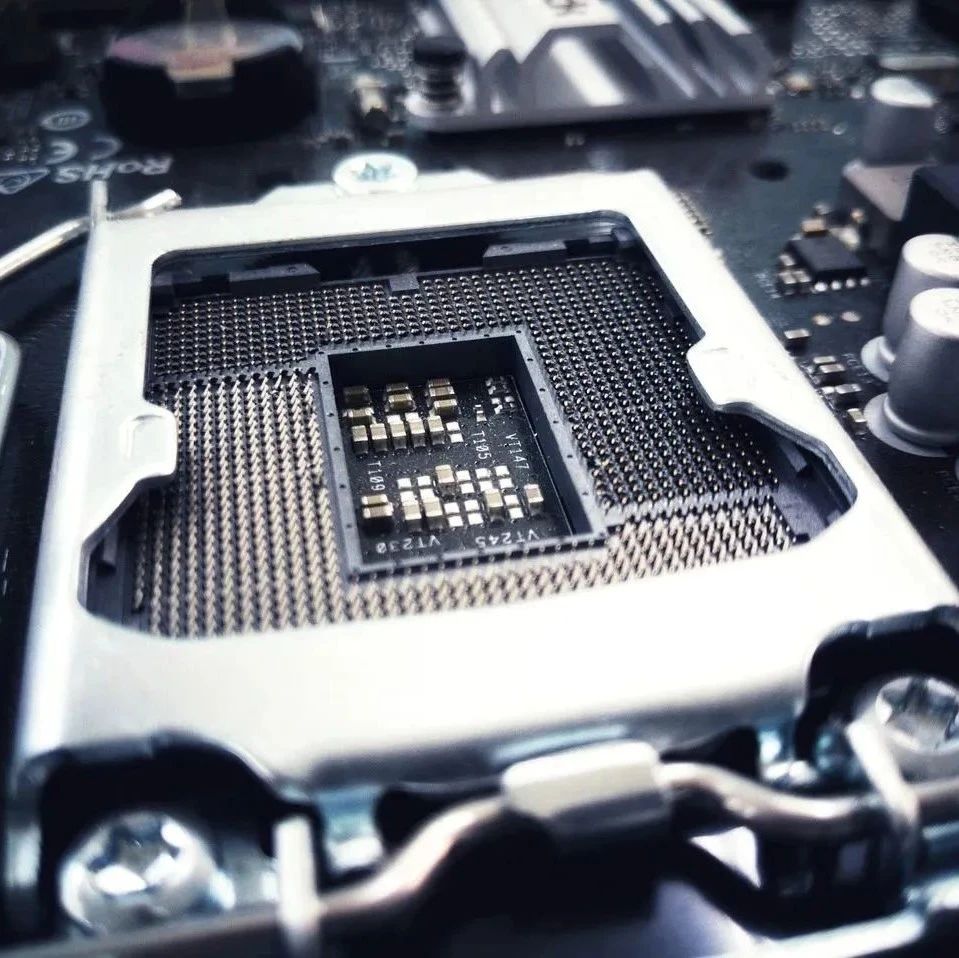

剖析Ascend P910C

CloudMatrix 384 的核心是华为的 Ascend P910C NPU。每个加速器都配备了一对计算芯片,这些芯片通过高速芯片间互连连接在一起,能够以 540GB/s 或 270GB/s 的速度双向传输数据。

这些芯片合计能够实现 752 teraFLOPS 的密集 FP16/BF16 性能。所有计算任务由八组共计 128GB 的高带宽内存堆栈提供,为每个计算芯片提供 1.6TB/s 的内存带宽,总计 3.2TB/s。

如果你一直在关注人工智能芯片的发展,你就会知道,这并不完全是你在 2025 年所说的竞争力。相比之下,Nvidia 近两年前的 H200 在 FP16 上拥有大约 83 teraFLOPS 的更高浮点性能、13GB 的 HBM 和 1.6TB/s 的内存带宽。

由于在中国无法购买 H200,因此更好的比较对象是 H20,Nvidia 即将恢复出货。虽然 H20 在内存带宽方面仍然略占优势,但 Ascend P910C 拥有更大的 HBM(128GB vs 96GB),浮点性能也是后者的两倍多。

P910C 可能不支持 FP8,但华为认为 INT8 几乎一样好,至少就推理而言。

就个人而言,P910C 是 Nvidia 中国规格加速器的一个引人注目的替代品,即使它们无法与该 GPU 巨头最新一批 Blackwell 芯片相媲美。

NPU 强强联手

然而,大多数尖端的大型语言模型并非在单芯片上训练或运行。计算内存或带宽根本不够,无法实现这一点。正因如此,芯片的独立性能远不如其高效扩展和扩展能力重要。而这正是华为设计其最新 NPU 的初衷。

华为的 Ascend P910C 具有类似 NVLink 的扩展互连或统一总线 (UB),这使得华为能够将多个加速器拼接成一个大型加速器,就像 Nvidia 对其 HGX 和 NVL72 服务器和机架系统所做的那样。

每个 P910C 加速器具有 14 个 28GB/s UB 链路(每个计算芯片七个),这些链路连接到每个节点中嵌入的七个 UB 交换机 ASIC,形成一个完全无阻塞的全对全网格,每个节点有八个 NPU 和四个鲲鹏 CPU。

与英伟达的 H20 或 B200 设备不同,华为的 UB 交换机拥有大量备用端口,可连接到第二层 UB 主干交换机。这使得华为能够从每台设备 8 个 NPU 扩展到每机架 32 个或每个“超级节点”384 个 NPU——因此得名 CloudMatrix 384。

机架到机架的角度来看,Nvidia 的 GB200 NVL72 系统在 FP16/BF16 下速度提高了 7.5 倍,内存带宽提高了 5.6 倍,内存容量提高了 3.4 倍。然而,Nvidia 仅支持最多 72 个 GPU 的计算域,不到华为的五分之一。正因如此,这家中国 IT 巨头才得以在纸面上宣称其系统级性能优于其西方竞争对手。

正如您所料,由于每个机架仅配备 32 个 NPU,完整的 CloudMatrix 384 比 Nvidia 的 NVL72 大得多。华为最大的 AI 架构横跨 16 个机架,其中 12 个用于计算,4 个用于网络。

我们注意到,从技术上讲,Nvidia 的 NVLink 交换机技术可以支持最多 576 个 GPU 的扩展网络,但我们尚未在实际中看到这样的系统。

对于需要超过 384 个 NPU 的部署,华为 CloudMatrix 还为每个加速器提供 400Gbps 的横向扩展网络。该公司声称,这可以支持最多包含 165,000 个 NPU 的训练集群。

推理性能

至少从推理角度来看,这些大规模计算结构具有一些优势,特别是当涉及到最近中国涌现的大量专家混合 (MoE) 模型时。

更多的芯片意味着运营商可以更好地利用张量、数据和专家并行等技术来提高推理吞吐量并降低每个令牌的总体成本。

华为在上个月发表的一篇论文中解释道,以 CloudMatrix 384 为例,可以配置像 DeepSeek R1 这样的混合专家模型,以便每个 NPU 芯片都承载一个专家。

为了实现这一点,华为开发了一个名为 CloudMatrix-Infer 的 LLM 推理服务平台,该平台将预填充、解码和缓存功能分离开来。研究人员写道:“与现有的以 KV 缓存为中心的架构不同,这种设计能够通过 UB 网络实现对缓存数据的高带宽、统一访问,从而减少数据局部性约束,简化任务调度,并提高缓存效率。”

如果这些听起来很熟悉,那是因为 Nvidia 在 GTC 上宣布了一款类似的 GPU 系统,名为 Dynamo,我们在三月份对其进行了深入研究。

华为在 DeepSeek-R1 上进行测试,结果表明 CloudMatrix-Infer 的性能显著提高,单个 NPU 每秒可处理 6,688 个输入令牌,同时以每秒 1,943 个令牌的速度生成令牌。

这听起来可能不可思议,但值得指出的是,总吞吐量是在批处理大小为 96 的情况下实现的。单个性能接近每个输出令牌 50 毫秒,或每秒 20 个令牌。将单个性能提升到每秒 66 个令牌左右(这可能会对 R1 这样的思维模型产生显著的影响),会导致 NPU 的整体吞吐量在批处理大小为 8 的情况下降至每秒 538 个令牌。

华为表示,在理想条件下,其快速处理效率可达每秒 4.5 个令牌/万亿次浮点运算 (TFLOPS),略高于英伟达 H800 的每秒 3.96 个令牌/万亿次浮点运算 (TFLOPS)。在解码阶段,华为也展现了类似的性能,其机架系统比英伟达 H800 领先约 10%。与往常一样,请谨慎看待这些供应商的说法。推理性能很大程度上取决于你的工作负载。

功率、密度和成本

虽然每秒每万亿次浮点运算(teraFLOPS)的tokens数量或许能反映出系统的整体效率,但实际上更重要的指标是系统生成的tokens价格。这通常以每美元每瓦特的tokens数量来衡量。

因此,尽管 CloudMatrix 384 的规模使其能够与 Nvidia 功能更强大的 Blackwell 系统竞争甚至超越其性能,但如果部署和运营成本更高,那就无关紧要了。

华为 CloudMatrix 系统的官方功率额定值很难确定,但 SemiAnalysis推测整个系统的总功率可能在 600 千瓦左右。相比之下,GB200 NVL72 的功率约为 120kW。

假设这些估计是准确的,那么这不仅会使 Nvidia 的 NVL72 的计算密度提高数倍,而且其能效将提高 3 倍以上,达到每瓦 1,500 gigaFLOPS,而华为的能效为每瓦 460 gigaFLOPS。

在西方,获取廉价电力或许是一个主要瓶颈,但在中国却未必如此。过去几年,北京大力投资国家电网系统,建设了大量太阳能发电场和核反应堆,以抵消对燃煤电厂的依赖。

更大的问题可能是基础设施成本。据报道,华为CloudMatrix 384的零售价约为820万美元。英伟达的NVL72机架系统单价估计约为350万美元。

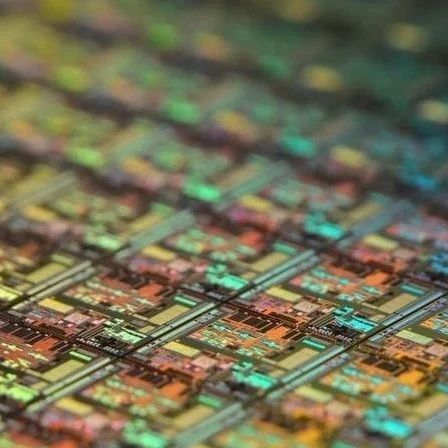

但如果你恰好是中国的模型开发者,那么英伟达的 NVL 机架根本不值得考虑。由于美国对 AI 加速器的出口管制,华为在机架级领域几乎没有竞争对手,唯一的主要瓶颈或许就在于中国代工巨头中芯国际能生产出多少台 P910C。

美国立法者仍然坚信中芯国际缺乏大规模生产如此复杂芯片的能力。然而,就在几年前,业内专家还认为中芯国际缺乏生产7纳米及更小工艺节点所需的技术,但事实并非如此。

华为的 CloudMatrix 系统产量还有待观察,但与此同时,英伟达首席执行官黄仁勋很乐意为中国数据中心提供尽可能多的 H20 芯片。据报道,英伟达已向台积电额外订购了 30 万片 H20 芯片,以满足中国客户的强劲需求。

《The Register》联系华为寻求评论,但截至本文发表时尚未收到回复。

参考链接

https://www.theregister.com/2025/07/29/huawei_rackscale_boogeyman/

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

END

今天是《半导体行业观察》为您分享的第4110期内容,欢迎关注。

推荐阅读

加星标⭐️第一时间看推送,小号防走丢

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊