重磅!华为昇腾384超节点真机首次线下展出!

- 2025-07-29 08:48:00

关注我们 设为星标

EETOP

百万芯片工程师专业技术论坛

官方微信号

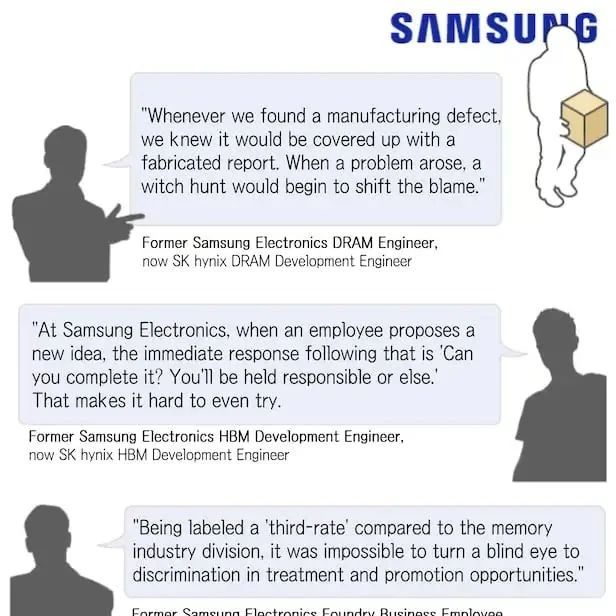

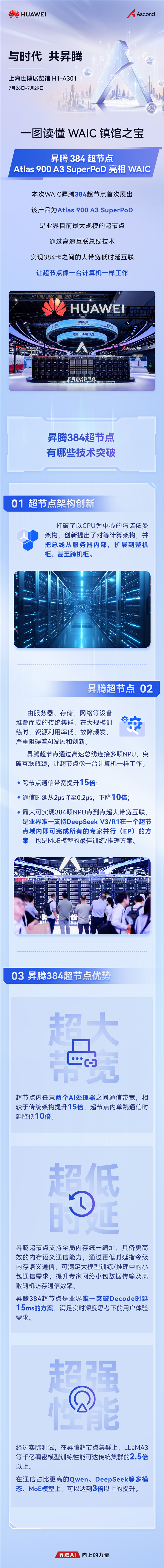

在7月26日-7月29日于上海世博展览馆H1-A301举办的WAIC(世界人工智能大会)上,华为首次展出昇腾384超节点,即Atlas 900 A3 SuperPoD,成为备受瞩目的“镇馆之宝”,是业界目前最大规模的超节点。

昇腾384超节点打破了以CPU为中心的冯诺依曼架构,创新提出了对等计算架构,还将总线从服务器内部扩展到整机柜、甚至跨机柜,极大地改变了数据传输和处理的方式。

昇腾 384 超节点是华为推出的超节点技术,于 2025 年 5 月 23 日正式发布。以下是简单介绍:

硬件架构

组成结构:由 12 个计算柜和 4 个总线柜构成,实现了业界最大规模的 384 卡高速总线互联。

互联方式:创新性地将 384 颗昇腾 NPU 与 192 颗鲲鹏 CPU 通过 MatrixLink 高速网络全对等互联,形成单节点 “超级 AI 服务器”。

技术优势

超大带宽:超节点内任意两个 AI 处理器之间通信带宽相较于传统架构提升 15 倍,有效解决了传统服务器跨机带宽低的问题,使集群内数据传输更加高效。

超低时延:单跳通信时延从 2 微秒降低到 200 纳秒,降低了 10 倍。支持全局内存统一编址,具备更高效的内存语义通信能力,通过更低时延指令级内存语义通信,可满足大模型训练 / 推理中的小包通信需求,提升专家网络小包数据传输及离散随机访存通信效率,是业界唯一突破 Decode 时延 15ms 的方案,能满足实时深度思考下的用户体验需求。

超强性能:在昇腾超节点集群上,LLaMA 3 等千亿稠密模型性能相比传统集群提升 2.5 倍以上;在通信需求更高的 Qwen、DeepSeek 等多模态、MoE 模型上,性能提升可达 3 倍以上,较业界其他集群高出 1.2 倍,以 “一卡一专家、一卡一算子任务” 的灵活分配、并行推理,将算力有效使用率(MFU)提升 50% 以上。

扩展能力:通过高速网络交换机组成 384 卡超节点,纵向扩展能力强大;参数面交换机最大支持 16 万卡集群规模,横向扩展能力也十分出色。可将 432 个超节点级联成最高 16 万卡的超大集群,为未来更大规模的模型演进提供了有力支撑。

存力提升:配合 PB 级虚拟显存、跨节点 / 集群 DRAM 池等创新设计,KV Cache 传输带宽提升 10 倍,输出每个 Token 的时延降至 50ms。

应用场景

大模型训练:为大模型训练提供了强大的算力支持,如千亿参数 MOE 模型等,能有效提升训练效率,缩短训练时间。

推理服务:基于大规模专家并行方案,通过多专家负载均衡和极致通信优化,实现高吞吐、高性能的推理服务,如硅基流动在 CloudMatrix 384 昇腾 AI 云服务上部署 DeepSeek-R1,在保证单用户 20TPS 水平前提下,单卡 Decode 吞吐突破 1920Tokens/s。

多领域应用:已在多个行业得到应用,如新浪基于此让“智慧小浪” 推理交付效率提升 50%+;中科院基于此自研模型训练框架,快速构建 AI4S 科研大模型;科大讯飞基于此助力讯飞星火大模型极致推理性能等。

欢迎加入 EETOP 微信群

CadenceLIVE China 2025 中国用户大会

邀请报名

AI驱动验证专题

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊