ICCV 2025 | 南开 × 阿里:ATPrompt 让 VLM 提示学习拥有「属性推理」能力,未知类识别更聪明!

- 2025-07-03 08:00:00

点击下方卡片,关注“大模型之心Tech”公众号

今天大模型之心Tech为大家分享南开PCA Lab和阿里达摩院被ICCV 2025接收的大模型相关工作。本文提出了一种名为 ATPrompt 的属性锚定文本提示学习方法,旨在通过通用属性作为桥梁,增强图像与未知类别的对齐,提升视觉语言模型在下游任务中的泛化能力。如果您有相关工作需要分享,请在文末联系我们!

论文标题:Advancing Textual Prompt Learning with Anchored Attributes

论文作者:Zheng Li等

作者单位:南开PCA Lab、阿里达摩院等

论文链接:https://arxiv.org/pdf/2412.09442

开源链接:https://zhengli97.github.io/ATPrompt

属性锚定文本提示学习——文章动机与贡献

研究背景:VLM的提示学习困境

视觉-语言模型(VLMs)如CLIP、ALIGN通过对比学习实现图像与文本(类别)空间的对齐,在下游任务中展现出强大的零样本泛化能力。受自然语言处理中提示学习的启发,基于文本的提示学习方法(如CoOp、CoCoOp)通过可学习的soft token与cls token级联作为文本输入,实现了参数高效的模型适配。这类方法的核心逻辑是通过优化soft token,使图像特征与预定义类别的文本特征对齐,但存在一个根本局限:训练过程被限制在已知类别空间内,无法有效关联未知类别。

图1. 通过可学习提示实现的图像与文本(类别)对齐过程对比。(a) 当前提示学习方法将图像与预定义类别对齐,但无法与未知类别建立准确关联。(b) ATPrompt 利用通用属性作为中介,在图像与未知类别之间实现更精准的对齐。

如图1(a)所示,传统方法中图像仅能与预定义的“孟加拉猫”“哈瓦那犬”等已知类别对齐,当面对新类别时,由于缺乏直接的文本映射,对齐精度显著下降。这一问题的本质在于,现有提示学习将文本空间约束在一维的“类别名称”层面,忽略了人类理解未知概念时依赖的属性关联能力——例如,描述猎豹时会通过“小头、黄色短毛、黑色斑点”等属性增强理解,而非仅依赖名称。

核心动机:属性作为连接未知类别的桥梁

人类对未知类别的认知通常依赖属性(如颜色、形状、功能等)作为中介,而现有VLMs的提示学习缺乏这种属性级别的表征能力。基于此,本文提出核心假设:通用属性可作为桥梁,增强图像与未知类别的对齐。具体而言,属性具有以下优势:

语义通用性:属性(如“颜色”“大小”)是跨类别的共享特征,不依赖特定类别定义,可迁移至未知场景; 表征丰富性:属性能够补充类别名称之外的细节信息,帮助模型捕捉图像的细粒度特征; 未知类别扩展性:当遇到新类别时,属性可作为先验知识,避免模型因缺乏类别标注而失效。

如图1(b)所示,ATPrompt通过引入“玩闹性”“活力”等通用属性Embedding,将文本提示从单一CLS token扩展为“属性-类别”混合形式,使soft token在训练中同时学习类别特异性和属性相关性表征,从而在未知类别场景中实现更准确的图像-文本对齐。

研究贡献

属性锚定的多维度提示学习框架

提出Attribute-anchored Textual Prompt(ATPrompt),首次将soft token的学习空间从一维类别级别扩展至多维属性级别。通过在可学习soft token中Embedding固定的通用属性Token(如“颜色”“形状”的文本Embedding),使提示同时包含类别和属性信息。训练过程中,soft token在属性引导下不仅学习类别相关表征,还捕获属性级别的通用特征,从而提升对未知类别的泛化能力。

结构兼容:浅层与深层双版本设计

为适配不同深度的现有提示方法,ATPrompt提供两种实现形式:

浅层版本:在文本编码器输入层将属性Token与soft token、CLS token级联,如 [soft token][属性A][soft token][属性B][CLS token];深层版本:在Transformer块间有选择地丢弃与类别相关的soft token,保留属性Token,确保深层特征中属性表征的连续性。

这种设计使ATPrompt可无缝集成到CoOp、MaPLe等不同深度的基线方法中,无需修改原有模型架构。

自动搜索:可微属性选择机制

提出基于LLM和可微搜索的属性筛选流程:

通过LLM生成类别描述,提取独立属性基(如“颜色”“大小”),构建包含所有可能组合的属性池; 采用类似DARTS的可微搜索算法,通过交替优化soft token权重和属性组合权重,从池中筛选最适合下游任务的属性组合(如ImageNet中筛选出“颜色+形状”)。

该搜索过程仅需5分钟/任务,计算成本极低,且筛选出的属性具有任务特异性(如StanfordCars中筛选出“豪华感”属性)。

在11个数据集(包括细粒度分类、场景识别等)上的实验表明:

ATPrompt可使CoOp、CoCoOp等基线方法的平均性能提升0.45%~1.38%; 在跨数据集泛化(如ImageNet→Caltech101)和领域泛化(如ImageNet→ImageNet-V2)任务中均表现出稳定改进; 作为插件技术,额外计算开销可忽略,且属性搜索仅需执行一次。

本文首发于大模型之心Tech知识星球,硬核资料在星球置顶:加入后可以获取大模型视频课程、代码学习资料及各细分领域学习路线~

ATPrompt方法设计与属性搜索机制

图2. 现有方法的架构对比。(a) 原始CLIP采用手工设计的文本模板作为文本编码器的输入。(b) 经典提示学习提出了一种新的文本形式,将多个可学习的软Token与CLS token级联。(c) ArGue采用由大语言模型挖掘的多个类内属性作为补充信息。这些属性被用于构建不同的文本组,作为学习目标,从而规范软Token的学习。最终的预测通过集成所有组来实现。(d) 我们的ATPrompt将通用属性视为学习组件,并将其锚定到现有的soft token模板中。通过此操作,我们将软Token的学习空间扩展到多维属性级别,并促进图像与未知类别文本的对齐。

1. 方法总览:属性锚定提示的核心架构

ATPrompt的核心目标是通过引入通用属性,将传统提示学习的一维类别表征扩展为多维属性-类别联合表征。其设计遵循“插件式兼容”原则,可无缝集成到现有基于文本的提示学习框架中。如图2(d)所示,与传统方法(图2(b))相比,ATPrompt在soft token中Embedding固定的属性Token(如“颜色”“形状”),使文本输入从[soft token][CLS token]转变为[属性Token][soft token][CLS token]的混合形式,从而在训练中引导模型学习属性相关的通用特征。

2. 技术基础:视觉-语言模型与提示学习预备知识

VLMs的基本框架:以CLIP为例,模型通过对比损失学习图像与文本的跨模态对齐。给定图像和类别,图像编码器提取特征,文本编码器对类别描述(如“一张{c}的照片”)提取特征,分类概率通过余弦相似度计算:

其中为温度参数。

传统文本提示学习:如CoOp方法,将可学习的soft token tokens

[T1, T2, ..., T_M]与cls token[CLS]级联作为文本输入,形式为:训练目标是优化soft token,使文本特征与图像特征对齐。深层提示方法(如MaPLe)进一步在Transformer块间引入soft token,形式为:

其中为第层Transformer块,为第层的soft token。

3. ATPrompt的双版本设计:浅层与深层实现

图3. 浅层和深层版本的计算过程示意图。以两个属性[A]和[B]为例。(a) 浅层版本将硬属性Token、soft tokenToken和CLS token级联后输入编码器进行计算。(b) 深层版本使用相同的输入,但在计算自注意力后丢弃与类别相关的soft tokenToken,并在下一层之前重新引入这些Token。这两种形式可以与现有的不同提示深度的方法兼容,包括输入级的方法如CoOp[59]、CoCoOp[58],以及深度级的方法如MaPLe[18]。

浅层版本:输入层属性锚定

在文本编码器的输入层,将属性Token与soft token、CLS token级联。以两个属性A和B为例,输入形式为:

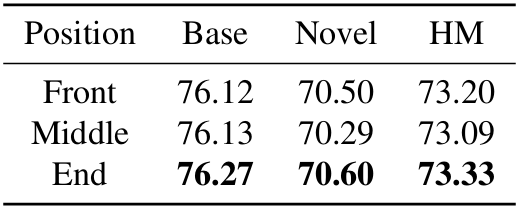

其中和为属性A和B对应的可学习soft token,为类别相关soft token。默认情况下,属性与类别soft token的长度相同()。实验验证,将CLS token置于末尾(如上述形式)时性能最优(见表5),这与CoOp的结论一致。

深层版本:跨层属性表征保持

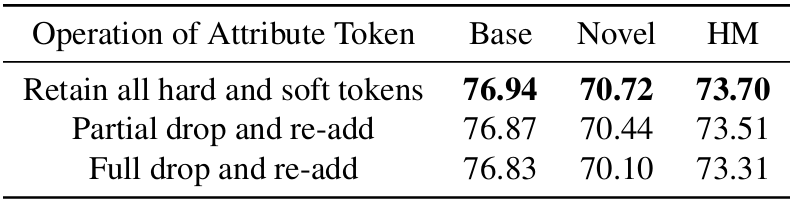

针对深层提示方法(如MaPLe),ATPrompt改进了soft token的丢弃与重引入策略:

传统方法在Transformer块间丢弃所有soft token,导致属性表征断裂; ATPrompt仅丢弃与类别相关的soft token [T1...T_M],保留属性Token[A][B]及其对应的soft token,确保属性特征在深层网络中的连续性。具体过程为:其中为第层特征,为类别相关soft token。实验表明(见表6),保留属性Token的硬soft token组合(“Retain all”)性能最佳,而丢弃属性提示会破坏特征连续性。

4. 属性搜索机制:从LLM生成到可微筛选

图4. 我们的属性搜索流程概述。(a) 我们首先迭代查询大型语言模型(LLM)以获取多个独立属性。这些属性随后被聚合形成候选组合池,作为搜索过程的输入。(b) 每个候选组合的前向计算由不同颜色的路径表示。为了确定最优属性,我们采用交替优化算法来共同优化软Token和相应的路径权重向量。训练完成后,与最高权重路径相关的组合将被选为最终输出。

属性池构建:基于LLM的语义提取

受Chain-of-Thought(CoT)启发,通过两步LLM查询生成属性候选池:

类别描述生成:提示LLM(如ChatGPT-4o)对每个已知类别生成详细描述,例如“猎豹是一种头部小、毛发短黄、带有黑色斑点的猫科动物”; 属性基提取:基于描述总结独立属性基(如“颜色”“形状”“栖息地”),并生成所有可能的组合(如单属性、双属性组合)。对于个属性基,候选池包含个组合(如时生成31个组合)。

可微属性搜索:基于DARTS的权重优化

为从候选池中筛选最优属性组合,引入可微搜索算法:

松弛化选择:将离散的属性组合选择转化为软max加权求和:其中为候选池,为组合的权重,为soft token参数。 交替优化:通过最小化验证集损失优化属性权重,同时通过训练集损失优化soft token:搜索收敛后,选择权重最高的属性组合(如ImageNet中筛选出“颜色+形状”,见表3)。

计算成本分析

与传统神经架构搜索(NAS)相比,ATPrompt的属性搜索聚焦于轻量级的“token级”空间,效率极高:

单卡A800上仅需5分钟/任务(约5个训练周期); 可通过限制属性基数量(如)进一步缩小搜索空间,平衡精度与效率。

5. 训练目标与优化策略

训练过程中,ATPrompt的目标是最小化交叉熵损失:

其中为固定属性Token,为可学习soft token参数。初始化时,类别soft token采用高斯分布(均值0,标准差0.02),属性Token的Embedding通过LLM预训练获取。实验表明(见表12),随机初始化优于传统的“a photo of a”短语Embedding,因属性Token的引入改变了提示的语义结构。

实验验证与结果分析

本文通过多组实验验证ATPrompt的有效性,覆盖基础到新类别泛化、跨数据集迁移等场景,全面展示方法的性能提升与鲁棒性,具体内容如下:

1. 实验设置与数据集

Base-to-Novel泛化:将数据集划分为基础类(Base)和新类(Novel),模型在基础类训练后评估新类性能,属性基于基础类搜索。涉及数据集包括ImageNet、Caltech101、OxfordPets等11个分类任务数据集。 跨数据集实验:以ImageNet1K为源数据集,在Caltech101、StanfordCars等域外数据集上评估泛化能力,属性从源数据集获取。 属性搜索配置:使用ChatGPT-4o生成5个属性基(如ImageNet的“颜色、大小、形状”),构建31种组合的候选池,通过可微搜索筛选最优属性(如Flowers102中选“颜色+栖息地+生长”)。

表3. 可微属性搜索后获得的部分结果。完整结果请参考附录。

2. 核心实验结果

Base-to-Novel泛化性能

表1. 五个基线方法在有和没有我们的ATPrompt情况下在11个数据集上的从基础类到新类的泛化实验。我们的方法在不同基线上实现了一致的平均性能提升。

在5种基线方法(CoOp、CoCoOp、MaPLe等)上集成ATPrompt后,11个数据集的平均准确率均显著提升。例如: CoOp+ATPrompt在11个数据集上平均提升1.38%,其中StanfordCars新类准确率从70.40%提升至72.23%; MaPLe+ATPrompt在Food101上的调和均值(HM)从95.36%提升至96.92%。 原因分析:ATPrompt通过属性锚定增强了模型对未知类别的语义理解,减少了对基础类的过拟合。

跨数据集与领域泛化

表2. 三个基线方法在有和没有我们的ATPrompt情况下在11个数据集上的跨数据集泛化实验。ATPrompt在目标数据集上实现了一致的平均性能提升。

表4. 三个基线方法在有和没有我们的ATPrompt情况下在四个数据集上的领域泛化实验。ATPrompt的集成带来了更好的泛化性能。

跨数据集:以ImageNet为源,ATPrompt使CoOp在目标数据集的平均准确率提升1.38%,其中EuroSAT从66.55%提升至69.92%; 领域泛化:在ImageNet-V2、ImageNet-R等变体上,ATPrompt使CoOp性能提升0.90%,证明对不同数据分布的适应性。

3. 消融实验

soft token长度

图5. 在ImageNet上改变软Token长度的示意图。Token数量的增加会导致对基类的过拟合,并削弱对新类别的泛化能力。

当soft token长度从1增加到10时,新类准确率先升后降(如图5)。过长提示会稀释属性引导作用,导致模型过度拟合基础类,最优长度通常为2-4(如ImageNet中长度2时HM达73.33%)。

CLS token位置

表5. 在ImageNet上不同CLS token位置的比较。末尾位置效果最佳。

对比CLS token在“前端”“中间”“末尾”的性能(见表5),置于末尾时HM最高(73.33%),因符合文本编码器对关键信息的捕获习惯(如CoOp结论一致)。

深层版本的属性操作

表6. 基于MaPLe+ATPrompt的深度软属性Token和硬属性Token操作对比。在深层中保留硬属性Token和软属性Token的表现优于其他操作。

在MaPLe+ATPrompt中,保留属性硬soft token(“Retain all”)时HM达73.70%,优于部分丢弃(73.51%)或全丢弃(73.31%),证明属性表征的跨层连续性对性能至关重要(见表6)。

属性顺序与类型

表7. 在ImageNet上不同顺序的比较。属性的顺序对模型没有显著影响,性能波动在合理范围内。

表8. 11个数据集上各种属性配置的平均性能比较。我们的方法获得的属性实现了最佳性能。

属性顺序不显著影响性能(如“颜色+形状”与“形状+颜色”的HM差异<0.1%,见表7),因属性语义独立; 手动选择的无关属性(如“足球”“运动”)在新类中表现差(HM 73.59%),而ATPrompt搜索的属性(如“颜色+形状”)HM达74.65%,验证自动搜索的有效性(见表8)。

总结

本文提出了ATPrompt,一种属性锚定的文本提示学习方法,该方法使用通用属性作为桥梁来改善从已见过类别到未见过类别的泛化能力。所提出的方法通过将固定的属性Token与提示锚定在一起,将soft token的学习空间从一维的、以类别为中心的结构扩展到多维的属性空间。为了确保最优属性的选择,作者提出了一个自动化流程,旨在为任何给定的下游任务识别最合适的候选属性。ATPrompt设计有浅层和深层两种架构变体,使其与现有提示学习方法广泛兼容。大量实验验证了所提出方法的有效性。这项工作为提示学习领域中可学习提示的基础结构研究提供了新的方向。

知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,欢迎扫码加入一起学习一起卷!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊