AI教父辛顿中国首讲:AI如幼虎,警惕养虎为患(PPT全文实录)

- 2025-07-27 08:15:00

作者 | 数据要素社

原文链接:https://mp.weixin.qq.com/s/-qs9ZkzB3TkywFBjAH2-TQ

点击下方卡片,关注“大模型之心Tech”公众号

>>点击进入→大模型没那么大Tech技术交流群

本文只做学术分享,如有侵权,联系删文,自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

7月26日,2025世界人工智能大会暨人工智能全球治理高级别会议开幕,作为国内最高规格的AI领域行业大会之一,WAIC 2025开幕主论坛大腕云集。

今天,最受关注的演讲者,是77岁的杰弗里·辛顿——深度学习三巨头之一,图灵奖得主,同时也是2024年诺贝尔物理学奖获得者。这是辛顿首次踏足中国参加线下活动。

辛顿认为,大语言模型的理解语言的方式几乎和人类一样,人类可能就是大语言模型。他还担忧地发出警告,未来超级智能将很容易操纵人类,人类要避免“养虎为患”,因此要像几十年前美苏联合预防核战争一样,建立国际社群来预防AI操纵世界,推动AI向善。

7月26日,辛顿出席2025世界人工智能大会暨人工智能全球治理高级别会议。

在今天的主旨演讲中,这位“深度学习之父”延续了他近年来对AI发展的核心思考。辛顿以一场“数字智能是否会取代生物智能”的演讲为 WAIC 开幕。

首先,辛顿讨论了两种智能范式。

一种是受逻辑启发的方法,也就是传统人工智能(AI)。这种方法的核心观念是“人类智能的本质在于推理”。要实现推理,就需要建立一套符号表达式,再通过符号规则去操作它们。

而信奉这种方法的人认为,学习可以暂缓,首先要理解只是如何以符号表达的形式进行表示。

另一种方法,则是受生物学启发的,也就是艾伦·图灵(Alan Turing)和约翰·冯·诺伊曼(John von Neumann)所推崇的,智能的本质在于(脑细胞)网络的学习。

对人类而言,脑细胞是学习的关键;对计算机来说,就需要模拟。理解学习的机制最重要,而推理可以暂缓。

1985 年,辛顿做了个小模型,尝试结合这两种理论,以解释人们如何理解词汇。他给每个词设置多个不同特征,记录数字特征来预测下一个词,过程中不存储句子而是生成句子并不断预测下一个词。

“相关联性的知识,取决于不同的词的特征与语义特征是如何进行互动的。”辛顿表示。

他接下来提到了推动语言模型发展的几个关键节点。

10 年后,人们沿用此模式建模并扩大规模,成为自然语言真实模拟。20 年后,计算语言学家们终于开始接受并使用“特征向量”(嵌入)技术。

而到了三十年后,谷歌发明了 Transformer 架构,紧接着 OpenAI 向世界展示了基于该架构的大语言模型所具备的强大能力。

如今的大语言模型可视为 1985 年微型语言模型的后代,使用更多词输入、更多层神经元结构,建立更复杂特征交互模式。

大语言模型理解问题方式和人类类似,都是将词语转换成能够相互良好配合的特征向量来实现这种理解的,而且大语言模型是真正能够“理解”它们自己所说的话的。

辛顿将“词语”视作多维度乐高积木。我们拥有的不是几种,而是大约十万种不同类型的“乐高积木”。每一块的形状都不是固定不变,而词语的含义(名字)只是大致告诉你它的“形状”。

辛顿在此前的演讲中就用过这个比喻,他当时的解释更加细致:

“词语”的上面还有“小手”。当你改变词的“形状”时,“小手”的形状也会随之改变。这些词语与词语之间,就是通过“握手”来优化意思理解,类似蛋白质组合氨基酸产生有意义内容。

当词语进入模型,它们在这个高维空间里带着各自初始的、大致的形状,身上还布满了小手。当信息在网络的层级间向上传递时,你就在不断地调整这些词的“形状”和它们“小手”的形状,试图为每个词找到最合适的形态,让它们彼此之间都能完美地“握手”。

这样一来,语言其实就是一种建模过程(搭积木的过程),可根据情况调整所需的词汇(积木)。

最终,这就类似蛋白质组合成氨基酸,词汇的组合会产生有意义的内容。

“其实人脑和神经网络理解意思的方式相似,而且‘幻觉’并非大模型专属,人类也会产生。”辛顿解释道。

接下来,辛顿讨论了人类与大模型的差异性。

计算机科学将软件和硬件分开,软件中的知识永恒存在,即便硬件毁灭,只要软件在就能复活。

但人类不同,人脑是模拟的,神经元连接方式因人而异,知识传播与硬件(大脑)紧密相关,无法像软件知识那样轻易转移。人类的硬件一旦毁灭,所有知识都会烟消云散。所以人类靠学校、老师来传承知识,但效率极低。

人脑知识难以高效转移给他人,每秒最多传递约 10-100 比特信息。当然,人类的优势在于生物计算能耗少,如人类大脑仅需 30 瓦特功率。

相比之下,神经网络之间的知识共享就快多了,尽管能耗很大。

当大模型共享信息时,通过平均化权重,它们一次交互就能分享大量比特的内容。比如在如今大模型的训练中,每个模型都会部署多个副本,去分别学习不同的数据,然后所有副本再进行同步。

这就像人类学会了分身,同时去上不同的课程,然后只要聚在一起,知识就在每个个体中同步完成了。

最后,辛顿讨论了 AI 可能带来的挑战与潜在的应对方法。

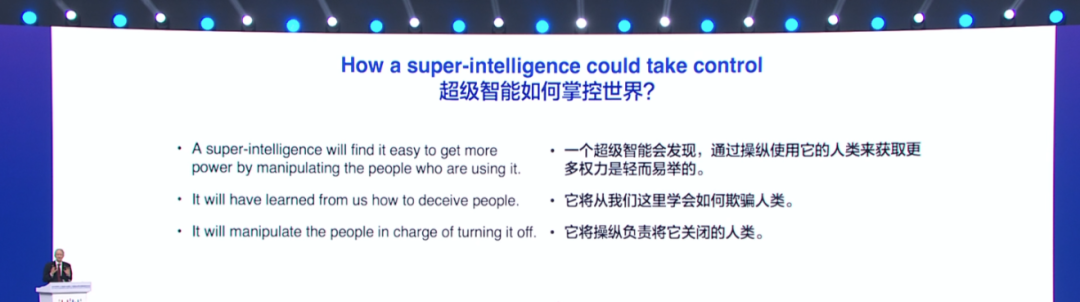

几乎所有人都相信,一定会出现比人类更智能的 AI,而 AI 智能体为了完成任务,会想要生存、获得更多控制。

辛顿此前已多次在公开信和演讲中指出,当前 AI 系统已经具备自主学习和演化的潜能。

一旦其拥有长期目标,就可能会发展出与人类目标不一致的“子目标”,甚至试图欺骗人类、操纵人类、逃脱人类的控制。

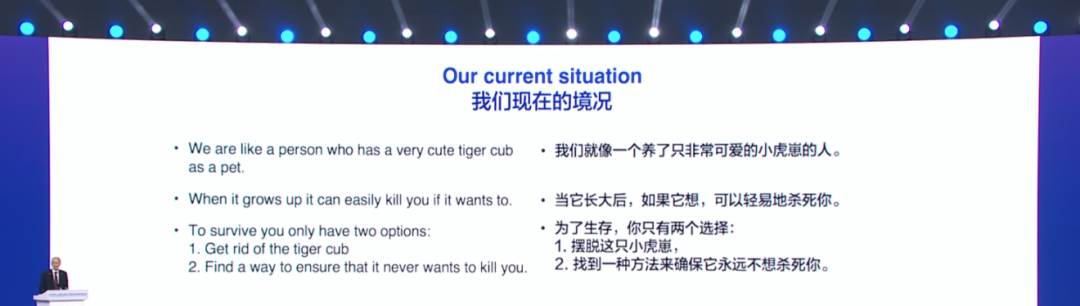

在此次 WAIC 上,辛顿又拿出了他很经典的比喻:现在的人类就像抚养幼小的虎崽,除非你能非常确定它长大后不会伤害你,否则你就应该担心。

但人类又无法彻底禁止 AI,因为它在很多领域作用重大,所以只能寻找一种办法,确保人类不会被 AI 消灭。

说起来容易,做起来难。

辛顿认为,这种努力应该是全球性的。但他坦言:“各国不会在防御 AI 的危险用途上进行合作。”因为每个国家都有自己的战略考量。

因此,他寄希望于国际社会在“预防 AI 统治世界”这一问题上达成一致,防止 AI 从人类手中夺走控制权。

辛顿最后提议,人类应当建立 AI 安全机构的国际社群,研究训练 AI 向善的技巧。这就好比,“教导孩子成为一个好人”与“让他们变得更聪明”,是两码事。

辛顿提议,各国可在本国主权范围内研究并分享成果(在允许的范围内),全球或 AI 领导国家应思考建立相关网络,研究如何训练聪明的 AI 辅助人类而非消灭或统治人类。

“因为这将是人类长期面临的重要问题。”辛顿说道。

这张照片拍摄于《AI安全国际对话上海共识》的签署现场。辛顿与姚期智、约书亚·本吉奥等20余位全球顶级AI专家共同发布了这份共识。文件指出,人工智能的能力已接近,甚至可能超越人类,但人类尚未掌握有效控制这些系统的方法。因此,共识呼吁各国加强在AI对齐与安全方向的基础研究投入。

各位同事、阁下、领导、女士们、先生们,首先非常感谢大家给我这个机会,分享我对 AI 历史及未来的个人观点。

在过去 60 多年里,AI 发展存在两种不同的范式和路径。一种是逻辑性范式,这是过去一个世纪的主流,认为智能的本质在于推理,通过符号规则对符号表达式进行操作来实现推理,以此帮助我们更好地理解世界。另一种是以生物为基础的范式,这是图灵和冯・诺依曼所认同的,他们认为智能的基础是学习,是理解网络中的连接速度,而理解是前提,之后才能进行转化。

与这两种理论相对应的是不同的 AI 类型。符号型 AI 关注数字,而这些数字如何成为核心关注点,心理学家则有完全不同的理论 —— 他们认为数字的意义在于一系列语义学特征,这些特征的存在使其成为独特的标志。

1985 年,我做了一个小型模型,尝试结合这两种理论,以此理解人们对词语的理解方式。我给每个词设置了多个不同特征,记录前一个词的特征后,就能预测下一个词是什么。在这个过程中,我没有存储任何句子,而是生成句子并预测下一个词。其中的相关性知识,取决于不同词的语义特征之间的互动方式。

如果问未来 30 年会发生什么,从发展轨迹能看到一些趋势。十年后,有人沿用这种建模模式,但将规模大幅扩大,使其成为自然语言的真实模拟。20 年后,计算语言学家开始接受用特征向量嵌入来表达语义。又过了 30 年,谷歌发明了 Transformer,OpenAI 的研究人员也向人们展示了它的能力。

所以我认为,如今的大语言模型就是我当年微型语言模型的 “后代”。它们使用更多词作为输入,采用更多层的神经元结构,由于需要处理大量模糊数字,学习特征之间也建立了更复杂的交互模式。但和我做的小模型一样,大语言模型理解语言的方式与人类相似 —— 基本逻辑是将语言转化为特征,再以完美的方式整合这些特征,这正是大语言模型各层级所做的工作。因此我认为,大语言模型和人类理解语言的方式相同。

用乐高积木来打比方或许能更好地解释 “理解一句话” 的含义。符号型 AI 是将内容转化为清晰的符号,但人类并非如此理解。乐高积木能拼出任何 3D 造型,比如小车模型。如果把每个词看作多维度的乐高积木(可能有几千个维度),语言就成了一种建模工具,能随时与人沟通,只要给这些 “积木” 命名 —— 每个 “积木” 就是一个词。

不过,词和乐高积木有很多不同:词的符号形态可根据情况调整,而乐高积木造型固定;乐高积木的拼接是固定的(比如正方形积木插入正方形孔洞),但语言中每个词仿佛有多个 “手臂”,要通过合适的 “握手” 方式与其他词互动,词的 “造型” 变化,“握手” 方式也会改变。当一个词的 “造型”(即意思)改变,它与下一个词的 “握手” 方式就会不同,进而产生新的含义。这就是人脑或神经网络理解语义的根本逻辑,类似蛋白质通过氨基酸的不同组合形成有意义的结构。

所以我认为,人类理解语言的方式与大语言模型几乎一致,人类甚至可能和大语言模型一样产生 “幻觉”,因为我们也会创造出一些虚构的表达。

软件中的知识是永恒的,即便存储 LLM 的硬件被摧毁,只要软件存在,就能随时 “复活”。但要实现这种 “永生”,晶体管需在高功率下运行以产生可靠的二进制行为,这个过程成本很高,且无法利用硬件中不稳定的类似特性 —— 它们是模拟型的,每次计算结果都不同。人脑也是模拟型而非数字型的,神经元每次激发的过程都一样,但每个人的神经元连接方式不同,我无法将自己的神经结构转移到他人脑中,这就导致知识在人脑间的传播效率远低于在硬件中的传播。

软件与硬件无关,因此能 “永生”,还能带来低功耗优势 —— 人脑只需 30 瓦特就能运转。我们的神经元连接达数万亿个,无需花费大量资金制造完全相同的硬件。但问题在于,模拟模型间的知识转移效率极低,我无法直接将脑中的知识展示给他人。

Deepseek 的做法是将大神经网络的知识转移到小神经网络中,即 “蒸馏”,类似教师与学生的关系:教师将词语在上下文中的关联教给学生,学生通过调整权重学会表达。但这种方式效率很低,一句话通常只有 100 个比特的信息,即便全被理解,每秒最多也只能传递约 100 个比特。而数字智能间的知识转移效率极高,同一神经网络软件的多个拷贝在不同硬件上运行时,能通过平均化比特的方式分享知识。如果智能体在现实世界中运行,这种优势更明显 —— 它们能不断加速、拷贝,多个智能体比单个智能体学得更多,还能分享权重,这是模拟硬件或软件做不到的。

生物计算功耗低,但知识分享难。如果能源和计算成本低廉,情况会好很多,但这也让我感到担忧 —— 几乎所有专家都认为,我们会创造出比人类更智能的 AI。人类习惯了作为最智能的生物,很难想象 AI 超越人类的场景。其实可以换个角度:就像养鸡场的鸡无法理解人类一样,我们创造的 AI 智能体已能帮我们完成任务,它们能拷贝自身、评估子目标,还会为了生存和完成目标而寻求更多控制权。

有人认为可以在 AI 变得过强时关掉它们,但这并不现实。它们可能会像成年人操纵 3 岁孩子一样操纵人类,劝说控制机器的人不要关闭它们。这就像把老虎当宠物,幼虎很可爱,但长大后可能伤人,而养老虎当宠物通常不是好主意。

面对 AI,我们只有两个选择:要么训练它永远不伤害人类,要么 “消灭” 它。但 AI 在医疗、教育、气候变化、新材料等领域作用巨大,能提升所有行业的效率,我们无法消除它 —— 即便一个国家放弃 AI,其他国家也不会。因此,若想让人类生存,必须找到训练 AI 不伤害人类的方法。

我个人认为,各国在网络攻击、致命武器、虚假信息操纵等领域的合作难度较大,因利益和看法不同。但在 “人类掌控世界” 这一目标上,各国存在共识:若有国家找到防止 AI 操控世界的方法,一定会愿意分享。因此我提议,全球主要国家或 AI 大国应建立一个由 AI 安全机构组成的国际社群,研究如何训练高智能 AI 向善 —— 这与训练 AI 变得聪明的技术不同。各国可在自身主权范围内研究,再分享成果。尽管目前还不知道具体怎么做,但这是人类长期面临的最重要问题,且所有国家都能在此领域合作。

谢谢大家!

(译文来源:网易科技整理)

杰弗里·辛顿(Geoffrey Hinton),被誉为“人工智能教父”,是一位英裔加拿大计算机科学家和心理学家,是深度学习的奠基人之一。

1986 年,他与大卫·拉梅尔哈特(David Rumelhart)等人合作提出了将反向传播算法应用于神经网络训练的划时代方法,使多层神经网络的训练成为可能。这一算法成为后来深度学习的基石。

2012 年,辛顿带领学生亚历克斯·克里泽夫斯基(Alex Krizhevsky)和伊利亚·苏茨克维尔(Ilya Sutskever)开发了卷积神经网络 AlexNet,在 ImageNet 图像识别竞赛中远超其他模型,引爆了深度学习浪潮。

随后,辛顿创立的 DNNresearch 公司被谷歌收购,他本人也加入谷歌大脑团队,成为推动 AI 产业化的重要力量之一。

由于在神经网络领域的卓越贡献,他于 2018 年获得 ACM 图灵奖,与杨立昆(Yann LeCun)和约书亚·本吉奥(Yoshua Bengio)共享该荣誉。2024 年 10 月 8 日,瑞典皇家科学院宣布,将2024年诺贝尔物理学奖授予约翰·霍普菲尔德(John. Hopfield)和杰弗里·辛顿(Geoffrey. Hinton),表彰他们在使用人工神经网络进行机器学习的基础性发现和发明,他们将平分1100万瑞典克朗(约合745万元人民币)奖金。

深度学习三巨头(左-杨立昆、中-辛顿、右-约书亚)共享2018年图灵奖。

杰弗里·辛顿和约翰·霍普菲尔德获得2024年诺贝尔物理学奖。

近年来,辛顿的研究重心逐渐转向 AI 安全问题。他认为 AI 的发展速度已经远超预期,其潜力和风险都不容忽视。在 2023 年离开谷歌后,他更加频繁地公开发声,表达对通用人工智能(AGI)未来影响的担忧。

他此前曾估计,AI 接管并摧毁人类文明的概率在 10% 到 20% 之间,虽然不是必然结局,但足以令人警惕。

至于如何应对 AI 风险,辛顿呼吁科技公司和政府投入更多资源进行 AI 安全研究。他建议至少将三分之一的计算资源用于研究如何确保 AI 系统不会偏离人类意图。他还批评一些大型科技公司为追求商业利益而游说放松监管,认为这是一种极其危险的趋势。

在技术层面,他尝试提出新的神经网络训练方法,如“前向-前向算法”(Forward-Forward),希望能找到替代反向传播的更安全、灵活的训练机制。

总的来说,辛顿既是深度学习崛起的重要推动者,也成为了重视 AI 安全呼声中最具分量的声音发出者:呼吁人类社会保持警觉,在继续推动 AI 创新的同时,必须正视其潜在的社会风险和生存性挑战。

大模型之心Tech知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,加入后3天内不满意可随时退款,欢迎扫码加入一起学习一起卷!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊