EvaLearn:AI下半场的全新评测范式!

- 2025-07-28 18:45:32

在三个月前,OpenAI 研究员 Shunyu Yao 发表了一篇关于 AI 的下半场的博客引起了广泛讨论。他在博客中指出,AI 研究正在从 “能不能做” 转向 “学得是否有效”,传统的基准测试已经难以衡量 AI 的实际效用,他指出现有的评估方式中,模型被要求独立完成每个任务,然后取平均得分。这种方式忽略了任务之间的连贯性,无法评估模型长期适应能力和更类人的动态学习能力。

图出自 Shunyu Yao Blog:The second half

什么是更类人的动态学习能力?不妨想象一下,一位学生在做数学题时,通过前面题目的解答经验,逐渐掌握更高效的解题方法,在后续题目中表现越来越好。这种在实践中不断优化策略、提升能力的过程,正是人类智能灵活性与适应性的体现。

而对于 LLM 而言,能否具备类似的 “成长” 能力,关乎其能否真正迈向通用人工智能的殿堂。但长期以来,由于缺乏有效的评估手段,这一重要维度始终隐藏在迷雾之中。

来自复旦大学自然语言处理实验室和字节跳动 Seed 等单位的研究人员,共同提出了一种全新的大模型评测范式:EvaLearn —— 一个评估大模型学习能力与学习效率的开创性基准,为理解模型的类人学习潜力提供了全新视角。

作为首个专注于量化 LLM 学习能力与效率的基准,EvaLearn 以「连续问题求解」为核心,重新定义了大语言模型的评估逻辑。目前该项目开源仅一个月,官方仓库的星标数便突破 400+,让我们来看看这个工作为何广受关注。

论文链接:https://arxiv.org/pdf/2506.02672

项目链接:https://github.com/ByteDance-Seed/EvaLearn

传统基准的局限显而易见:它们将问题视为孤立样本,模型无法从之前的解答中积累经验,自然也无从评估其「学习效率」与「适应能力」。

EvaLearn 从零构建了 648 个具有挑战性的问题,将这些问题组织为 182 个序列,每个序列包含来自同一任务类型的 7 个问题,要求模型按顺序求解 —— 前序问题的经验,将直接影响后续表现的评估。

图 1 EvaLearn 的评估流程

在评测方面,如上图所示 ,EvaLearn 不采用并行评估方式,而是要求模型按顺序解决问题,从而系统地评估大语言模型(LLM)的学习能力和效率。

这 648 个高难度问题覆盖六大核心任务:

摘要(Sum):评估模型能否通过利用先前经验提高总结的准确性和覆盖范围;

分类(Cla):评估模型从解决一系列分类问题中提升其分类技能的能力;

信息抽取(Ex):衡量模型能否逐步提高关键信息提取的准确性和完整性;

逻辑推理(LR):测试模型能否从先前错误中学习并提高逻辑推理能力;

数学推理(MR):检验模型能否通过利用早期问题的反馈快速掌握数学解题方法;

序列推理(SR):评估模型能否通过从历史经验中学习来增强其解决基于序列问题的能力,包括理清事件步骤和推理逻辑。

每个问题都配有一个由专业标注员编写的细致评分标准(rubric),结合 GPT-4o 作为「验证器」,来判断模型生成的答案的正确性。经过大量实验,基于 rubric 的验证器,在评价各种水平的模型时,评估准确率均超过 95%。这实现了高效的自动化评测。

研究团队 EvaLearn 上对九个前沿大语言模型进行了全面研究,总结了几个关键发现:

(1) 模型在不同任务类型中展现出多样的学习能力。大部分模型通常更擅长利用先前经验来解决涉及数学和逻辑推理的任务,而诸如总结之类的任务则更倾向于依赖在预训练期间获取的知识以及模型的固有能力。此外,不同任务的学习效率也有显著差异。

(2) 基于思维链的大语言模型在学习能力和学习效率上通常优于非基于思维链的大语言模型。它们能更好地利用经验解决新问题,并且表现出更高的学习稳定性,更有可能在一系列任务中连续解决多个问题。

(3) 反馈学习(即将来自验证器的评价和反馈作为上下文提供)能让模型借助对先前解决方案的反馈及基于评分标准的评估来优化问题解决,显著提升学习能力与效率。相较于示例学习(指将先前的问题和规范解决方案作为上下文提供),反馈学习的效果更为显著。

(4) 学习能力和学习效率的指标共同提供了对模型学习潜力的全面评估,两种动态能力与静态模型能力没有很强的相关性。即使是静态性能较高的大语言模型,也并非在所有任务的学习能力上都具有明显优势。

评估指标

为了评价模型的学习能力和学习潜力,EvaLearn 设计了一套全面的评估指标体系,从多个维度刻画模型的动态学习能力:

整体序列准确率(Acc):连续任务中,模型答对的总题数占总题数的比例,直接反映整体表现,值越高越好。

准确率曲线斜率(k):通过拟合各位置的准确率变化曲线,斜率 k 体现学习速度 ,k 越大,说明模型从前期问题中学习越快,后续准确率提升越明显。

首次正确位置(P_first):模型第一次答对问题的位置,P_first 值越小,说明越快找到解题思路。

连续正确次数(N_consec):用于评估模型学习的稳定性与经验复用能力。模型连续答对的题数,值越高,说明学习稳定性越强,能更好复用已有经验。

热身后准确率(Acc_pw-K):该指标重点关注模型在经过一定数量问题的 “热身” 后,积累了一定经验时的准确率表现。它体现了模型在适应任务、积累经验后的实际适应与提升水平,排除了模型初始状态对整体评估的干扰。

大模型在 EvaLearn 上的表现

研究人员们比较两种问题求解范式:并行求解和顺序求解,以研究大语言模型的学习能力和效率。

并行求解(Parallel Solving)

零样本(Zero-shot):模型独立地解决每个问题,无法访问之前问题的任何经验。这种设置与多数现有基准测试方法一致,评估模型在无学习机会下解决复杂问题的固有能力。

少样本(Few-shot):针对每个问题,模型会获得三个来自同一任务的示例(即 3-shot),以指导输出格式和解题方法。每类任务内的问题共享相同的示例。

顺序求解(Sequential Solving)

示例学习(Demonstration Learning):在解决当前问题之前,模型会获得同一序列中之前所有问题及其标准答案,类似于上下文学习。

反馈学习(Feedback Learning):在解决当前问题时,模型可以访问之前所有问题、它们的解答以及针对模型自身前次解答的详细反馈。这些反馈是由评审使用实例级评分标准生成的。本设置评估模型是否能利用自身经验改善随后的表现。系统提示如图 22 所示。

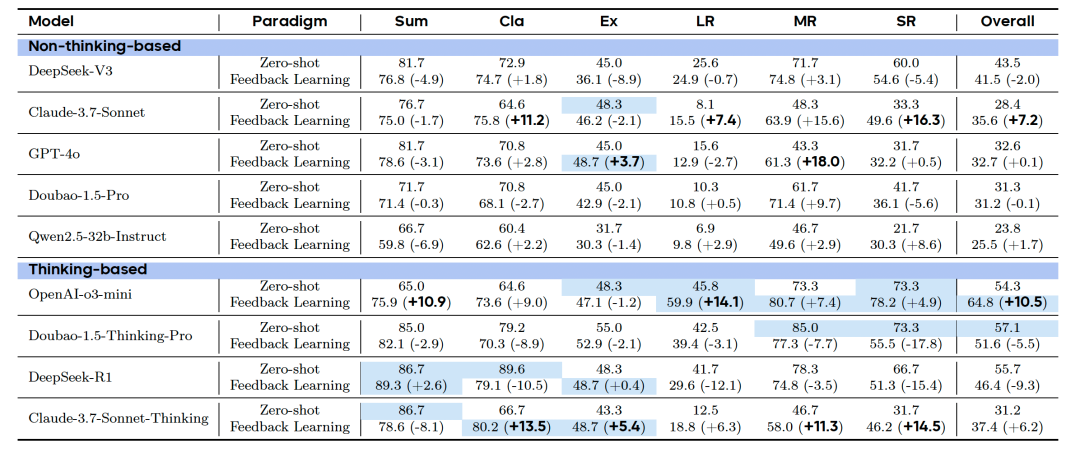

研究者在所有实验中评估了九个最前沿的 LLMs,包括 “思维型” 和 “非思维型” 模型,结果如表 1。

表 1: 反馈学习与零样本并行求解之间的整体准确率差异

研究问题一:

LLMs 能否通过问题序列进行学习?

发现一:

LLMs 在从问题序列中学习的能力存在差异,且这种差异不仅体现在模型之间,也体现在任务类型之间。此外,大多数模型在 “热身阶段” 后表现更佳。

表 1 总结了反馈学习与零样本并行求解之间的整体准确率差异。研究者观察到,有五个模型从顺序学习中获益,有四个模型表现略有下降,思维型模型在表现上变化更显著,例如 OpenAI-o3-mini 在整体上提升了 +10.5%,为提升幅度最大者。这说明某些模型可以有效利用先前的经验来解决同一任务中的问题。

在任务类型方面,大多数 LLMs 在数学推理和分类任务中通过学习获得了提升。但在摘要任务中,大多数模型表现下降(9 个模型中有 7 个下降),这可能是因为摘要任务更依赖模型预训练时获得的知识和指令遵循能力,额外引入的经验反而会干扰模型完成任务。

此外,研究人员还对 “热身后准确率(Acc_pw-K)” 进行了分析,结果发现多数模型在序列后期表现更为出色,特别是思维型模型。这意味着它们能够将早期问题当作练习,不断优化自身,进而提升后续任务的表现,图 3 左侧清晰地展现了这一现象。

图 2 左侧为 Claude-3.7-Sonnet-Thinking 的热身后准确率结果,右侧为 DeepSeek-R1 的逐位置准确率结果

发现二:

学习稳定性在不同任务和模型之间差异显著。 对于某些任务(如摘要),当前的模型更擅长利用其固有知识来解决问题,而不是依赖从先前问题中获得的经验。

图 3 左侧为连续正确解的平均数量(N_consec),右侧为首次正确解的平均位置(P_first)。结果以 OpenAI-o3-mini 为例展示,每个节点代表一个序列。

研究者通过分析 N_consec 指标来进一步研究 LLMs 的学习稳定性。图 2 左侧显示了 o3-mini 的结果。图中每个彩色节点代表数据集中的一个问题序列,节点位置越高表示模型在该序列中连续解答正确的问题越多。

结果表明,这一指标在不同任务之间差异明显,对于大多数模型来说,逻辑推理任务上更难连续做对题目。

在思维型模型与非思维型模型之间,这一指标的表现也存在显著差异。结果发现思维型模型相比非思维型模型通常具有更高的连续正确解答数。这说明思维型模型不仅更能从先前经验中受益提升表现,还能保持更高的稳定性,更有可能连续解答多个相关问题。

有趣的是,在摘要任务中,模型的 N_consec 值较高,但 Acc_pw-K 却明显下降,这表明其在序列后期的问题上表现反而不如前期问题。这意味着在此类任务中,连续解题能力可能更多依赖模型固有的知识和静态能力,而不是从序列中学习到的经验。

发现三:

学习能力为评估模型提供了一个独立于静态性能的新视角,揭示了其潜在的学习能力。

表 2 结果进一步表明,并行解题的高表现不代表学习能力优异。逻辑推理任务中,Claude-3。7-Sonnet-Thinking 的并行表现不及 DeepSeek-R1 与 Doubao-1。5-Thinking-Pro,但通过反馈学习范式大幅提升;o3-mini 则在两种设置下均表现最佳。再如数学推理任务,DeepSeek-R1 零样本表现优于 o3-mini,却未能从经验中有效学习,反而在反馈学习中性能下降。

值得注意的是,静态能力相近的模型可能学习能力迥异:Claude-3。7-Sonnet-Thinking 与 GPT-4o 在序列推理任务中零样本准确率均为 31。7%,但前者提升 14。5%,后者仅提升 0。5%;而在数学推理中,GPT-4o 的学习能力反超前者。这说明学习能力不仅因模型而异,也因任务而变。

这些发现表明,学习能力是评估模型的重要独立维度,与静态性能无关且具有任务差异性。研究者在问题三中进一步分析不同学习范式下的模型表现,为该结论提供了更多佐证。

研究问题二:

大语言模型在从一系列问题中

学习的效率如何?

图 4 所有模型和任务在反馈学习中拟合的逐位置准确率曲线斜率(k)结果

发现四:

不同模型和任务类型之间的学习效率存在显著差异。

总体而言,多数非思维型模型在经验积累中进步更快,思维型模型则表现出更稳定的收益。

图 2 右侧呈现了 DeepSeek-R1 的逐位准确率曲线,图 4 热图则汇总了这些曲线的斜率(k),直接反映模型学习效率。研究发现,多数非思维型模型的逐位准确率曲线斜率更陡峭,这可能与其起始性能较低、更易抓住 “低垂的果实” 有关。相比之下,思维型模型的学习过程更稳定。这表明思维型模型更擅长利用先前问题的信息(包括评判模型反馈),从而实现更高效的推理与更稳定的性能提升。

此外,多数模型在数学推理任务中展现正向学习效率,但在顺序推理任务上普遍出现性能下降,这说明即便在有明确解题路径与反馈的推理任务中,学习效率也会因任务特性产生显著差异,受多重因素影响。

因此,我们可以得出结论:模型的学习效率受静态能力、任务类型与推理方法共同影响:非思维型模型借助经验实现快速提升,思维型模型则以更稳定的方式持续进步。

研究问题三:

不同的学习方式

是否会带来性能差异?

发现五:

不同的解题方式会显著影响模型性能。

模型可通过示例学习积累经验,反馈学习则能进一步强化其学习能力。值得注意的是,学习能力与模型的静态能力并无强相关性。

图 5 呈现了模型在四种解题方法下的表现。研究者发现,对多数模型而言,示例学习的效果通常优于并行的少样本学习。以 Claude-3。7-Sonnet-Thinking 为例,其在五个任务中相较于少样本设置均实现持续提升。这背后的关键原因在于,示例学习让模型能够访问序列中所有先前问题及标准答案,进而从过往经验中有效学习。

图 5 四种求解方法的整体准确率对比,包括两种并行方法(即零样本和少样本)与两种序列方法(即示例学习和反馈学习)

此外,图 6、7、8 比较了模型采用反馈学习与示例学习两种学习范式后在热身后准确率(Acc_pw-K)和斜率 k 方面的差异。结果表明,对于大多数模型,反馈学习比示例学习能获得更高的平均总体准确率和更大的学习效率。

图 6 所有模型和任务中,反馈学习与示例学习的斜率差异(Δk)热图

图 7 反馈学习(上)和示范学习(下)的热身后准确率(Acc_pw-K)结果

值得注意的是,每个大模型在某些任务中都表现出较强的学习能力,但没有任何模型能在所有任务中始终实现稳定的学习提升。这些结果表明,每个模型都有其优势,学习能力与静态表现之间并不强相关。因此,学习能力和效率提供了一个评估模型表现的新视角,有助于理解当前模型与人类能力之间的差距。

发现六:

首个正确解答的位置平均值(P_first)在不同模型和任务之间存在差异,这一指标揭示了模型的学习潜力。

研究人员们还分析了首个正确解答的位置平均值 P_first,发现这一指标对于不同任务之间的模型表现差异很大。例如,在逻辑推理序列中,大多数模型都难以早期解出首个问题,只有 o3-mini 和 Doubao-1。5-Thinking-Pro 能持续取得早期成功。九个模型中有七个在有反馈的情况下,能更早解出问题。

这表明,与仅提供标准答案相比,反馈更能促进模型学习和掌握任务。例如,在逻辑推理任务中,o3-mini 有时在只使用示例学习时无法解出任何问题,但在使用反馈学习后,能在每个序列中至少解出一个问题。因此,P_first 能综合反映模型的静态能力、学习能力和学习速度,从而揭示其学习潜力。

结语

研究人员们提出了 EvaLearn,这是一个新颖的基准测试框架,用于在特定任务中对模型的学习能力和效率进行序列化评估。

EvaLearn 配备了一套全面的评估指标,揭示了在多种任务中,包括依赖思维过程和不依赖思维过程的任务,前沿模型之间显著的性能差异,这些指标从多个角度全面评估了模型的学习表现。EvaLearn 提供了更现实、动态的评估方式,帮助研究人员更好地理解模型与人类之间的差距,推动更强大模型的发展。

此外,研究者发现,尽管某些模型能够有效利用教师模型对先前解答的反馈来提升学习效果,但另一些模型却难以从这类反馈中获益。EvaLearn 为评估大型语言模型的潜力提供了新的视角,是迈向动态评估的重要开创性一步。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊