【AI加油站】第三十二部:一本醍醐灌顶的教科书!《大语言模型提示工程:构建LLM应用的艺术与科学》(附下载)

- 2025-07-18 08:00:00

《Prompt Engineering for LLMs》(作者 John Berryman 和 Albert Ziegler)是一本聚焦大语言模型(LLM)提示工程的实践指南,涵盖从基础理论到高级应用的全流程,旨在帮助开发者掌握构建 LLM 驱动应用的核心技术。以下是全书核心内容总结:

第一部分:基础(Foundations)

1. 提示工程导论(Introduction to Prompt Engineering)

- LLM 的本质

:LLM 核心是文本补全引擎,通过预测下一个 token 生成内容,其能力源于对海量训练数据的模仿。 - 提示工程定义

:通过构建 “提示(Prompt)” 引导 LLM 生成符合需求的输出,本质是将用户问题转化为 LLM 可理解的文本格式。 - 发展历程

:从早期语言模型(如 GPT-1)到 GPT 系列的演进,揭示 LLM 能力的爆发(如 GPT-3 的少样本学习),提示工程成为解锁 LLM 潜力的关键。

2. 理解 LLMs(Understanding LLMs)

- 核心原理

:LLM 通过 tokenizer 将文本拆分为 token,以自回归方式逐 token 生成内容,依赖注意力机制捕捉序列依赖。 - 关键特性

: - 幻觉(Hallucinations)

:因训练数据限制或模式模仿,可能生成看似合理但错误的内容。 - token 限制

:上下文窗口有限,需关注 token 计数以避免超限。 - 温度(Temperature)

:控制输出随机性(0 为确定性,1 为多样性,>1 易产生混乱)。 - 与人类思维的差异

:LLM 无内部独白,无法 “反思”,处理文本依赖预训练模式,对字符级操作(如拼写检查)能力较弱。

3. 从文本补全到聊天模型(Moving to Chat)

- 模型演进

:从基础文本补全模型到聊天模型的转变,核心是通过人类反馈强化学习(RLHF) 实现对齐(Helpful、Honest、Harmless)。 - RLHF 流程

:

基于基础模型微调得到监督微调模型(SFT); 训练奖励模型(RM)对 SFT 输出排序; 用 PPO 算法基于 RM 分数优化 SFT,得到 RLHF 模型。

<|im_start|>和<|im_end|>标记系统、用户、助手角色,明确对话结构,避免提示注入。4. LLM 应用设计(Designing LLM Applications)

- 核心循环

:应用本质是 “用户问题→转化为 LLM 输入→模型补全→转化为用户解决方案” 的闭环。 - 关键步骤

: 收集用户问题相关上下文(静态规则 + 动态信息); 组装提示(遵循 “小红帽原则”,模仿训练数据中的文档结构); 处理模型输出(解析、转换为用户可理解的结果)。 - 复杂性扩展

:支持多轮对话(需维护状态)、集成外部工具(如检索增强生成 RAG)、复杂推理(如思维链)。

第二部分:核心技术(Core Techniques)

5. 提示内容(Prompt Content)

- 内容来源

: - 静态内容

:固定规则、任务说明、少样本示例(Few-shot Prompting),用于明确任务目标。 - 动态内容

:用户输入、上下文信息(如历史对话、检索到的文档),需根据场景动态获取。 - 关键技术

: - 检索增强生成(RAG)

:通过检索外部文档(如向量数据库)补充上下文,减少幻觉。 - 分层摘要

:长文本通过多轮摘要压缩,适配上下文窗口。

6. 提示组装(Assembling the Prompt)

- 理想结构

:引言(明确任务)→上下文(静态 + 动态内容)→重定向(聚焦核心问题)→过渡(引导模型输出)。 - 组装原则

: - 位置效应

:重要信息放在开头或结尾(避免 “中间遗忘”); - 内容优先级

:过滤冗余信息,优先保留高相关性内容; - 格式一致性

:使用 Markdown、XML 等结构化格式,便于模型解析。

7. 模型控制(Taming the Model)

- 输出格式控制

:通过明确起止标记(如 ### 结论)、停止序列(Stop Sequences)控制输出范围。 - 置信度利用

:通过 logprobs 分析模型对每个 token 的置信度,评估输出可靠性(如低置信度时触发二次验证)。 - 模型选择

:根据任务需求(精度、速度、成本)选择模型(如小模型用于简单分类,大模型用于复杂推理),必要时微调(如 LoRA)。

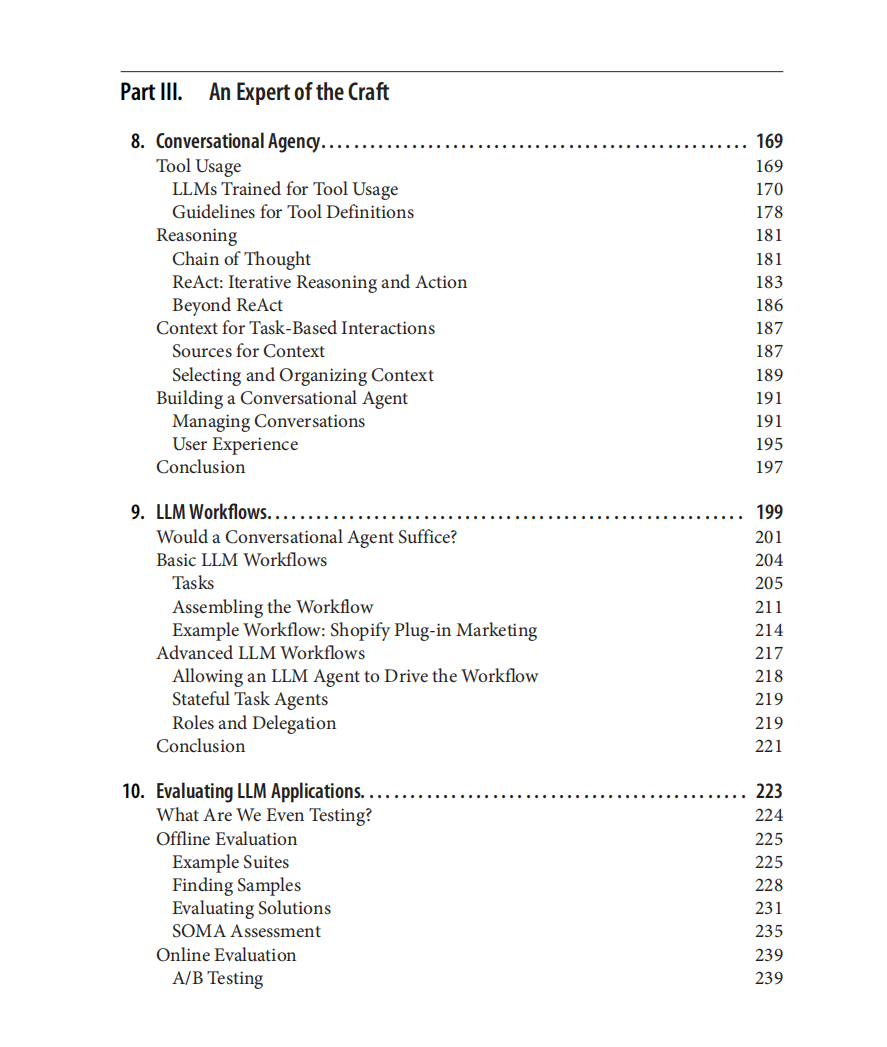

第三部分:高级技巧(An Expert of the Craft)

8. 对话代理(Conversational Agency)

- 工具使用

:为 LLM 配备外部工具(如 API 调用、检索),通过结构化指令(如函数定义)引导模型调用工具,解决 LLM 知识滞后、计算能力弱等问题。 - 推理增强

: - 思维链(Chain of Thought)

:引导模型分步推理(如 “Let’s think step-by-step”),提升复杂问题解决能力。 - ReAct 框架

:结合 “思考 - 行动 - 观察” 循环,迭代使用工具获取信息并推进任务。

9. LLM 工作流(LLM Workflows)

- 任务分解

:将复杂任务拆分为子任务(如数据收集→分析→生成),通过工作流串联,提升可靠性。 - 高级工作流

: - 有状态任务代理

:每个子任务由专用代理处理,维护自身状态并协作。 - 角色与委派

:模拟团队协作(如 “分析师→决策者→执行者”),通过多代理分工解决复杂问题。

10. LLM 应用评估(Evaluating LLM Applications)

- 离线评估

:通过示例集(人工或生成)测试模型输出,采用黄金标准匹配、功能测试(如代码可运行性)、LLM 自评等方法。 - 在线评估

:通过 A/B 测试收集用户反馈(如点击率、满意度),监控关键指标(响应时间、token 消耗)。 - 核心目标

:验证应用在真实场景中的有效性,平衡精度、效率与成本。

核心价值

本书强调 “LLM 本质是文本补全引擎”,提示工程的核心是通过构建符合训练数据模式的提示,引导模型生成可靠输出。从基础提示设计到复杂工作流与代理系统,提供了一套完整的实践框架,帮助开发者高效构建 LLM 应用,平衡性能、可靠性与用户体验。

本书免费下载地址

关注微信公众号“人工智能产业链union”回复关键字“AI加油站32”获取下载地址。

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)

声明:本文内容及配图由入驻作者撰写或合作网站授权转载。文章观点仅代表作者本人,不代表科技区角网立场。仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

点击这里

扫码添加微信

扫码添加微信

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊