字节跳动Seed实验室ByteDexter灵巧手:解锁人类级灵巧操作

- 2025-07-08 16:52:22

摘要

Abstract

复制人类水平的灵巧性仍然是一项基本的机器人挑战,需要从机电一体化设计到高自由度(DoF)机械手控制的集成解决方案。虽然模仿学习有望将人类的灵巧性转移到机器人身上,但经过训练的策略的有效性取决于人类演示数据的质量。我们通过手臂远程作系统弥合了这一差距。

来源:https://byte-dexter.github.io/

该系统具有:

(1) 用于仿生灵巧性的 20-DoF 联动驱动的拟人化机械手;

(2) 基于优化的运动重定向,用于实时、高保真地再现复杂的人类手部动作和无缝的手臂协调。

我们通过广泛的实证评估来验证该系统,包括灵巧的手部作任务和一项需要组织一个杂乱的化妆台随机填充九个物体的长期任务。实验结果表明,其直观的远程作界面具有实时控制功能,并能够生成高质量的演示数据。

方法

ByteDexter 是由字节跳动 Seed 开发的拟人化灵巧之手。它具有 20 个自由度 (DoF),其中 15 个完全驱动 DoF。手掌内 15 个电机和嵌入式板的无缝集成使 ByteDexter 能够作为独立的手动模块运行。指尖和手掌均采用专用设计,便于集成触觉传感器。

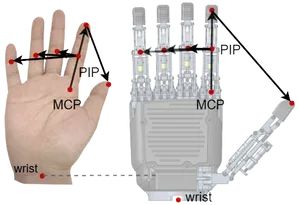

ByteDexter 的手指设计采用并联串行运动结构:2-DoF MCP 关节、1-DoF PIP 关节和被动驱动的 1-DoF DIP 关节复制了人类食指、中指、无名指和小指的运动学。其新颖的拇指设计将 MCP 关节的两个 DoF 解耦,扩大了工作空间并增强了精确抓取性能。

ByteDexter 手:

(a) 具有 2-DoF MCP 关节的机器人手指,具有被动驱动的 1-DoF DIP 关节;

(b) 拇指的运动结构;

(c) 具有拇指外展/内收的 ByteDexter 手。

手臂遥控系统

远程作界面包括一个用于跟踪手腕姿势的 Meta Quest 3 耳机和一个用于手部动作的 Manus Quantum Metaglove。Quest 控制器通过定制支架安装在 Manus 手套的背面,以确保同步跟踪手腕和手指的运动。在机器人侧,ByteDexter 手安装在 Franka Research 3 (FR3) 手臂上,其手腕-指尖轴与手臂的第七关节对齐。Quest 头戴式设备捕获的作员手腕姿势直接映射到 FR3 末端执行器,而 Manus 手套的手部动作则重新定位到 ByteDexter 手部的关节位置命令中。

手臂远程作系统概述

手部动作重定向

我们通过解决一个优化问题,将机器人和人手中相应键向量之间的差异降至最低,将从 Manus 手套获得的人手姿势数据重新定位到 ByteDexter 手的关节位置参考中。

上图仅显示用于说明的食指键向量。从 thumb 到 pinky 迭代此过程并消除重复项,将生成 15 个唯一的键向量。将这些关键向量纳入优化可以捕获大多数抓取类型:对于捏抓取,最小化手指间的距离会对齐机器人和人手的姿势,以减少作员的压力;对于力量抓取,优先考虑保持指尖到手掌的距离。

结果

手部作结果

我们评估了三个规范的手部作原语:

(i) 重新抓取以在手指之间平移对象;

(ii) 相对于手掌滑动对象;

(iii) 旋转对象或其组件,并在四个基准任务中实例化它们:(1) 将瓶子从精确抓取重新抓取到强力抓取;(2) 多物体抓取;(3) 拧开盖子;(4) 按压式盖子。

长视距远程作结果

为了评估长期远程作能力,我们使用表组织任务评估了该系统。该场景的特点是一个杂乱的工作区,里面摆满了随机排列的化妆品和护肤品,以及一个多抽屉的收纳盒。这要求机器人手持系统:

(1) 从桌子上取回物品;

(2) 将物品放入指定的组织者隔间;

(3) 成功打开抽屉并将对象插入其中。

项目链接:https://byte-dexter.github.io

往期文章

全球首篇自动驾驶VLA模型综述重磅发布!麦吉尔&清华&小米团队解析VLA自驾模型的前世今生

具身专栏(三)| 具身智能中VLA、VLN、VA中常见训练(training)方法

具身专栏(二)| 具身智能中VLA、VLN分类与发展线梳理

具身专栏(一)| VLA、VA、VLN概述

π0.5:突破视觉语言模型边界,首个实现开放世界泛化的VLA诞生!

斯坦福&英伟达最新论文:CoT-VLA模型凭"视觉思维链"实现复杂任务精准操控

RoboTwin2.0全面开源!多模态大模型驱动的双臂操作Benchmark ,支持代码生成!

开源!Maniskill仿真器上LeRobot的sim2real的RL训练代码开源(附教程)

迈向机器人领域ImageNet,大牛PieterAbbeel领衔北大、通院、斯坦福发布RoboVerse大一统仿真平台

CVPR 北大、清华最新突破:机器人操作新范式,3.3万次仿真模拟构建最大灵巧手数据集

人形机器人四级分类:你的人形机器人到Level 4了吗?(附L1-L4技术全景图)建议收藏!

斯坦福最新论文:使用人类动作的视频数据,摆脱对机器人硬件的需求

爆发在即!养老机器人如何守护2.2亿老人?产业链+政策一览,建议收藏!

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊