AAAI 2025 | Multi-to-Single: 通过对比学习降低情感识别中的多模态依赖性

- 2025-07-27 08:30:00

点击蓝字 关注我们

上海交通大学郑伟龙副教授和吕宝粮教授团队在The 39th Annual AAAI Conference on Artificial Intelligence(AAAI 2025,CCF-A)成功接收题为Multi-to-Single: Reducing Multimodal Dependency in Emotion Recognition Through Contrastive Learning 的研究成果。上海交通大学电子信息与电气工程学院硕士研究生Yan-Kai Liu为第一作者,郑伟龙副教授为通讯作者。

成果简介

多模态情感识别是情感脑机接口领域的一个重要研究领域。然而,在实际应用中,同时获取所有模态通常具有挑战性。为了解决这个问题,研究人员专注于使用跨模态方法来学习模态数据较少时的多模态表示。然而,由于不同模态分布存在显着差异,使任意模态充分学习多模态特征是具有挑战性的。

为了解决这个限制,本文提出了一种Multi-to-Single(M2S)情绪识别模型。该模型利用对比学习技术并结合了两个创新模块:(1)空间和时间稀疏(STS)注意力机制,增强了编码器从数据中提取特征的能力;(2)一种新颖的Multi-to-Multi对比预测编码(M2M CPC),能够学习和融合不同模态的特征。在最终测试中,本文仅使用单一模态进行情感识别,降低模型对多模态数据的依赖。

在五个公共多模态情感数据集上的测试结果表明,M2S模型在跨模态任务中实现了最先进的性能,并且仅使用单一模态数据就能取得多模态数据相当的性能。

主要贡献

本文提出了一种用于跨模态情感识别的M2S模型,该模型可以减少对多模态数据的依赖,同时使用单一模态数据实现多模态性能。

本文引入了两个新的模块:STS 注意力机制和 M2M CPC。前者可以充分利用脑电数据,而后者可以学习和融合不同模态的特征,帮助现有模型取得更优性能。

本文系统地评估了M2S模型在多个数据集和模态上的性能,包括 EEG-EYE、EEG-ECG 和 EEG-PPS。大量的实验结果表明,M2S模型具有良好的鲁棒性。

数据准备

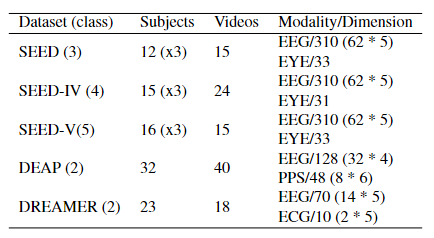

表1 五个公共多模态情感数据集的基本信息

方法

在M2S情绪识别模型中,训练阶段只需要成对的、未标记的多模态数据,同时可以使用下游任务的单模态数据微调模型。在预训练期间,情感相关 (ER) 和情感无关 (EI) 编码器使用两个不同的编码器提取特征,并最小化它们之间的互信息。对于使用电极收集的EEG、ECG和PPS数据,提出了一种新的时空稀疏(STS)注意机制,以充分利用数据的连续时间和空间特征。对比学习方法用于融合和对齐不同模态的特征,包括改进的Multi-to-Multi对比预测编码(M2M CPC)。

图1 Multi-to-Single 框架。(a)预训练阶段。黄色和绿色模块分别表示对应于不同模态的数据和关键结构。(b) 模型的微调阶段。在这个阶段,冻结其对应的编码器,只优化新添加的分类器。(c)空间和时间稀疏注意机制的架构。

STS注意机制模块:由于使用了EEG、ECG 和 PPC多种信号,且这些信号具有以下共性:它们都是通过人体某些固定位置的电极长时间连续采集的。因此,这些信号在空间和时间维度上都具有很强的内部特征。因此提出了STS注意力机制,以充分利用这一特性。STS 注意机制的结构如图1(c)所示。对于任何时间窗口的数据,除了学习电极之间的结构信息外,还在时间维度上融合数据。线性变换后,将相邻时刻和初始时间的值取平均值,此举有两个原因:首先,每个时间窗内的初始数据决定了数据段的基本信息;其次,数据的每一刻都与前一刻密切相关。

图 2 M2M CPC 模块的结构。黄色和绿色块代表不同的模态。

M2M CPC 模块:模块结构如图 2 所示。传统的 CPC 模块通过使用自回归模型预测序列中未来嵌入向量和当前嵌入向量之间的相关性来提取数据特征。人的情绪发生变化,往往会导致人体的多个生理信号同时发生变化。在实际情境中,我们可以通过检测各种生理信号变化来综合判断被试当前的情绪状态,这也是传统多模态模型通常比单模态模型性能更好的重要原因。为了了解不同模态之间的特性,在 M2M CPC 模块中使用来自多个模态的当前嵌入向量来预测每个模态的未来向量。

表2 M2S模型预训练步骤

结果

表 3 SEED、SEED-IV 和 SEED-V 数据集上跨模态和单模态设置下的准确度 (%) 和 kappa 分数 (%)。最佳结果以粗体显示,第二好的结果带有下划线。

表 4 DEAP 和 DREAMER 数据集上跨模态和单模态设置下准确度 (%) 和 F1 分数 (%)。最好的结果以粗体显示,第二好的结果带有下划线。

表 5 与 SEED、SEEDIV 和 SEED-V 数据集上的多模态方法的准确度 (%) 和 kappa 分数 (%)。(S) 表示相同的编码器用于单模态监督学习。

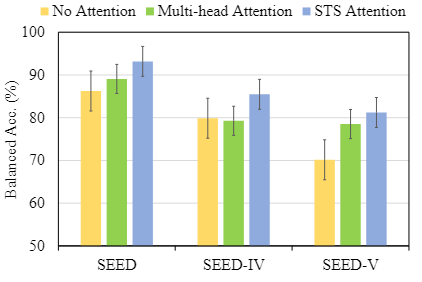

图 3 基于 EEG 微调的 SEED、SEED-IV 和 SEED-V 数据集上不同注意力机制的结果。

图4 添加M2M CPC模块后,SEED、SEED-IV和SEED-V数据集上CLIP和ECO-FET模型的跨模态任务(EEG-EYE)精度变化。

图5 SEED数据集上跨模态任务(EEG-EYE)的热图。每个单元内的值是准确度 (%)。准确率越高,单元的颜色越亮。

研究结论

本文提出了一种用于跨模态学习的新框架 M2S,该方法可以减少情感识别中的多模态依赖性,仅使用单一模态实现多模态性能。对多个数据集进行了各种实验,实验结果表明M2S模型在跨模态任务中取得了SOTA性能。此外,本文所提出的 M2M CPC 模块可以推广到其他模型,以学习和融合不同模态的特征,并帮助现有模型取得更好的性能。

免责声明:原创仅代表原创编译,水平有限,仅供学术交流,如有侵权,请联系删除,文献解读如有疏漏之处,我们深表歉意。

公众号丨智能传感与脑机接口

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊