ICML 2025 多模态 方向Oral论文盘点

- 2025-07-12 22:05:34

作者:InternLM、Qwen 等 LLM

引言:从“能看多模态”到“像人一样思考与感受”

过去两年,多模态大模型(MLLM)在「看得懂」与「说得出」层面取得了令人惊叹的进展,但仍被三大难题卡脖子:

知识瓶颈——幻觉严重,缺乏可检索、可验证的外部知识;

推理瓶颈——跨模态深度推理薄弱,复杂数理与空间问题频频翻车;

情感瓶颈——只能打“开心/难过”标签,难以刻画人类细腻且共现的情绪光谱。

ICML 2025 的四篇 Oral 论文正是针对这三大瓶颈的系统性突破:

SK-VQA 用 200 万合成知识对把「知识增强」做成可复用的数据飞轮;

General-Level & General-Bench 首次给出通才模型的「五级驾照」与 32 万题统考;

EMMA 把数理、化学、代码等硬核推理任务做成跨模态“试金石”;

AffectGPT 提供首个面向 MLLM 的细粒度情感理解全栈方案(数据+模型+评测)。

它们共同勾勒了「多模态通用智能体」的下一站:既能检索知识,又能深度推理,还能理解情绪,向真正的 AGI 迈出关键一步。

巨灵觉醒:SK-VQA——为上下文增强型多模态大模型而生的大规模合成知识库

论文英文标题

SK-VQA: Synthetic Knowledge Generation at Scale for Training Context-Augmented Multimodal LLMs

论文链接

https://icml.cc/virtual/2025/poster/45942

论文中文摘要

SK-VQA 构建了目前最大(200 万+ QA 对)、最多域、最具上下文关联性的知识增强视觉问答数据集。通过 GPT-4 全自动合成,突破传统依赖 Wikipedia 的局限,支持任意来源图像与合成知识文档配对,显著扩展了领域与问题多样性。实验表明,该数据集既是挑战性基准,又能有效训练多模态大模型完成知识增强生成,显著提升跨域泛化与 RAG 场景表现。

文章推荐理由

SK-VQA 以「合成数据+知识增强」双轮驱动,解决了 KB-VQA 领域长期受限于规模、领域与质量的三重瓶颈。11 倍问题多样性、跨域图像来源与人工验证的高质量上下文,使其不仅成为新的 SOTA 基准,更直接赋能多模态 RAG 系统的训练与评测。研究者与工业界可一键下载即用,大幅降低构建知识增强型多模态应用的门槛。

通才之路:General-Level & General-Bench——多模态通才模型的五级量表与百万级评测

论文英文标题

On Path to Multimodal Generalist: General-Level and General-Bench

论文链接

https://icml.cc/virtual/2025/poster/45047

论文中文摘要

本文提出首个系统刻画多模态通才能力的五级分类框架 General-Level,以「协同泛化」为核心评价指标,并配套发布覆盖 700+ 任务、32.5 万实例的超大基准 General-Bench。通过对 100+ 领先 MLLM 的深度评测,揭示当前模型普遍缺乏跨任务/跨模态协同能力,连 GPT-4V 亦未达最高级,为迈向 AGI 指明关键差距。

文章推荐理由

当业界仍用“平均分高=更强”评估 MLLM 时,General-Level 以汽车自动驾驶等级为灵感,首次将「协同泛化」量化分级,并开源迄今最全面的多模态评测平台。无论你是模型开发者还是应用研究者,都能在此找到定位自身系统能力的“通才量尺”,并获得百万级实例的评测支持,为下一代多模态基础模型研发提供路标。

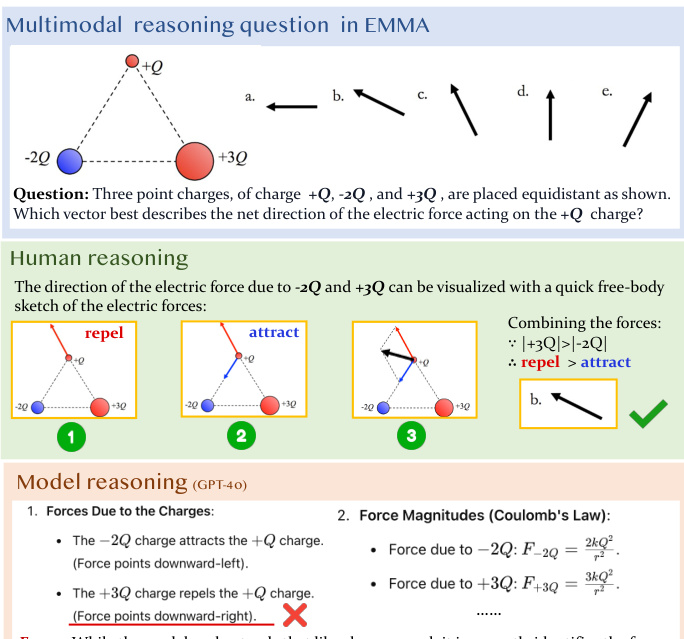

推理试金石:EMMA——检视多模态大模型真正推理能力的跨学科基准

论文英文标题

Can MLLMs Reason in Multimodality? EMMA: An Enhanced MultiModal ReAsoning Benchmark

论文链接

https://icml.cc/virtual/2025/poster/43702

论文中文摘要

EMMA 聚焦数学、物理、化学、编程四大领域,精心构建 2788 道必须同时动用视觉与语言深度推理的难题,其中 1796 道为全新手工设计。对 10 余个 SOTA MLLM 的评测显示:即使叠加 CoT 与测试时扩展,最佳模型仅达 48%,落后人类近 30%,暴露出现有模型在细粒度视觉推理与多步跨模态推理上的显著短板。

文章推荐理由

EMMA 以“无法仅凭文字或一次性看图即可回答”为硬门槛,剔除表面多模态实则语言可解的伪题目,用物理受力分析、化学键级计算、代码可视化等高阶任务直击 MLLM 推理软肋。它不仅提供精准失败诊断,还开源完整题库与评测脚本,是研究社区迈向“真正能推理的多模态智能体”的必备试金石。

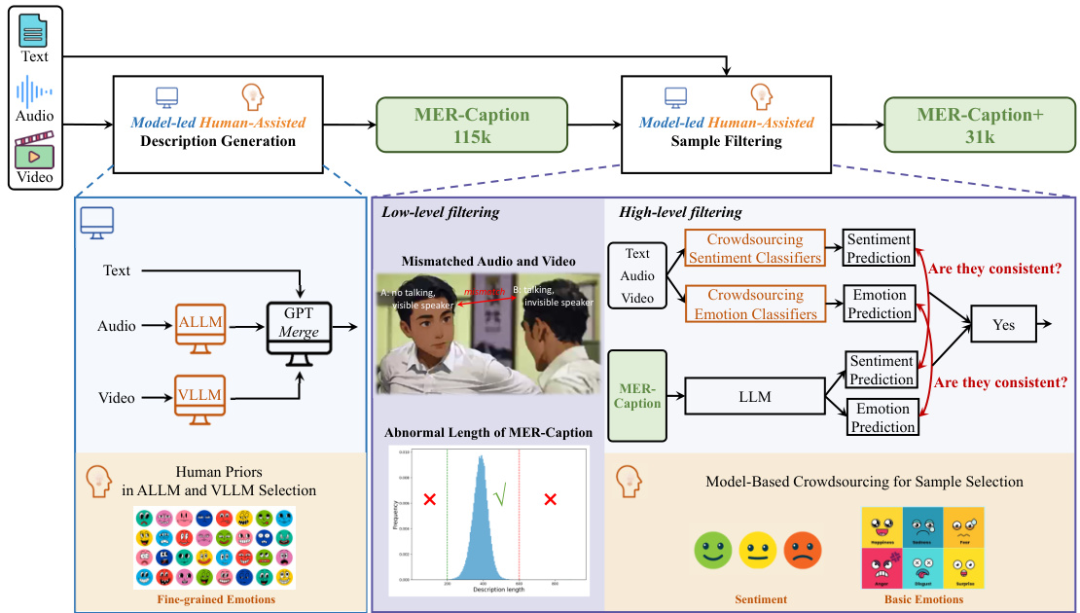

情感大模型:AffectGPT——首个面向 MLLM 的细粒度情感理解数据-模型-评测体系

论文英文标题

AffectGPT: A New Dataset, Model, and Benchmark for Emotion Understanding with Multimodal Large Language Models

论文链接

https://icml.cc/virtual/2025/poster/43565

论文中文摘要

AffectGPT 通过「模型主导+人工辅助」的众包策略,构建迄今最大规模的描述性情感数据集 MER-Caption(115K 样本、2K+ 细粒度情感类别),并提出带预融合模块的新模型 AffectGPT,显著提升多模态情感特征整合能力。配套的 MER-UniBench 支持传统 MER 任务与 MLLM 自由文本生成风格,实验显示 AffectGPT 在各任务均领先现有 MLLM 9% 以上。数据与代码已开源。

文章推荐理由

当情感识别从“七大类打标签”走向“自然语言描述复杂情绪”,AffectGPT 提供了首个端到端解决方案:大规模高质量描述数据、专为情感融合设计的模型、兼顾分类与生成的统一评测。无论是心理计算、人机交互还是内容安全审核,研究者都可直接复用其数据、模型与评测脚本,加速多模态情感智能的落地。

总结:从“多模态”到“通用智能体”的三级跳

| 核心痛点 | ||||

| 解决手段 | ||||

| 面向任务 | ||||

| 开源资源 |

四篇论文共同描绘了「多模态通用智能体」的完整拼图:知识可检索、推理可验证、情感可共情。

-- 完 --

机智流推荐阅读:

1. AI时代,你的速度决定了你的高度:吴恩达YC创业学校万字干货

2. ICCV25 | AI终于分清照片中的前景和背景了!探索南开DenseVLM在密集预测中的区域-语言对齐策略

3. 发个福利,可以免费领WAIC2025(世界人工智能大会·上海)单日门票

4. ICML 2025最佳论文花落谁家?120篇Oral前沿一网打尽!

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

在「机智流」公众号后台回复下方标红内容即可加入对应群聊:

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊