FilterLLM,推荐系统大杀器!

- 2025-07-30 18:08:00

论文题目:OverLoCK: An Overview-first-Look-Closely-next ConvNetwith Context-Mixing Dynamic Kernels

论文地址:https://arxiv.org/pdf/2502.16924

创新点

摒弃逐对判断用户-物品交互的范式(需数百次LLM推理),创新性地提出单次推理直接预测物品对所有用户的交互概率分布,解决十亿级冷启动场景下的计算瓶颈。

将LLM的“下一个词预测”能力扩展为“用户分布预测”,实现线性复杂度→常数复杂度的跨越。

将十亿级用户ID作为可学习token嵌入LLM词汇表(Vuser),使LLM能在单次前向传播中建模全量用户分布,突破传统方法仅能处理候选子集的限制。

方法

本文提出FilterLLM,将冷启动物品的文本描述一次性映射成覆盖十亿用户的交互概率分布。具体做法是在预训练LLM的词表里追加每个用户ID对应的可学习token,构成“用户词汇表”;输入侧仅用物品内容文本构造短提示,经LLM编码后由新增的分布头直接输出所有用户token上的softmax概率,从而把“预测下一个词”改造成“预测下一批最可能交互的用户”。为了让这些用户token一开始就能刻画协同信号,作者先用物品视角的BPR损失在交互图上预训练用户与物品的隐向量,再用这些向量初始化用户token;正式训练时,用log-softmax损失最大化真实交互用户的概率,并辅以行为引导损失让LLM的表征逼近协同过滤得到的物品向量,整个过程中冻结原LLM权重,只微调LoRA层和用户token。线上推理时,对每个新物品跑一遍前向即可得到用户分布,按概率采样Top-K用户作为伪交互,随后用这些交互更新冷物品嵌入并送入推荐引擎。

Text-to-Judgment 与 Text-to-Distribution 推理流程对比示意图

本图对比了传统“Text-to-Judgment”范式与本文提出的“Text-to-Distribution”范式:左侧传统方法把用户历史描述和冷物品描述组成一条一条 prompt,让 LLM 逐对判断是否会发生交互,因此需要数百次推理才能覆盖候选用户;右侧新范式直接把冷物品描述送入 LLM,一次前向就在整个用户集合上输出概率分布,从而用一次推理替代数百次,显著降低计算量并解除候选集限制。

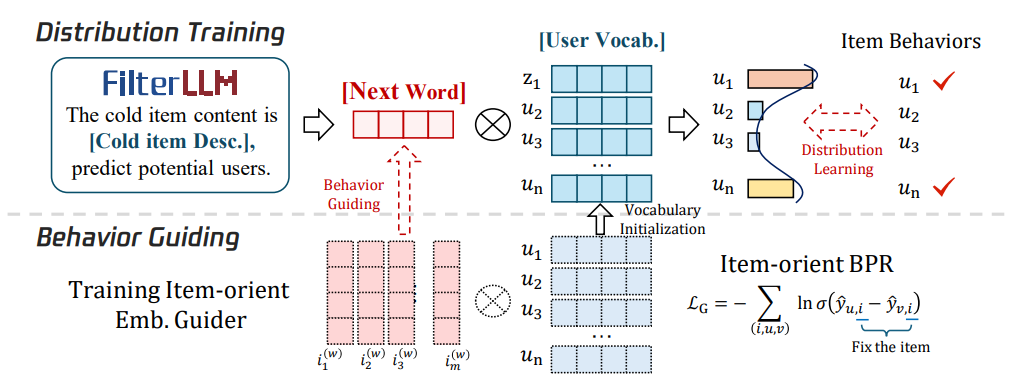

FilterLLM 框架结构图

本图展示了 FilterLLM 的整体架构:先将物品内容文本送入冻结的 LLM 得到最后一层隐藏向量,该向量与可学习的“用户词汇表”中的十亿级用户 token 同时输入新增的分布预测头,计算 softmax 得到每个用户的交互概率;随后根据概率采样若干用户作为伪交互,连同真实交互一起通过优化模块更新冷物品嵌入;

FilterLLM 在线服务流程图

本图以端到端视角展示了FilterLLM在真实工业环境中的落地流程:每当有新冷物品上线,系统先调用单次Text-to-Distribution推理在236毫秒内生成覆盖全量用户的交互概率分布,随后按概率Top-K采样伪交互并仅更新该冷物品的嵌入,最后把更新后的嵌入推送到在线推荐引擎即可实时生效;整个过程不碰现有用户嵌入,也不依赖额外候选集,直接带来34.75倍推理提速,同时保持与ColdLLM相同的120毫秒嵌入更新时间,从而形成一条高效、低延迟、可无缝接入现有推荐服务的冷启动链路。

实验

本表在 CiteULike 与 ML-10M 两份数据集上把 FilterLLM 与十二种强基线按三类主干模型(MF、NGCF、LightGCN)分别测试了整体、冷启动与暖启动场景,结果一致表明 FilterLLM 全面领先:在 MF 上,CiteULike 的 Recall@20 和 NDCG@20 分别达到 0.2128 与 0.1700,比最佳基线 ColdLLM 的 0.1838 与 0.1406 提升约 16% 与 21%,冷启动指标更是从 0.1195→0.1787;ML-10M 的整体指标也提升 2–3%。换成更强的图模型 NGCF 与 LightGCN 后,FilterLLM 的优势进一步扩大,例如在 LightGCN 上 CiteULike 冷启动 Recall 从 ColdLLM 的 0.1035 跃升至 0.1604,NDCG 从 0.0828 提升到 0.1221,ML-10M 冷启动 Recall 从 0.1594 提升到 0.1638,NDCG 从 0.1665 提升到 0.1765,而暖启动指标仍与基线持平或略优,说明 FilterLLM 并未牺牲对旧物品的推荐质量;所有结果中 FilterLLM 均以显著幅度居首,验证了 Text-to-Distribution 范式在各类主干模型下的通用性与优越性。

-- END --

关注“学姐带你玩AI”公众号,回复“2025大模型”

领取2025大模型创新方案合集+开源代码

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊