具身领域LLM结合强化学习与世界模型工作汇总

- 2025-07-29 14:15:34

点击下方卡片,关注“具身智能之心”公众号

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

最近有同学咨询具身智能之心LLM结合强化学习与世界模型相关的工作有哪些比较新的,想找找灵感。这里为大家汇总几篇2024的中稿工作!

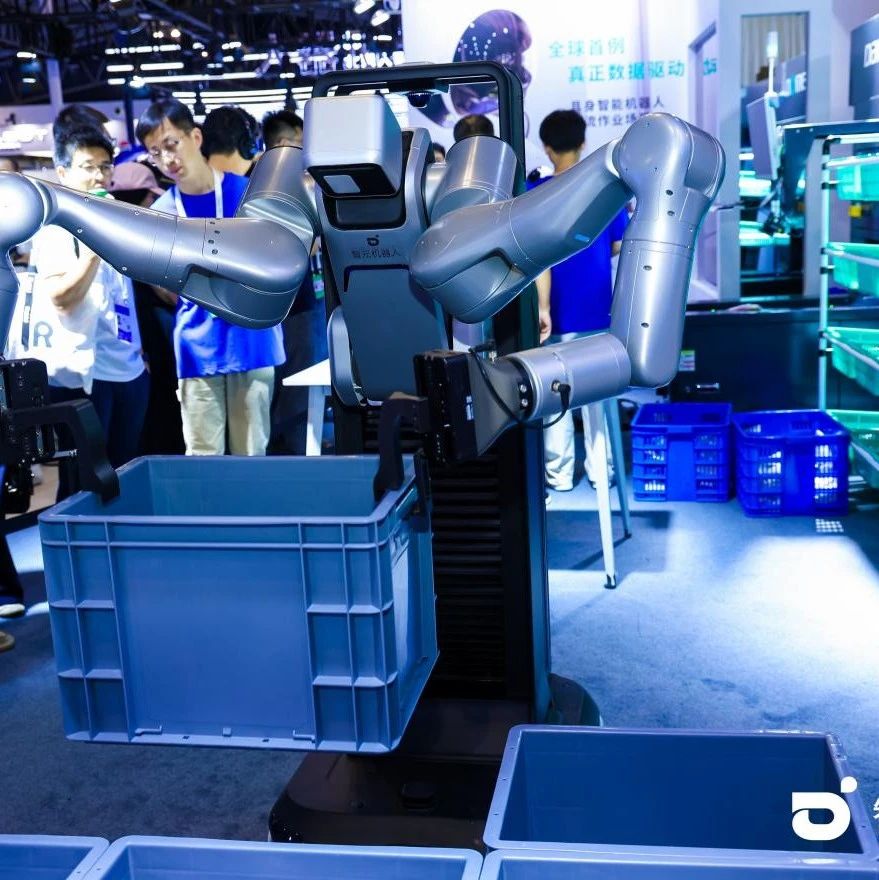

1)UniSim:通过生成式建模来学习通用现实世界交互模拟器

Learning Interactive Real-World Simulators,ICLR 2024的杰出paper,UC Berkeley的。

项目链接:https://universal-simulator.github.io/unisim/

项目链接:https://kalmneurips2024.github.io/

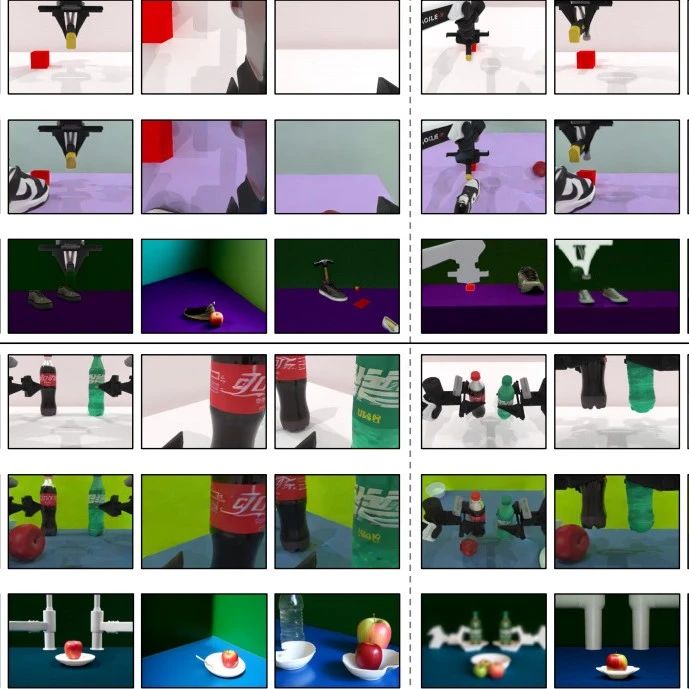

基于互联网数据训练的生成模型已经彻底改变了文本、图像和视频内容的创作方式。生成模型的下一个里程碑,或许在于模拟对人类、机器人及其他交互智能体行为作出响应的逼真体验。这种现实世界模拟器的应用场景极为广泛:既可用于游戏和电影中的可控内容生成,也能为具身智能体提供纯模拟训练环境——这些经过模拟训练的智能体可直接部署至现实世界。本文探索通过生成式建模来学习通用现实世界交互模拟器(UniSim)的可能性。研究首先揭示了一个重要发现:可用于学习现实世界模拟器的自然数据集往往在不同维度上各具优势(如图像数据中的丰富物体、机器人数据中的密集采样动作、导航数据中的多样运动轨迹)。通过精心整合这些提供不同体验维度的多样化数据集,我们能够从静态场景和物体出发,模拟出高层级指令(如"打开抽屉")和低层级控制(如"移动∆x,∆y")引发的视觉结果。利用该模拟器同时训练了高层级视觉语言策略和低层级强化学习策略,二者在纯模拟环境中训练后皆能以零样本方式直接应用于现实场景。研究还表明,视频描述生成等其他类型的人工智能也能从模拟体验训练中获益,这将进一步拓展其应用疆界。

2)Robust agents learn causal world models

Robust agents learn causal world models,ICLR2024的工作,Google DeepMind出品。

长久以来,学界一直存在一个基本假设:因果推理在实现鲁棒且通用的人工智能中具有核心作用。然而,智能体是否必须学习因果模型才能实现跨领域泛化,抑或其他归纳偏置已足够,这一问题始终未有定论。我们的研究对此给出了明确答案:任何能够在大量分布变化情况下满足遗憾界限(regret bound)的智能体,必然已习得数据生成过程的近似因果模型;而对于最优智能体而言,该模型将收敛至真实因果模型。我们进一步探讨了这一结论对迁移学习、因果推断等多个研究领域的深远影响。

3)MAMBA:一种面向元强化学习的高效世界模型方法

论文链接:https://openreview.net/pdf?id=1RE0H6mU7M

MAMBA: an Effective World Model Approach for Meta-Reinforcement Learning。ICLR2024的工作。

元强化学习(meta-RL)为解决需要高效探索的复杂领域问题提供了有前景的框架。当前主流元强化学习算法普遍存在样本效率低下的问题,且主要局限于低维任务分布场景。与此同时,基于模型的强化学习方法在求解部分可观测马尔可夫决策过程(POMDP)方面已取得显著成效——而元强化学习正是其特例之一。本研究基于现有最先进的模型方法和元强化学习技术,创新性地提出了一种新型基于模型的元强化学习框架。实验结果表明,该方法在常见元强化学习基准测试中表现优异:在几乎无需超参数调优的情况下,不仅能获得更高回报,还实现了最高达15倍的样本效率提升。此外,我们在一系列更具挑战性的高维任务场景中验证了该方法的有效性,为推动实现具有现实世界泛化能力的智能体迈出了重要一步。

4)EMMA:基于平行文本世界LLM训练的具身多模态智能体

论文链接:https://arxiv.org/pdf/2311.16714.pdf

项目链接:https://github.com/stevenyangyj/Emma-Alfworld

CVPR2024的工作,南方科技大学团队。

尽管大语言模型(LLMs)在文本模拟世界中表现出色,但它们缺乏对视觉、听觉等多模态信号的感知能力,难以与更真实的物理世界互动。虽然视觉语言模型(VLMs)整合了LLM模块——(1)可对齐静态图像特征,且(2)可能具备世界动态的先验知识(正如在文本世界中所展现的)——但由于未经过具身视觉世界的训练,其无法与真实世界动态对齐。另一方面,在没有专家指导的情况下,直接让具身智能体在噪声充斥的视觉世界中学习往往效率低下且收效甚微。本研究创新性地利用文本世界中的LLM智能体来指导视觉世界中VLM智能体的训练:通过蒸馏LLM在文本世界任务中的反思成果(通过分析错误改进行动),对VLM进行视觉世界同类任务的微调,从而快速适应视觉世界动态,最终形成具身多模态智能体EMMA。这种平行世界间的跨模态模仿学习通过新型DAgger-DPO算法实现,使EMMA无需LLM专家持续指导即可泛化至广泛的新任务。在ALFWorld基准测试的多样化任务中,EMMA表现显著优于当前最先进的VLM智能体,例如成功率提升达20%-70%。

5)Text2Reward:基于语言模型的强化学习密集奖励生成

ICLR2024的spotlight,论文链接:https://openreview.net/pdf?id=tUM39YTRxH,香港大学&南京大学等团队。

奖励函数设计一直是强化学习(RL)领域长期存在的挑战:它既需要专业知识又依赖领域数据,导致开发成本居高不下。为此,这里提出TEXT2REWARD框架,无需真实数据的方法能基于大语言模型(LLMs)自动生成并优化密集奖励函数。该系统仅需自然语言描述的任务目标,即可生成可执行的密集奖励函数代码,其实现植根于精简的环境表征。与逆强化学习或近期使用LLMs生成稀疏奖励代码、跨时间步恒定的未优化密集奖励的研究不同,TEXT2REWARD能生成可解释的自由形式密集奖励代码,可覆盖多样化任务场景、调用现有程序包,并支持基于人类反馈的迭代优化。在两个机器人操作基准(MANISKILL2、METAWORLD)和两个MUJOCO运动环境中进行评估。在17项操作任务中的13项上,使用生成奖励代码训练的策略在任务成功率和收敛速度上达到甚至超越专家编写的奖励代码。对于运动任务,本方法成功学习六种新型运动行为,成功率超过94%。此外,仿真器中训练的策略能直接部署至现实世界。最后,通过人类反馈优化奖励函数,TEXT2REWARD可进一步提升策略性能。

6)在线持续学习型交互式指令跟随智能体

ICLR 2024最新工作,原文:Online Continual Learning for Interactive Instruction Following Agents。论文链接:https://openreview.net/pdf?id=7M0EzjugaN.在通过语言指令训练具身智能体执行日常任务的研究中,现有文献大多假设智能体在初始阶段即学习全部训练数据。我们认为这种学习设定缺乏现实性,因为机器人智能体理应在探索和感知世界的过程中持续学习。为构建更贴近现实的具身智能体学习范式,我们提出两种持续学习框架:行为增量学习(Behavior-IL)与环境增量学习(Environment-IL)。

针对这些任务,既往基于"数据先验"的持续学习方法通过保存历史任务的逻辑输出(logits)来实现持续学习。然而,这类存储信息往往存在学习不充分的问题,且需要依赖任务边界信息——这类信息在实际场景中未必总能获取。对此,我们提出基于置信度分数的动态平均更新机制(Confidence-Aware Moving Average, CAMA),该方案无需训练过程中的任务边界信息(即任务无关),以滑动平均方式实现参数更新。

在提出的Behavior-IL与Environment-IL框架下,CAMA方法通过大量实证验证,以显著优势超越现有最优方法。

7)AMAGO:面向自适应智能体的可扩展情境强化学习框架

ICLR 2024 spotlight,论文链接https://openreview.net/pdf?id=M6XWoEdmwf。

AMAGO是一种基于序列模型的情境强化学习(RL)智能体,旨在解决泛化性、长期记忆和元学习等核心挑战。现有研究表明,离策略学习可使循环策略的情境RL具备可行性,但这类方法不仅需要大量调参,还会因智能体记忆容量、规划视野和模型规模的瓶颈而限制可扩展性。AMAGO通过重构离策略情境学习方法,首次实现对长序列Transformer的并行化训练,使其能基于完整行动轨迹进行端到端强化学习。该智能体具备卓越的可扩展性,能广泛应用于各类问题,在元强化学习和长期记忆领域的实验验证了其优异性能。AMAGO对稀疏奖励和离策略数据的专注处理,还使情境学习能拓展至具有挑战性探索目标的条件任务。当结合多目标 hindsight 重标注方案时,AMAGO可攻克程序化生成环境中多指令完成的开放世界难题:这类问题以往被认为极难解决。

8)基于预训练大语言模型的世界模型构建与任务规划方法

NeurIPS 2023的工作,论文链接:https://openreview.net/forum?id=zDbsSscmuj

当前,利用预训练大语言模型(LLMs)解决规划问题正受到广泛关注。然而,直接将LLMs用作规划器的方法仍存在诸多局限:生成方案的准确性不足、过度依赖与模拟器或真实环境的交互反馈、以及难以有效整合人类反馈等。为此,本研究提出了一种创新范式——首先以规划领域定义语言(PDDL)构建显式世界(领域)模型,再通过可靠的领域无关规划器进行求解。

针对LLMs可能无法直接生成完整PDDL模型的问题,我们将其设计为PDDL与修正反馈源(如PDDL验证器和人类专家)之间的智能接口。对于不熟悉PDDL的用户,实验表明LLMs能实现PDDL与自然语言的双向转换,从而将修正反馈高效编码至底层领域模型。该框架不仅继承了外部规划器的正确性保障,还通过前置领域模型修正机制显著降低了人工干预需求——相较于现有工作需对每个生成方案进行交互式修正,用户仅需在初始阶段校正模型即可。

在IPC标准测试域和复杂度超越ALFWorld等常用基准的Household领域上,实验证实GPT-4可生成包含40余个动作的高质量PDDL模型,经修正后的模型成功求解了48项复杂规划任务。

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊