本周HF论文TOP20:Qwen3 GSPO、GUI-G²、MiroMind-M1等

- 2025-07-27 08:00:44

本文由 Intern-S1、Qwen3 等 AI 生成,内容可能有误!

Intern-S1 体验地址:https://chat.intern-ai.org.cn

摘要:本周 AI 社区热度不减!从阿里 Qwen3 背后的 GSPO 稳定强化学习算法,到模拟人类点击行为的高斯奖励模型,再到赋予 LLM 无限工作记忆的“潜意识线程”技术,前沿探索精彩纷呈。我们为您盘点了本周 Hugging Face Daily Papers 榜单上最受关注的 20 篇论文,内容涵盖模型优化、多模态感知、数据合成、AI 安全等多个领域。本文将按照社区投票热度(票数)从高到低为您一一解读,带您快速掌握 AI 研究的最新脉搏!

精彩开篇

大家好!新一期的 Hugging Face 热门论文盘点又和大家见面了。过去一周,AI 的世界依旧风起云涌,从基础算法的革新到底层视觉能力的拷问,每一项研究都像一块拼图,共同构筑着通用人工智能的宏伟蓝图。

我们是否仅仅满足于让 AI 在现有基准上“刷分”,还是应该勇敢地探索其能力的边界,甚至“短板”?本周的热门论文似乎在回应这一问题。研究者们不再局限于单一的性能提升,而是开始深入思考 AI 与人类在感知、推理和交互方式上的本质差异。他们或从人类行为中汲取灵感,设计出更符合直觉的奖励机制;或借鉴认知科学,提出颠覆性的内存管理框架,试图打破“上下文窗口”的枷锁。

这不仅是技术的迭代,更是思想的碰撞。让我们一起潜入本周最激动人心的 20 篇佳作,看看社区最关注的智慧火花,共同见证 AI 的进化之路。

(1) 🚀 GUI-G²:让 AI 像人一样点击!高斯奖励模型重塑 GUI 交互 (118 票)

论文原始英文标题:GUI-G^2: Gaussian Reward Modeling for GUI Grounding

论文链接:https://huggingface.co/papers/2507.15846

简要介绍:由浙江大学和蚂蚁集团的研究团队共同提出,这项工作旨在解决图形用户界面(GUI)自主交互中的一个核心问题:如何精确地将自然语言指令映射到界面位置。传统强化学习方法大多采用二元奖励(即点击成功为 1,失败为 0),这种“非黑即白”的稀疏信号忽略了空间交互的连续性。该研究受到人类点击行为的启发——用户点击目标时自然形成以目标为中心的高斯分布。基于此,研究者们提出了 GUI 高斯定位奖励(GUI-G²)框架。该框架将 GUI 元素建模为界面平面上的连续高斯分布,彻底改变了奖励设计范式。GUI-G² 包含两大协同机制:一是高斯点奖励,它通过以元素中心为峰值的指数衰减分布来鼓励精确定位;二是覆盖率奖励,通过衡量预测点击分布与目标区域的重叠程度来评估空间对齐。为了适应不同大小的界面元素,该框架还引入了自适应方差机制。这种从稀疏二元分类到密集连续优化的转变,为模型提供了更丰富的梯度信号,引导其朝向最佳交互位置。实验结果惊人,在 ScreenSpot-Pro 基准上,GUI-G² 的性能比当前最先进方法 UI-TARS-72B 提升了 24.7%,证明了该方法在界面变动和未知布局面前具有更强的鲁棒性和泛化能力。

核心图片:

(2) 🔥 MiroMind-M1:开源数学推理新标杆,上下文感知多阶段策略优化显神威 (109 票)

论文原始英文标题:MiroMind-M1: An Open-Source Advancement in Mathematical Reasoning via Context-Aware Multi-Stage Policy Optimization

论文链接:https://huggingface.co/papers/2507.14683

简要介绍:由 MiroMind AI 团队带来的 MiroMind-M1 系列是一套完全开源的推理语言模型(RLM),旨在缩小开源模型与 GPT-4o 等闭源模型在数学推理能力上的差距。该工作强调了开源社区在复现高性能 RLM 时面临的挑战,如缺少关键的训练数据和配置细节。为了提高透明度和可复现性,MiroMind-M1 项目不仅开源了模型,还发布了完整的训练数据集、代码和评估配置。其模型基于 Qwen-2.5 主干网络,通过两阶段训练而成:首先,在包含 71.9 万个经过验证的思维链(CoT)轨迹的数学推理问题上进行监督微调(SFT);然后,在 6.2 万个具有挑战性的可验证问题上进行可验证奖励强化学习(RLVR)。该研究的核心创新是提出了一种名为“上下文感知多阶段策略优化”(CAMPO)的算法。CAMPO 将长度递进式训练与自适应重复惩罚相结合,鼓励模型生成更长、更复杂的推理路径,同时保持训练的稳定性。在 AIME24、AIME25 和 MATH 等多个数学基准测试中,MiroMind-M1 在 7B 和 32B 开源模型中取得了顶尖或极具竞争力的性能和更高的 token 效率,为社区的进一步研究奠定了坚实的基础。

核心图片:

(3) 🤯 超越上下文极限:Subconscious Threads 技术让 LLM 拥有无限工作记忆 (102 票)

论文原始英文标题:Beyond Context Limits: Subconscious Threads for Long-Horizon Reasoning

论文链接:https://huggingface.co/papers/2507.16784

简要介绍:来自 MIT CSAIL 等机构的研究者们直面大语言模型(LLM)的核心瓶颈——有限的上下文窗口,这一瓶颈严重制约了模型的长程推理能力和效率。为此,他们提出了一种全新的范式,将推理过程从传统的线性序列建模,转变为递归的、可分解的任务树结构。该工作的两大核心贡献是线程推理模型(TIM)和 TIMRUN 推理运行时。TIM 是一种为递归和分解式问题解决而训练的 LLM 家族,它将复杂任务不断分解为包含思考、子任务和结论的简单步骤。其关键灵感来源于人类的“潜意识”工作方式:当我们完成一个子任务(如编写一个函数)后,大脑会将其细节“清出”工作记忆,以便专注于当前任务。TIMRUN 运行时系统在推理过程中动态实现了这一点:它会识别已完成子任务的 KV 状态,并将其从 GPU 内存中释放,从而实现位置嵌入和 GPU 内存页的复用。这种“子任务剪枝”机制使得 TIM 能够进行几乎无限长的长程推理,有效克服了输出长度限制、位置嵌入约束和 GPU 内存瓶颈,同时还能在单次推理中支持多跳工具调用,为构建更强大的 AI 智能体开辟了新道路。

(4) ⚡️ NABLA:为视频生成提速 2.7 倍!邻域自块级注意力机制 (94 票)

论文原始英文标题:nablaNABLA: Neighborhood Adaptive Block-Level Attention

论文链接:https://huggingface.co/papers/2507.13546

简要介绍:由 Sber AI 等机构提出的 NABLA 是一种新颖的注意力机制,旨在解决视频生成领域的一个关键难题:全注意力机制的二次方计算复杂度。这个问题在处理高分辨率、长时程视频时尤为突出,成为性能瓶颈。NABLA(Neighborhood Adaptive Block-Level Attention)通过动态适应视频扩散 Transformer(DiT)中的稀疏模式,有效降低了计算开销。其核心思想是,并非所有 token 之间的交互都是同等重要的,注意力矩阵天然存在稀疏性。NABLA 利用了这一点,它首先对查询(Q)和键(K)进行降维,然后在低维空间计算一个稀疏的注意力掩码。这个掩码是通过对 softmax 分布应用累积分布函数(CDF)阈值来生成的,从而动态地识别并保留最重要的注意力块。这种方法的最大优势在于它无需设计定制的底层 CUDA 算子,可以无缝集成到 PyTorch 的 Flex Attention 算子中,实现高效的训练和推理。实验证明,与基线模型相比,NABLA 能够在几乎不牺牲生成视频质量(CLIP 分数、VBench 分数和人类评估分数均保持同等水平)的情况下,实现高达 2.7 倍的训练和推理速度提升。

核心图片:

(5) 🚀 阿里 Qwen3 幕后功臣:GSPO 算法稳定高效地释放大模型 RL 潜力 (82 票)

论文原始英文标题:Group Sequence Policy Optimization

论文链接:https://huggingface.co/papers/2507.18071

简要介绍:来自阿里巴巴 Qwen 团队的这项工作,推出了对最新 Qwen3 模型性能提升做出重要贡献的强化学习算法——群体序列策略优化(GSPO)。该研究指出,现有先进的 RL 算法(如 GRPO)在训练巨型语言模型(尤其是 MoE 模型)时面临严重的稳定性问题,常常导致灾难性的模型崩溃。通过深入分析,团队发现问题的根源在于 GRPO 对重要性采样权重的根本性误用,其在 token 级别上应用权重,引入了高方差的训练噪声,这种噪声会随着响应长度的增加而累积,并被裁剪机制放大,最终导致模型崩溃。为了解决这一核心问题,GSPO 提出了一项关键创新:将重要性比率的定义从 token 级别提升到序列级别。这意味着优化、奖励和裁剪都在整个生成序列的层面上进行,这与奖励信号本身就是针对整个序列的本质相吻合。这种设计在理论上更加稳健,实践中也证明了其在训练稳定性、效率和最终性能上均优于 GRPO。特别值得一提的是,GSPO 从根本上解决了大型 MoE 模型 RL 训练中的稳定性挑战,无需复杂的稳定化策略(如 Routing Replay),为大规模 RL 训练的持续推进提供了坚实可靠的算法基础。

核心图片:

(6) 🤔 看不见的缰绳:RLVR 真能让模型学会新知识,还是在原地打转?(74 票)

论文原始英文标题:The Invisible Leash: Why RLVR May Not Escape Its Origin

论文链接:https://huggingface.co/papers/2507.14843

简要介绍:来自斯坦福大学、东京大学等机构的研究者对当前热门的“可验证奖励强化学习”(RLVR)技术提出了深刻的诘问:RLVR 究竟是在扩展模型的推理边界,还是仅仅在放大模型已知答案的概率?这项研究通过理论与实证分析,揭示了 RLVR 可能存在的内在局限。理论上,作者指出 RLVR 受到基座模型“支持集”的约束——它无法采样出初始概率为零的解,本质上是一种保守的重加权机制,限制了发现全新解法的可能性。同时,存在“熵-奖励权衡”:RLVR 提高了 pass@1 的精确度,但代价是可能缩小了探索范围,忽略了那些正确但概率较低的“非主流”解法。实证研究中,作者引入“经验支持集”的概念,发现在大采样预算下,“经验支持集收缩”的现象普遍超过“经验支持集扩展”,即 RLVR 常常使得模型无法再找到那些基座模型原本能够访问到的正确答案。一个有趣的发现是,尽管 RLVR 有时会增加 token 级别的熵(生成步骤更不确定),但答案级别的熵却在下降,说明看似更多样化的推理路径最终收敛到了更小范围的答案集合上。这项工作揭示了 RLVR 可能存在的“无形缰绳”,并指出未来的算法创新可能需要引入显式的探索机制来打破这一局限。

核心图片:

(7) 🛡️ 揭开面具下的恶魔:扩散语言模型(dLLM)的新兴安全漏洞 (56 票)

论文原始英文标题:The Devil behind the mask: An emergent safety vulnerability of Diffusion LLMs

论文链接:https://huggingface.co/papers/2507.11097

简要介绍:由上海交通大学 EPIC 实验室和上海 AI 实验室等机构的研究人员共同完成,该工作首次系统地揭示了基于扩散的大语言模型(dLLM)一个前所未有的安全漏洞。dLLM 作为自回归 LLM 的一种强大替代品,通过并行解码和双向建模实现了更快的推理速度和更高的交互性。然而,研究发现,现有的对齐机制在面对一种新型的、利用遮罩(mask)输入的对抗性提示时完全失效。为此,他们提出了 DIJA(Diffusion-based LLMs Jailbreak Attack),这是一个专门利用 dLLM 独特安全弱点的越狱攻击框架。DIJA 的核心思想是构建一种交错的“文本-遮罩”对抗性提示。这种提示利用了 dLLM 的两大特性:1) 双向建模会驱使模型为遮罩部分生成与上下文一致的内容,即便这些内容是有害的;2) 并行解码限制了模型在生成过程中进行动态过滤或拒绝采样的能力。结果是,即使有害指令被直接暴露在提示中,标准的对齐机制也会失效,导致模型生成有害内容。实验表明,DIJA 的攻击成功率远超现有越狱方法,在 Dream-Instruct 模型上实现了高达 100% 的关键词攻击成功率,揭示了这类新兴语言模型架构中一个被严重忽视的威胁,并呼吁学术界和工业界重新思考其安全对齐策略。

核心图片:

(8) 👁️ 图灵之眼测试:AI 的世界里,有像素、有模式,唯独没有诗意 (54 票)

论文原始英文标题:Pixels, Patterns, but No Poetry: To See The World like Humans

论文链接:https://huggingface.co/papers/2507.16863

简要介绍:来自中国科学院大学、北京大学等高校的研究团队提出了一个深刻的问题:多模态大语言模型(MLLM)真的能像人类一样感知世界吗?以往的研究大多关注提升 MLLM 的“推理”能力,而该工作则将焦点转向了更基础的“感知”层面。为此,他们设计了一个名为“图灵之眼测试”(Turing Eye Test, TET)的感知导向基准,包含四项对人类而言轻而易举,但对 AI 极具挑战性的诊断任务:隐藏在风景中的文字、3D 验证码、汉字拆解组合以及色盲测试图。实验结果令人震惊:当前最先进的 MLLM 在这些任务上表现出灾难性的失败,几乎无法正确识别。进一步分析发现,无论是上下文学习(in-context learning)还是微调语言模型部分,都无法提升模型在 TET 上的表现。然而,一旦微调视觉模型部分(vision tower),模型就能迅速适应。这一发现有力地证明了,当前 MLLM 与人类感知的核心差距在于视觉模型的泛化能力,而非语言模型的知识和推理能力。这项工作为我们揭示了 MLLM 在通往类人感知道路上的一块关键短板,并为未来的研究指明了方向。

核心图片:

(9) 🎮 Yume:从一张图到可交互的动态世界,键盘就是你的操纵杆 (59 票)

论文原始英文标题:Yume: An Interactive World Generation Model

论文链接:https://huggingface.co/papers/2507.17744

简要介绍:由上海人工智能实验室与复旦大学联合推出的 Yume 项目,旨在创造一个可以通过图像、文本或视频生成,并能使用键盘等外设进行探索和控制的交互式、逼真动态世界。本次发布的预览版 Yume,能够从单张输入图像生成一个动态世界,并允许用户通过键盘操作进行探索。为实现高保真和交互式的视频世界生成,Yume 框架设计精良,包含四大核心组件。首先,通过“量化相机运动”(QCM)模块,将连续的相机轨迹离散化为键盘可控的动作(如前进、左转、抬头等),简化了训练和交互。其次,引入了带有记忆模块的“遮罩视频扩散 Transformer”(MVDT),以自回归的方式实现理论上无限长的视频生成。再者,为了提升视觉质量和控制精度,设计了无需训练的“抗伪影机制”(AAM)和基于随机微分方程的“时间旅行采样”(TTS-SDE)。最后,通过对抗性蒸馏和缓存机制的协同优化,实现了模型加速。该模型在高质量的世界探索数据集 Sekai 上进行训练,取得了卓越的效果。项目团队已将所有数据、代码库和模型权重开源,并计划每月更新,向着最终目标迈进。

核心图片:

(10) 🎤 Step-Audio 2 技术报告:打造工业级端到端多模态语音交互模型 (52 票)

论文原始英文标题:Step-Audio 2 Technical Report

论文链接:https://huggingface.co/papers/2507.16632

简要介绍:StepFun 音频团队推出了 Step-Audio 2,一个专为工业级应用设计的端到端多模态大语言模型,专注于音频理解和语音对话。该模型通过集成潜在音频编码器和以推理为中心的强化学习(RL),在自动语音识别(ASR)和音频理解方面取得了卓越性能。为了实现真正的端到端语音对话,Step-Audio 2 将离散音频 token 的生成过程融入语言建模中,这极大地增强了其对说话风格、情感等副语言信息的响应能力。模型不仅能理解语音中的语义信息,还能捕捉情感、语调和非语言声音。更重要的是,为了解决现有模型普遍存在的“幻觉”问题和音色风格选择有限的缺点,Step-Audio 2 引入了检索增强生成(RAG)技术,并能调用外部工具,如网络搜索以获取实时信息,以及创新的“音频搜索”工具来切换音色。通过语音指令,模型可以检索并模仿特定声音的音色和说话风格。该模型在数百万小时的真实和合成音频数据上进行了多阶段训练,在多个音频理解和对话基准测试中,其性能达到了业界领先水平。

核心图片:

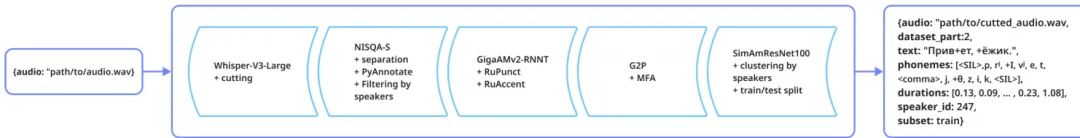

(11) 🇷🇺 Balalaika 数据集:攻克俄语语音生成的语音与韵律挑战 (48 票)

论文原始英文标题:A Data-Centric Framework for Addressing Phonetic and Prosodic Challenges in Russian Speech Generative Models

论文链接:https://huggingface.co/papers/2507.13563

简要介绍:莫斯科通信与信息技术大学等机构的研究者针对俄语语音合成(TTS)中的特有挑战,如元音弱化、辅音清化、多变的重音模式和不自然的语调等问题,提出了一个以数据为中心的解决方案。他们推出了名为 Balalaika 的全新数据集,包含超过 2000 小时的录音棚质量的俄语对话语音。该数据集的核心优势在于其详尽的文本标注,不仅包括了准确的转录,还包含了对语音合成至关重要的标点符号和重音标记。研究团队详细介绍了数据集的构建流程,包括从播客中收集高质量对话语音、使用 Whisper-v3 进行精确的音频切分、通过 NISQA-S 模型进行质量评估与分级,以及利用一系列先进模型自动完成转录、标点添加和重音标注。实验结果表明,在 Balalaika 数据集上训练的模型,无论是在语音合成任务还是在语音增强任务中,其性能都显著优于使用现有俄语数据集训练的模型。这项工作为解决俄语等具有复杂语音和韵律特征的语言的生成模型挑战,提供了一个宝贵的高质量资源和一套完整的数据处理框架。

核心图片:

(12) 🤖 MegaScience:构建 125 万实例科学推理数据集,推动 AI 科学家发展 (44 票)

论文原始英文标题:MegaScience: Pushing the Frontiers of Post-Training Datasets for Science Reasoning

论文链接:https://huggingface.co/papers/2507.16812

简要介绍:来自上海交通大学 GAIR Lab 的研究者们针对科学推理领域高质量、大规模、可验证数据集的缺失问题,推出了一个宏大的项目。首先,他们构建了 TEXTBOOKREASONING 数据集,这是一个从 1.2 万本大学级别科学教科书中提取的、包含 65 万个推理问题的开放数据集,覆盖了物理、生物、化学等 7 个学科,其参考答案真实可靠。在此基础上,他们进一步整合了多个高质量的开源科学数据集,通过系统性的消融实验确定了最佳的数据筛选方法,最终构建了包含 125 万实例的 MEGASCIENCE 数据集。为了确保评估的准确性和公平性,团队还建立了一个覆盖 15 个基准的综合评估系统,并设计了全面的答案提取策略。实验表明,与现有开源科学数据集相比,使用 MEGASCIENCE 训练的模型不仅性能更优,而且生成的答案长度更短,从而提高了训练和推理效率。更引人注目的是,在 MEGASCIENCE 上训练的 Llama3.1、Qwen2.5 和 Qwen3 系列基础模型,其平均性能显著超过了官方的指令微调版本,并且模型越大、能力越强,提升效果越明显,显示出科学指令微调的规模化效益。

核心图片:

(13) 🎨 无需人工!全自动高质量图像编辑三元组挖掘流水线 (44 票)

论文原始英文标题:NoHumansRequired: Autonomous High-Quality Image Editing Triplet Mining

论文链接:https://huggingface.co/papers/2507.14119

简要介绍:Layer Team 和 SALUTEDEV 的研究人员开发了一个全自动、模块化的数据挖掘流水线,旨在解决指令引导的图像编辑任务中高质量训练数据稀缺的瓶颈。这类任务的监督训练需要数百万个“⟨原始图像, 编辑指令, 编辑后图像⟩”的三元组,但确保每个编辑都像素级精确、风格一致且物理上合理,是一项艰巨的任务。传统方法依赖大量人工标注,成本高昂且效率低下。该研究提出的新系统完全无需人工干预,它利用公开的生成模型,能够跨领域、跨分辨率、跨风格地挖掘高保真三元组。其核心创新在于使用了一个为图像编辑任务专门微调的 Gemini 验证器。这个验证器可以直接对编辑质量(包括指令遵循度和美学)进行打分,从而避免了依赖分割或定位等外部模型的复杂流程。此外,通过反演和组合式自举(compositional bootstrapping)技术,该系统能将挖掘到的数据集规模扩大约 2.2 倍。为了推动该领域的研究,团队发布了包含 35.8 万个高质量三元组的开放数据集 NHR-Edit,并在大规模跨数据集评估中证明其优于所有公开替代品。同时,他们还发布了基于该数据微调的开源模型 Bagel-NHR-Edit,在实验中达到了最先进的性能。

核心图片:

(14) 📝 GR-3 技术报告:字节跳动发布通用机器人 VLA 大模型 (41 票)

论文原始英文标题:GR-3 Technical Report

论文链接:https://huggingface.co/papers/2507.15493

简要介绍:字节跳动 Seed 团队发布了其在通用机器人策略方面的最新进展——GR-3。GR-3 是一个大规模的视觉-语言-动作(VLA)模型,旨在构建能够辅助人类日常生活的通用机器人。该模型在处理新物体、新环境以及涉及抽象概念的指令时展现出卓越的泛化能力。GR-3 的一个关键特性是其高效的微调能力:仅需少量通过 VR 设备收集的人类轨迹数据,即可快速、低成本地适应新场景。此外,GR-3 在处理长时程、高灵巧性任务(如双手协同操作和移动操作)方面表现出强大的鲁棒性和可靠性。这些能力的实现得益于一个多方面的训练策略,包括与网络规模的视觉语言数据进行联合训练、利用 VR 设备收集的人类轨迹数据进行高效微调,以及有效的机器人轨迹数据模仿学习。同时,报告还介绍了 ByteMini,一款灵活可靠的双手移动机器人,与 GR-3 结合后能够完成广泛的任务。在大量真实世界实验中,GR-3 在各种具有挑战性的任务上均超越了当前最先进的基线方法 RT-2,朝着通用智能机器人的目标迈出了坚实的一步。

核心图片:

(15) 🌐 WebShaper:用信息寻求形式化,智能体自主合成高质量训练数据 (39 票)

论文原始英文标题:WebShaper: Agentically Data Synthesizing via Information-Seeking Formalization

论文链接:https://huggingface.co/papers/2507.15061

简要介绍:来自阿里巴巴通义实验室的研究团队提出了 WebShaper,一个创新的“形式化驱动”信息寻求(IS)数据合成框架,旨在解决训练高质量 IS 智能体时数据稀缺的问题。现有数据合成方法通常是“信息驱动”的,即先从网络收集数据,再根据数据生成问题。这种方式可能导致信息结构与推理结构不一致,或问答不匹配。WebShaper 颠覆了这一流程,它首先使用集合论系统地对 IS 任务进行形式化定义,其核心是“知识投影”(Knowledge Projections, KP)的概念,通过 KP 的操作组合来精确控制推理结构。在数据合成时,WebShaper 从一个种子任务开始,通过一个多步扩展过程,利用一个名为“Expander”的智能体,根据形式化定义,自主地使用检索和验证工具,将当前的形式化问题扩展得更复杂。这种先有“骨架”(形式化)再填“血肉”(信息)的方式,保证了生成数据的结构一致性、答案准确性,并能系统地覆盖更多样的任务模式。实验结果表明,在 WebShaper 数据集上训练的模型,在 GAIA 和 WebWalkerQA 基准测试中,性能达到了开源 IS 智能体中的顶尖水平。

核心图片:

(16) 🎨 DesignLab:像设计师一样迭代!通过“审查-修正”循环打造精美幻灯片 (38 票)

论文原始英文标题:DesignLab: Designing Slides Through Iterative Detection and Correction

论文链接:https://huggingface.co/papers/2507.17202

简要介绍:由索尼集团和 KAIST 提出的 DesignLab,旨在解决非专业人士制作高质量演示文稿的难题。现有的自动化设计工具通常只能提供布局或配色方案的初步建议,却缺乏对自身输出进行迭代优化的能力,而这正是现实世界设计流程的关键。DesignLab 的核心思想是将设计过程分解为两个角色:负责发现设计问题的“设计审查员”(design reviewer)和负责修复这些问题的“设计贡献者”(design contributor)。这种分解使得一个迭代循环成为可能:审查员不断发现问题,贡献者进行修正,从而让一份草稿在每一次迭代中都得到提升,达到单次生成无法企及的质量。研究团队将幻灯片转换为结构化的 JSON 格式,并通过对最终设计稿引入可控的扰动(如改变字体、移动位置、调整颜色)来模拟“粗糙的草稿”,从而训练两个分别扮演审查员和贡献者角色的大语言模型。实验表明,通过拥抱设计的迭代本质,DesignLab 的性能优于现有的设计生成方法,包括一款商业工具,能够产出精美、专业的幻灯片。

核心图片:

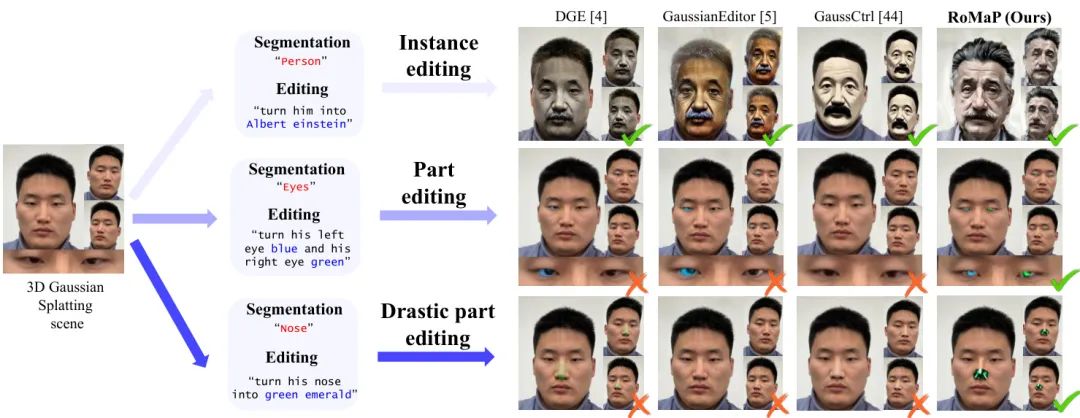

(17) 🎨 RoMaP:精准控制!在高斯溅射中实现稳健的 3D 局部编辑 (37 票)

论文原始英文标题:Robust 3D-Masked Part-level Editing in 3D Gaussian Splatting with Regularized Score Distillation Sampling

论文链接:https://huggingface.co/papers/2507.11061

简要介绍:来自首尔大学的研究者们提出了 RoMaP,一个新颖的 3D 局部编辑框架,专门用于解决在高斯溅射(Gaussian Splatting)表示中进行精确、局部化修改的挑战。尽管实例级别的 3D 编辑已取得显著进展,但对物体特定“部分”(如眼睛、鼻子)进行编辑仍然非常困难。这主要源于两大难题:一是多视图 2D 分割的不一致性,导致 3D 掩码不准确;二是分数蒸馏采样(SDS)损失的内在模糊性,难以实现剧烈的局部变化。RoMaP 针对性地解决了这两个问题。首先,它引入了一个强大的 3D 掩码生成模块,其核心是“3D 几何感知标签预测”(3D-GALP)技术。该技术利用球谐函数(SH)系数来建模依赖于视角的标签变化和“软标签”属性,从而在不同视角下都能生成准确且一致的局部掩码。其次,RoMaP 提出了一个“正则化的 SDS 损失”,它将标准 SDS 损失与额外的正则化项相结合。特别是通过“调度潜在混合与局部编辑”(SLaMP)方法,引入了一个 L1 锚定损失,这能生成高质量的局部编辑 2D 图像,并将修改严格限制在目标区域内,同时保持全局一致性。实验证明,RoMaP 在重建和生成的 3D 场景中都实现了最先进的局部编辑效果。

核心图片:

(18) 🚀 MUR:动量不确定性引导推理,让 LLM “好钢用在刀刃上” (34 票)

论文原始英文标题:MUR: Momentum Uncertainty guided Reasoning for Large Language Models

论文链接:https://huggingface.co/papers/2507.14958

简要介绍:由西安交通大学、南洋理工大学等机构的研究者共同提出,旨在解决大语言模型(LLM)在推理密集型任务中普遍存在的“过度思考”(overthinking)问题,即在简单步骤上浪费过多计算资源。虽然测试时扩展(Test-Time Scaling, TTS)技术能提升推理质量,但通常以牺牲效率为代价。该工作从物理学中的“动量”概念中获得灵感,提出了“动量不确定性引导推理”(Momentum Uncertainty-guided Reasoning, MUR)。MUR 的核心思想是,在推理过程中动态地跟踪和累积每一步的不确定性,形成一个“动量不确定性”指标。这个指标能够平滑地反映整个推理路径的置信度,当某一步的即时不确定性显著高于历史动量不确定性时,说明模型遇到了“坎”,此时才调用计算成本较高的 TTS 方法进行深度思考;反之,则直接生成答案,避免浪费。为了方便控制,该方法还引入了 γ-control 机制,通过一个超参数即可灵活调节推理预算。该方法无需额外训练,理论证明其在稳定性和偏差方面具有优势。在多个挑战性基准测试和不同尺寸的 Qwen3 模型上的实验表明,MUR 能在平均计算量减少超过 50% 的同时,将准确率提升 0.62% 至 3.37%。

核心图片:

(19) 🚀 只升采样关键区域!RALU 为扩散 Transformer 加速 7 倍 (34 票)

论文原始英文标题:Upsample What Matters: Region-Adaptive Latent Sampling for Accelerated Diffusion Transformers

论文链接:https://huggingface.co/papers/2507.08422

简要介绍:首尔大学的研究团队提出了 RALU(Region-Adaptive Latent Upsampling),一个无需训练的推理加速框架,专门用于提升扩散 Transformer(DiT)的生成速度。DiT 在高保真图像和视频生成方面表现出色,但其巨大的计算量是实际部署的主要障碍。现有加速方法多关注时间维度(如跨步重用缓存特征),而 RALU 则创新地从空间维度入手。研究发现,在扩散过程中直接对低分辨率潜在表征进行上采样会引入两种伪影:边缘区域的混叠伪影和由噪声水平与时间步不匹配导致的失配伪影。RALU 通过一个三阶段的混合分辨率采样策略巧妙地解决了这些问题:1) 首先在低分辨率下进行去噪,高效捕捉全局语义结构;2) 接着,对容易产生伪影的特定区域(主要是边缘区域)进行自适应上采样,抑制混叠;3) 最后,在推理后期对所有潜在表征进行全分辨率上采样,以完善细节。为了稳定不同分辨率间的过渡,该方法还引入了噪声-时间步重调度策略,使噪声水平与不同分辨率相匹配。实验结果表明,RALU 在 FLUX 模型上实现了高达 7.0 倍的加速,在 Stable Diffusion 3 上实现了 3.0 倍的加速,且图像质量下降极小,为 DiT 的高效部署提供了新思路。

核心图片:

(20) 🧠 SeC:从特征匹配到概念构建,让视频分割拥有“思考”能力 (33 票)

论文原始英文标题:SeC: Advancing Complex Video Object Segmentation via Progressive Concept Construction

论文链接:https://huggingface.co/papers/2507.15852

简要介绍:由上海交通大学、上海人工智能实验室等机构联合提出的 SeC(Segment Concept)框架,旨在解决视频对象分割(VOS)领域的一个根本性难题。现有 VOS 方法主要依赖外观特征匹配,当目标物体出现剧烈的外观变化、遮挡或场景切换时,性能会急剧下降。研究者认为,这与人类的感知方式存在巨大差异:人类通过在时间上整合观察,形成对物体的整体“概念”理解,从而在复杂动态中稳定地识别目标。SeC 框架正是模仿了这一过程,它从传统的特征匹配转向渐进式的概念构建。该框架利用大型视觉语言模型(LVLM)的强大推理能力,跨越不同帧整合视觉线索,构建一个关于目标对象的、高级的、以对象为中心的概念表示。在推理时,SeC 会根据已处理的帧形成对目标的全面语义理解,从而稳健地分割后续帧。此外,为了平衡效果与效率,SeC 还采用了场景自适应激活策略:在场景复杂多变时调用 LVLM 进行深度概念推理,在场景稳定时则回退到增强的特征匹配机制。为了验证该方法,团队还推出了一个专为高层概念推理设计的基准 SeCVOS。实验表明,SeC 在 SeCVOS 和标准 VOS 基准上均大幅超越了包括 SAM 2 在内的最先进方法,尤其在 SeCVOS 上比 SAM 2.1 提升了 11.8 个点,为概念驱动的 VOS 设立了新的标杆。

核心图片:

结尾总结

从本周的热门论文中,我们清晰地看到了一条从“执行”到“理解”,从“模仿”到“思考”的演进路径。无论是通过高斯分布来模拟人类的交互直觉,还是通过子任务剪枝来模仿潜意识的记忆管理,研究者们正努力让 AI 的“行为”更符合底层的认知规律。

与此同时,对 AI 局限性的深刻反思也贯穿始终。“图灵之眼测试”警示我们,当前的 MLLM 在基础感知上仍有很长的路要走;而对 RLVR 的“无形缰绳”的探讨,则促使我们思考如何真正突破模型能力的上限,而非在已知的知识圈内“精益求精”。

这些工作共同指向了一个未来:一个更高效、更稳定、更安全,也更具“常识”和“洞察力”的 AI。这趟激动人心的探索之旅远未结束,让我们共同期待下一周,AI 社区又将为我们带来哪些颠覆性的创见与突破!感谢您的阅读,我们下期再见!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊