无需标定!VGGT-Long:突破单目3D重建的极限到千米级!

- 2025-07-26 00:00:00

点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 论文信息

标题:VGGT-Long: Chunk it, Loop it, Align it -- Pushing VGGT's Limits on Kilometer-scale Long RGB Sequences

作者:Kai Deng, Zexin Ti, Jiawei Xu, Jian Yang, Jin Xie

机构: Nankai University、Nanjing University

原文链接:https://arxiv.org/abs/2507.16443

代码链接:https://github.com/DengKaiCQ/VGGT-Long

1. 导读

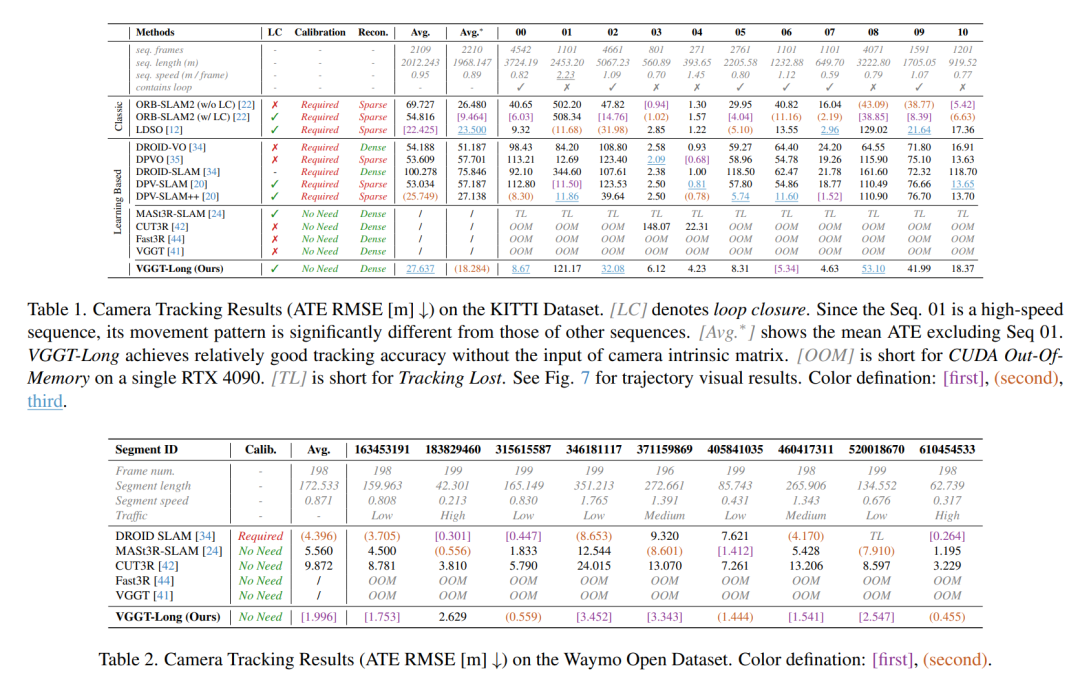

三维视觉的基础模型最近在三维感知方面表现出显著的能力。然而,由于内存的限制,将这些模型扩展到大规模的RGB流3D重建仍然具有挑战性。在这项工作中,我们提出了VGGT-Long,一个简单但有效的系统,将单目3D重建的极限推向公里级、无边界的户外环境。我们的方法通过基于块的处理策略,结合重叠对齐和轻量级闭环优化,解决现有模型的可扩展性瓶颈。无需摄像头校准、深度监督或模型再训练,VGGT-Long实现了与传统方法相媲美的轨迹和重建性能。我们评估我们的方法KITTI,Waymo,和虚拟KITTI数据集。VGGT-Long不仅能够在基础模型通常失败的长RGB序列上成功运行,还能在各种条件下生成准确一致的几何图形。我们的研究结果突显了利用基础模型在现实环境中实现可扩展单目3D场景的潜力,特别是在自动驾驶场景中。

2. 效果展示

在大规模的户外场景中,先前的工作存在以下问题:1)严重的漂移(CUT3R和Fast3R);2)无法完成整个长序列(MASt3R-SLAM和VGGT)。我们的方法VGGT-Long能够在保持场景准确性的同时完成公里级场景的重建。

(a)VGGT-long将一个公里级的序列划分成不同的块以进行处理。(b)这些对齐是基于3D空间内重叠帧的一致性得出的。

3. 引言

从单目RGB流感知三维环境对自动驾驶至关重要,但现有方法在处理千米级未校准序列时仍面临挑战。与小规模室内三维视觉任务不同,驾驶场景涉及长轨迹、稀疏的帧间对应关系、动态物体以及具有挑战性的户外条件。尽管部分方法能处理大规模单目场景,但通常依赖复杂的多模块流水线或假设已知相机内参。其他方法借助额外传感器(激光雷达、惯性测量单元或双目),回避了核心挑战:仅从单目RGB实现可扩展、免校准的三维重建,而这对自动驾驶系统至关重要。

三维视觉领域近期出现了范式转变,端到端基础模型(主要基于Transformer架构)兴起。从DUSt3R、MASt3R到CUT3R、Fast3R,直至最新的VGGT,这些工作旨在用单一统一的深度学习模型替代复杂的多组件运动恢复结构(SfM)和同步定位与地图构建(SLAM)流水线。这些模型通过大规模数据集训练,将相机位姿估计、内参回归和三维场景表示(通常为点图)整合到统一框架中。核心目标是实现误差在整个系统的反向传播,构建功能强大且通用的三维重建基础模型,直接处理未校准的原始RGB输入。然而,像CUT3R和Fast3R这样的基础模型在户外环境中仍存在严重漂移,即使短序列(几十帧)也难以稳定处理,限制了实际应用。

相比之下,VGGT在局部重建中表现出显著的稳定性和准确性,确立了其在重建质量上的最新技术水平。其主要限制并非性能,而是巨大的计算和内存开销。基于Transformer的基础模型在计算和内存需求上严重限制了其可扩展性。标准自注意力机制的计算量随输入规模呈平方增长,尽管Flash-Attention[等技术将计算复杂度降至线性,但GPU内存需求仍难以承受。例如,VGGT在24GiB显存的RTX 4090 GPU上仅能处理60至80帧图像;扩展至KITTI数据集第00序列轨迹(约4600帧)需要1380至1840GiB显存,远超当前硬件能力。这种瓶颈导致此类模型仅适用于小规模场景,因为内存和漂移累积在长序列中均难以控制。推荐课程:实时400FPS!高精NeRF/Gaussian SLAM定位与建图。

我们的工作受近期将基础模型集成至大规模系统的努力启发。典型案例是MASt3R-SLAM,其在MASt3R模型基础上构建了设计复杂的SLAM系统。为实现全局一致性,该系统采用包含位姿图优化、捆绑调整等复杂后端的架构。尽管功能强大,此类系统通常涉及显著的工程复杂性,难以适配下游任务。

这引发了一个根本性问题:大规模重建是否必然等同于系统级复杂性?我们的理念与此趋势显著不同。我们倡导极简主义方法,释放基础模型本身的内在潜力。我们认为VGGT已是功能强大的大规模三维感知引擎,主要挑战并非能力不足,而是可扩展性欠缺。与其围绕其构建另一个复杂系统,我们提出:能否以最小开销解决问题?

为此,我们提出VGGT-Long框架,通过简单而有效的方案将VGGT扩展至长序列:将序列划分为重叠片段,鲁棒对齐相邻片段,并利用高质量回环检测模块修正漂移。这种"分块-对齐"范式避免了复杂的图优化后端(如捆绑调整)的需求。这印证了底层VGGT模型的强大能力,表明通过恰当策略,其卓越的局部重建能力可无缝拼接为全局一致的大规模(千米级)地图。我们的工作倡导:当基础模型足够强大时,未必需要复杂后端系统辅助。

4. 主要贡献

我们的贡献如下:

我们提出了首个成功将单目三维重建模型扩展至千米级无界户外场景的系统,无需相机校准和深度监督。

我们引入了简单而有效的分块-对齐流水线,解决了VGGT等基础模型在长视频序列中的内存限制问题,同时实现了与需校准相机的传统方法相当的精度。

我们解决了局部模型处理长序列时固有的Sim(3)漂移问题,证明VGGT可作为鲁棒的前端,无需复杂后端即可支撑大规模重建系统。

5. 方法

我们提出的方法VGGT-Long通过将问题分解为三个阶段来处理长单目RGB序列:分块、逐块对齐、闭环和闭环校正。我们的方法在处理室外长序列时,保持了VGGT的局部准确性,同时确保了全局准确性。

(a)VGGT-long将公里尺度的序列划分为不同的块进行处理。(b)对齐结果来源于三维空间中重叠帧的一致性。

6. 实验结果

7. 总结 & 未来工作

在这项工作中,我们提出了VGGT-Long,这是一个简单而有效的框架,它将单目RGB-only 3D重建扩展到使用基础模型的长、无界视频序列。我们的方法克服了现有3D视觉模型的GPU内存限制,无需相机校准。通过在KITTI、Waymo和Virtual KITTI上的广泛实验,我们证明了VGGT-Long在各种真实世界和合成环境中实现了准确且可扩展的3D重建。未来,我们将继续研究改进长室外序列3D基础模型的准确性和一致性的方法。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊