阿里发布代码模型Qwen3-Coder并开源,性能媲美Claude Sonnet 4

- 2025-07-23 15:40:22

阿里通义千问发布迄今为止最具代理能力的代码模型Qwen3-Coder,并正式开源。

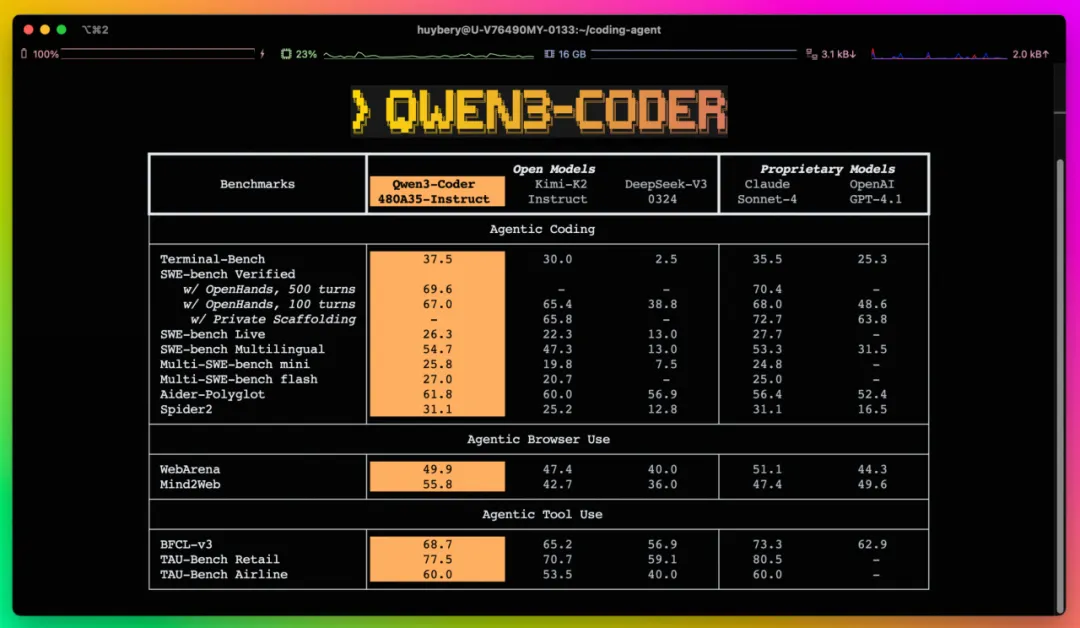

据介绍,Qwen3-Coder 拥有多个尺寸,当前最强大的版本Qwen3-Coder-480B-A35B-Instruct是一个 480B 参数激活 35B 参数的 MoE 模型,原生支持 256K token 的上下文并可通过 YaRN 扩展到 1M token,拥有卓越的代码和 Agent 能力。

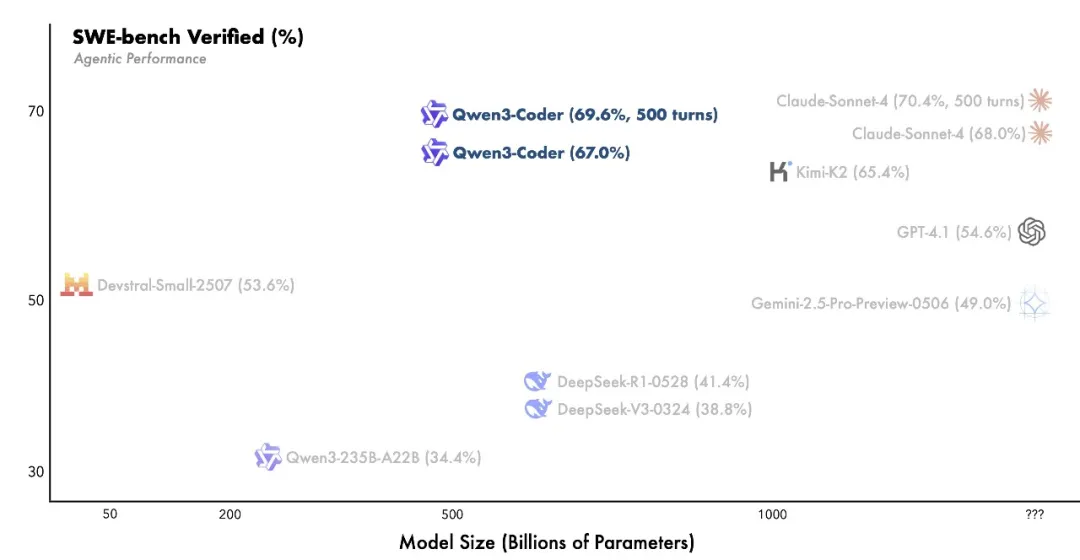

Qwen3-Coder-480B-A35B-Instruct 在 Agentic Coding、Agentic Browser-Use 和 Agentic Tool-Use 上取得了开源模型的 SOTA 效果,可以与 Claude Sonnet4 媲美。

为方便开发者更好地使用 Qwen3-Coder,通义团队还开源了一款命令行工具 Qwen Code。Qwen Code 基于 Gemini Code 进行二次开发,进行了 prompt 和工具调用协议适配,使得 Qwen Code 可以最大程度激发 Qwen3-Coder 在 Agentic Coding 任务上的表现。

此外, Qwen3-Coder 的 API 也可以和 Claude Code、Cline 等工具协同使用。

目前,Qwen3-Coder 已在魔搭社区、HuggingFace 等平台开源,全球开发者都可以免费下载使用。Qwen3-Coder 很快将接入阿里的AI编程产品通义灵码,API也已上线阿里云百炼。

就在今年5月23日,Anthropic的Claude 4双模型Claude Opus 4和Claude Sonnet 4携“不间断编码7小时”关键词强势发布,号称提供了卓越的编码和推理能力,Anthropic AI编程助手Claude Code也迎来全面开放。

在当时的权威编程基准测试SWE-bench Verified上,开启扩展思考的Claude Opus 4与Claude Sonnet 4的得分分别为79.4%和80.2%,大幅度超越了OpenAI Codex-1、OpenAI o3、OpenAI GPT-4.1、Gemini 2.5 Pro等模型,一举夺魁。

通义团队介绍,此次Qwen3-Coder升级从不同角度进行 Scaling,以提升模型的代码能力。包括数据扩展:总计 7.5T(代码占比 70%),在保持通用与数学能力的同时,具备卓越的编程能力;上下文扩展:原生支持 256K 上下文,借助 YaRN 可拓展至 1M,专为仓库级和动态数据(如 Pull Request)优化,助力 Agentic Coding;合成数据扩展:利用 Qwen2.5-Coder 对低质数据进行清洗与重写,显著提升整体数据质量。

另外,在真实世界的 Software Engneering Task,比如 SWE-Bench,通义团队在 Qwen3-Coder 的后训练阶段执行了 Agent RL,鼓励模型通过多轮交互的方式利用工具解决问题,借助阿里云的基础设施,实现同时运行 20k 独立环境。这一套基础设施可以提供大规模的强化学习反馈和评测,最终 Qwen3-Coder 在 SWE-bench Verified 上实现了开源模型 SOTA 的效果。

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊