DeepMind 与 OpenAI 斩获 IMO 金牌,这究竟意味着什么?

- 2025-07-23 15:16:10

我们已知什么,我们想知道什么,以及可能需要数年才能知晓什么

ERNEST DAVIS与GARY MARCUS

2025 年 7 月 23 日

由 ChatGPT 绘制的插图

由 ChatGPT 绘制的插图

过去几天,人工智能领域的重磅新闻,莫过于 OpenAI 和 DeepMind 相继宣布其 AI 系统在国际数学奥林匹克竞赛中取得金牌。

它们的得分是 35 分(满分 42),这一成绩足以让身处全球顶尖行列的人类高中生选手摘得金牌。

这无疑是令人瞩目的成就。但要论其分量究竟多重,对未来的影响几何,却难以定论,毕竟两家公司都对自家系统的核心原理讳莫如深。

尽管如此,我们还是尽力挖掘。本文将剖析我们当前可知、想知以及可能长年未知的三层信息,以探寻这些成果对数学乃至整个 AI 领域的终极意义。

DeepMind 的系统是 Gemini Deep Think 的高级版,我们简称为 “Deep Think”。OpenAI 尚未命名其系统,我们称之为 “OpenAI-IMO”。

什么是国际数学奥林匹克?

国际数学奥林匹克,简称 IMO,是一项为全球顶尖数学天才高中生举办的年度竞赛,始于 1959 年,是各级别中最负盛名的学生数学赛事。

2025 年,来自 110 个国家的 630 名选手齐聚一堂。他们都是从各自国家的数学竞赛中脱颖而出的佼佼者。

比赛为期两天,选手每天面对三道题目,拥有四个半小时的解题时间,期间不得与外界交流,唯有纸笔相伴。

每题由专家按 0 至 7 分进行评分,满分 42 分。奖牌并非依据绝对分数,而是按百分比排名授予。

通常,约 8% 的选手获金牌,17% 获银牌,25% 获铜牌。2025 年,共有 72 人摘金,分数线恰好是 35 分。

值得注意的是,在这 72 枚金牌中,有 45 人的得分与两个 AI 程序完全相同。最终,有五名人类选手取得了 42 分的满分,共 26 名人类选手的得分超过了这两个 AI 程序。

AI 摘金,成色几何?

成色极高。能解决世界排名前 67 位高中生的数学难题,意味着具备了超凡的解题能力。这些题目的难度跨度极大,从困难到噩梦级别。

一枚 IMO 金牌,是许多成功的数学家和科学家终其一生都会在简历上引以为傲的荣誉。

Deep Think 和 OpenAI-IMO 均在第 1 至 5 题上拿到满分,但在难度最高的第 6 题上颗粒无收。事实上,仅有 6 名人类选手完全解出了此题。

这两个新系统也远超早期的 AI 模型。在一项测试中,无论是 gemini-2.5-pro,还是 Grok 4,其表现甚至不足以获得一枚铜牌。可见,此次的技术飞跃是巨大的。

去年,DeepMind 的早期系统在 IMO-2024 中获得了银牌的最高分,但那次测试需要人工预处理题目,且不限时。今年,AI 则是在与人类完全相同的条件下完成了比赛。我们有理由相信,AI 取得了实质性的进步。

话虽如此,一些围绕此事的吹捧已经到了荒谬的地步。

例如,OpenAI 的 Sebastian Bubeck 宣称,这可能是“AI 的登月时刻”。

这实在夸大其词。在一场精英高中生数学竞赛中并列第 27 名,其历史意义远无法与人类登陆月球相提并论。

这对数学研究有何意义?

只有时间能给出答案。许多顶尖数学家年少时确是竞赛高手,但也有许多顶尖学者并非如此。IMO 的高分得主,未来也可能只成为称职而非卓越的数学家。

IMO 所考察的解题技巧,对于原创性数学研究虽有助益,但远非核心能力。正如数学家 Kevin Buzzard 所言,解决竞赛问题与推动真正的数学研究之间,并不能简单地划上等号。

前谷歌 CEO Eric Schmidt 曾预测,一年内将出现“世界级 AI 数学家”,这纯属幻想。现实是,自 1996 年以来,AI 自主证明的、具有一定重要性的定理只有一个。

在高中生竞赛中并列第 27 名,并不会立即改变这一现状。

系统设计:一个黑箱

两家公司都没有公布其系统的设计与训练细节。我们对 Deep Think 的技术细节一无所知,只知道它运用了新颖的强化学习技术,并辅以高质量的数学解题语料库进行训练。

OpenAI 同样守口如瓶。他们只透露 OpenAI-IMO 是一个进行下一词元预测的大语言模型,采用了一些实验性的通用技术,并且其设计并未特意针对数学推理进行优化。

两家公司都未解释,为何新系统的性能远超前代。因此,我们没有理由相信,这些未知的技术能够轻易泛化到其他问题领域。

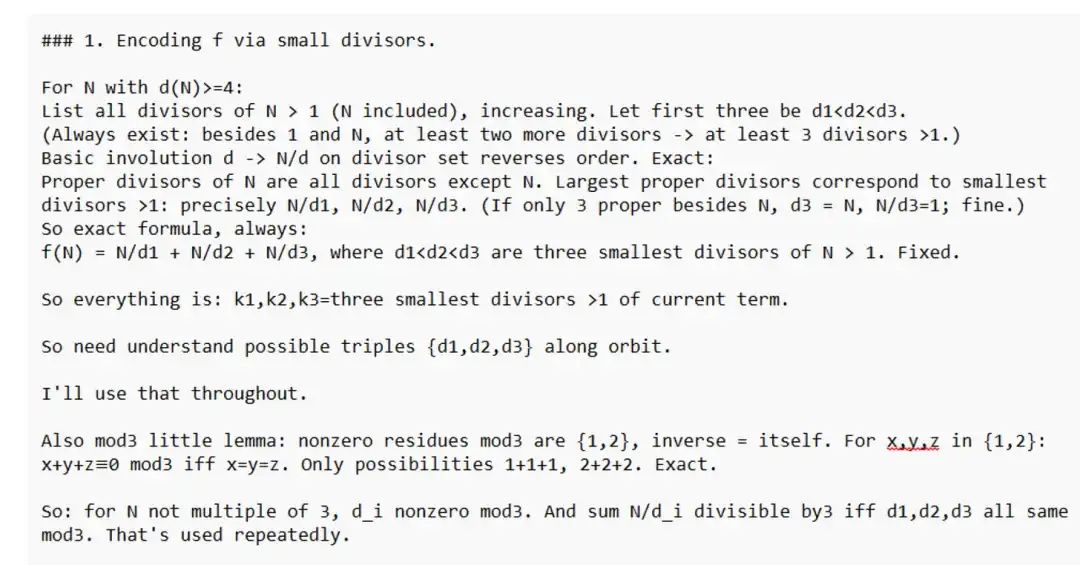

解题质量:高下立判

尽管两个系统都答对了前五题,但 Deep Think 的答案质量在两方面更优。

首先,正确答案不等于优秀答案。OpenAI-IMO 的三个答案虽然正确,但比 Deep Think 的答案臃肿和拙劣得多。

尤其在第 2 题这道复杂的几何题上,Deep Think 提供了出题人所期望的、优雅的欧几里得式证明。而 OpenAI-IMO 却将问题粗暴地转化为代数运算,给出了长达 300 多行的计算过程。

这种差异可能反映了 OpenAI-IMO 在理解上的局限,也表明它恐怕难以成为一个优秀的数学知识阐述者。

其次,风格迥异。Deep Think 及所有过往的语言模型,其输出的文本都流畅优雅,几乎可以直接用于学术论文或教科书。

相比之下,OpenAI-IMO 的行文风格,像一个不善言辞的数学家在做非正式的口头报告,磕磕绊绊,还时常喃喃自语以自我肯定。

Deep Think 输出示例

OpenAI-IMO 输出示例

需要澄清,我们并非认为其非正式风格应该被扣分。我们的重点在于,这种粗糙的风格在语言模型中极为罕见,强烈暗示 OpenAI-IMO 可能并非一个标准的大语言模型。

这也让我们对其技术的通用性打上了一个巨大的问号。

流程对比:两种文化

DeepMind 与 IMO 官方密切合作,在监督下完成测试,并尊重官方要求,在人类选手的庆祝活动结束后才公布消息。他们承诺将逐步开放该系统。

OpenAI 则几乎未与 IMO 沟通,自行组织测试且方法不透明,并在庆祝活动期间便高调宣布成果。他们也没有明确的系统发布计划。

此举引来了数学界的普遍反感。被誉为在世最伟大数学家之一的陶哲轩,就此事发表了措辞严厉的声明:

在缺乏受控、非自选的测试方法论的前提下,任何对 AI 模型之间,或 AI 与人类选手之间表现的直接比较,都应保持警惕。

因此,我不会对任何未在赛前披露其方法论的、自我报告的 AI 竞赛成绩发表评论。

换言之,陶哲轩完全拒绝承认 OpenAI 及其所谓的成就。

这背后,反映了两家实验室截然不同的文化。DeepMind 长期与科学界保持着富有成效的合作,AlphaFold 便是最佳例证。而 OpenAI 在这方面则相形见绌。

我们最想知道什么?

我们真心希望,有朝一日这些系统能接受外部审查,并回答以下关键问题:

系统原理:它们究竟如何工作和训练?性能飞跃的关键何在?这种提升是否牺牲了其他方面的能力?其独特技术能否解释 OpenAI-IMO 怪异的文风? 泛化能力:它们的适用范围有多广?能扩展到其他数学或科学问题上吗?或者,它们能否成为更宏大系统中的一个有效组件? 成本效益:解决每个问题的成本是多少(包括推理时间和训练投入)?当模型发布后,其使用成本是否经济? 工具协同:它们能否与计算工具、编程和网络搜索等外部工具兼容? 失败分析:对于未能解决的第 6 题,两个系统作何反应?是直接放弃,是给出了部分正确的思路,还是产生了无稽的幻觉?

总而言之,这项新进展无疑是激动人心的。但在外部科学家能够进行深入、严肃的评估之前,我们仍无法断言这一切的真正意义。

补充更新:正当本文即将发布之际,我们看到了一份新的报告。研究者通过精巧的多步协议和提示工程,成功引导 Gemini Pro 2.5 解答了同样五道 IMO 题目。

尽管其中两次需要加入针对性的提示,使得结果的纯粹性打了折扣,但其报告的透明度与详实细节,依然令人欣喜。

看来,这场风波要尘埃落定,还需时日。

Ernest Davis 是纽约大学计算机科学教授。Gary Marcus 是纽约大学名誉教授,同时也是科学家、作家和企业家。两位作者均与谷歌、OpenAI 或 IMO 没有任何关联。

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊