两颗AI芯片,重要进展

- 2025-07-23 08:53:31

公众号记得加星标⭐️,第一时间看推送不会错过。

来源:内容来自半导体行业观察综合。

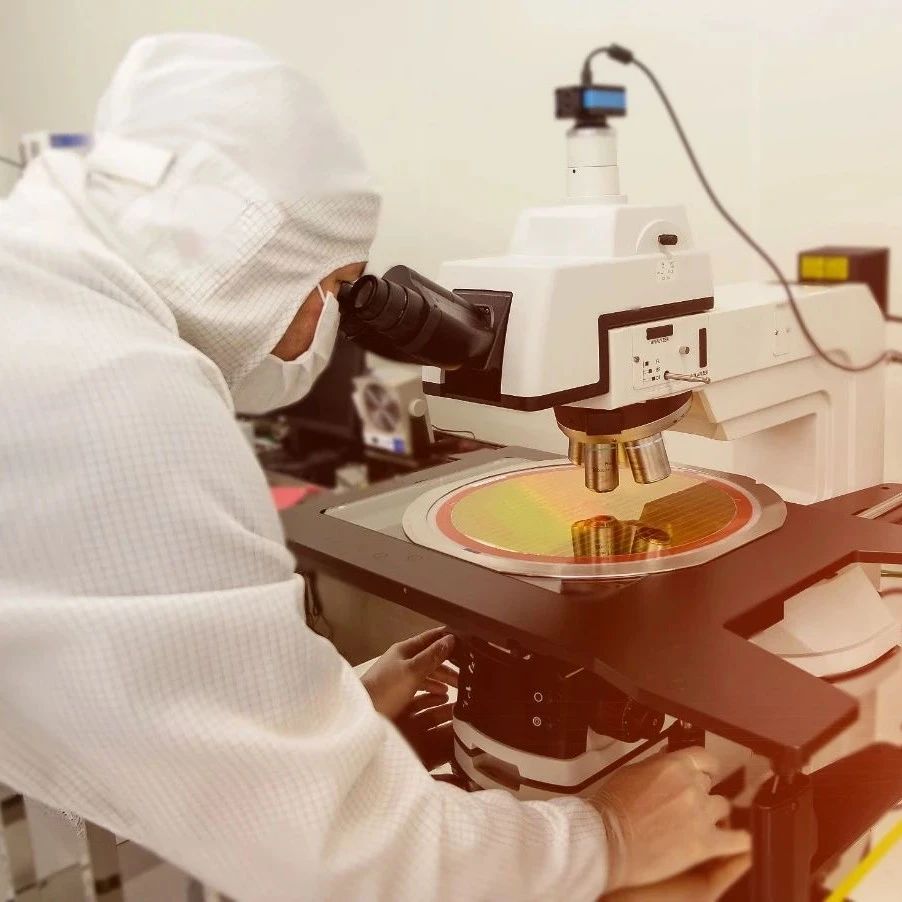

人工智能芯片初创公司Hailo Technologies Ltd.今天宣布推出其第二代 AI 加速器 Hailo-10H,具有强大的生成 AI 功能。

Hailo-10H 引入了新的设备功能,包括大型语言模型、视觉语言模型和其他生成架构,而无需依赖云连接。

这款全新的 AI 芯片以公司之前专注于视觉 AI 任务的 Hailo-8 处理器的成功为基础。新芯片增加了对生成式 AI 的支持,同时保留了针对边缘环境优化的节能设计。Hailo-10H 的典型功耗仅为 2.5 瓦,支持从个人设备、智能家居系统到汽车和电信基础设施等各种产品中的复杂 AI 应用。

Hailo 首席执行官兼联合创始人 Orr Danon 表示:“随着 Hailo-10H 现已开放订购,我们朝着让人工智能惠及所有人的使命又迈出了重要一步。这是首款将真正的生成式人工智能性能带到边缘的独立人工智能处理器,兼具高效率、高性价比和强大的软件生态系统。”

Hailo-10H 与 Hailo 现有的软件堆栈完全兼容,并受益于每月超过 10,000 名用户的全球开发者社区的支持。该芯片使开发人员能够直接在边缘设备上运行最先进的视觉和生成式 AI 模型,从而实现超低延迟的实时响应。

它还支持超低延迟的实时部署AI模型,在不到一秒的时间内实现首个token的生成,并在2B参数模型上每秒处理超过10个token。在视频用例中,它使用YOLOv11m等模型实现了4K物体检测的领先性能。

Hailo 表示,通过实现本地处理,该芯片可以改善数据隐私,减少对云端 AI 服务的依赖,从而有助于降低运营成本。该芯片符合 AEC-Q100 2 级汽车标准,计划于 2026 年投入量产,应用于驾驶舱显示器和驾驶员监控单元等汽车系统。

Halio 是一家由风险投资支持的初创公司,已在九轮融资中筹集了 5.64 亿美元,其中包括2021 年 10 月的 1.36 亿美元。该公司的投资者包括 SKC Co. Ltd.、5AM Ventures LP、Versant Ventures LP、GPB Capital Holdings、Reedland Capital Partners 和三菱 UFJ Capital Co. Ltd.。

AI 芯片新贵 FuriosaAI赢得LG青睐

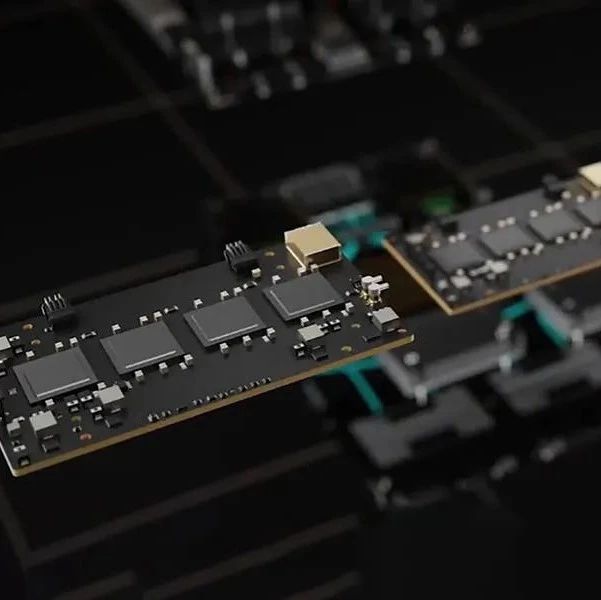

本周,韩国人工智能芯片初创公司 FuriosaAI 赢得了一个重要客户,此前 LG 的人工智能研究部门利用其人工智能加速器为运行 Exaone 系列大型语言模型的服务器提供动力。

虽然浮点计算能力、内存容量和带宽在 AI 性能中都扮演着重要角色,但 LG 选择 Furiosa 的 RNGD(发音为“renegade”)推理加速器并非为了速度和数据反馈,而是为了功耗效率。

LG AI 研究部门产品部门负责人 Kijeong Jeon在一份声明中表示: “RNGD 提供了一系列引人注目的优势:出色的实际性能、大幅降低的总体拥有成本以及令人惊讶的简单集成。”

快速浏览一下 RNGD 的规格表,你会发现这是一款相当普通的芯片,浮点性能在 256 到 512 teraFLOPS 之间,具体取决于你选择 16 位还是 8 位精度。内存容量也相当小,一对 HBM3 显存堆栈只有 48GB,带宽大约为 1.5TB/s。

与 AMD 和 Nvidia 的最新 GPU 相比,RNGD 的竞争力似乎并不强,但 Furiosa 仅用 180 瓦的功率就完成了所有这些工作。LG 的研究人员在测试中发现,在其自主研发的 Exaone 系列模型上,这些部件的能效比 LLM 推理 GPU 高达 2.25 倍。

在您兴奋不已之前,需要注意的是,这里讨论的 GPU 是 Nvidia 的 A100,它们的寿命已经相当长了——它们是在 2020 年疫情爆发时首次亮相的。

但正如 FuriosaAI 首席执行官 June Paik 告诉El Reg 的那样,虽然自 A100 首次亮相以来的五年里,Nvidia 的 GPU 确实变得更加强大,但这种性能却是以更高的能耗和芯片面积为代价的。

虽然单个 RNGD PCIe 卡在原始性能上无法与 Nvidia 的 H100 或 B200 加速器竞争,但就效率(每瓦可挤出的 FLOPS 数量)而言,这些芯片比您想象的更具竞争力。

Paik 将公司的效率优势很大程度上归功于 RNGD 的张量收缩处理器架构,他表示,与 GPU 相比,该架构执行矩阵乘法所需的指令要少得多,并且最大限度地减少了数据移动。

这些芯片还受益于 RNGD 对 HBM 的使用,Paik 表示这比依赖 GDDR 所需的功率要小得多,就像我们在 Nvidia 的一些低端产品(如 L40S 或 RTX Pro 6000 Blackwell 卡)中看到的那样。

RNGD 的算力约为每瓦 1.4 TeraFLOPS,实际上更接近 Nvidia 的 Hopper 一代,而不是 A100。如果我们将注意力转移到内存带宽上,RNGD 的效率就更加明显了,内存带宽可以说是 LLM 推理中更重要的因素。一般来说,内存带宽越大,它吐出令牌的速度就越快。

同样,RNGD 的内存速度为 1.5TB/s,速度不算特别快。Nvidia 的 H100 提供了 80GB 的更高容量和 3.35TB/s 至 3.9TB/s 的带宽。然而,该芯片的功耗却是后者的 2 到 3.9 倍。

功率与 H100 SXM 模块大致相同,可以拥有四张 RNGD 卡,总计 2 petaFLOP 的密集 FP8 计算能力、192GB HBM 显存和 6TB/s 的内存带宽。这仍然比 Nvidia 最新一代 Blackwell 部件略逊一筹,但比 RNGD 的原始速度和数据流表现得更接近了。

而且,由于 RNGD 的设计完全考虑了推理,因此模型实际上可以使用张量并行等技术分布在多个加速器上,甚至可以使用流水线并行分布在多个系统上。

LG AI 实际上使用了四块张量并行配置的 RNGD PCIe 卡,以 16 位精度运行其内部的 Exaone 32B 模型。据 Paik 介绍,LG 在验证该芯片的可用性时,设定了非常具体的性能目标。

值得注意的是,这些约束包括第一个令牌的时间(TTFT),它测量在 LLM 开始生成响应之前您必须等待的时间,对于较适中的 3,000 个令牌提示大约需要 0.3 秒,对于较大的 30,000 个令牌提示大约需要 4.5 秒。

如果你好奇的话,这些测试类似于中型到大型的总结任务,它们给芯片的计算子系统带来比较短的提示更大的压力。

LG 发现,它能够以每秒 1 个批次大小生成约 50-60 个令牌来实现这种性能水平。

据 Paik 介绍,这些测试是使用 FP16 进行的,因为 LG 对比的 A100 本身并不支持 8 位浮点激活。据推测,降至 FP8 会使模型的吞吐量翻倍,并进一步降低 TTFT。

使用多张卡确实会带来一些固有的挑战。尤其是张量并行,它允许模型的权重和计算分散到四张或更多张卡上,这需要相当多的网络资源。

与 Nvidia 的 GPU 不同,Nvidia 的 GPU 通常采用快速专有的 NVLink 互连技术,以每秒超过 1TB 的速度在芯片之间传输数据,而 Furiosa 则坚持使用旧的 PCIe 5.0,每张卡的最高速度为 128GB/s。

为了避免互连瓶颈和开销,Furiosa 表示,它优化了芯片的通信调度和编译器,以重叠芯片间直接内存访问操作。

但由于 RNGD 尚未分享更高批次大小的数据,因此很难判断这种方法的扩展性如何。他承认,在批次大小为 1 的情况下,张量并行运算的数量相对较少。

Paik 表示,在 64 个批次的情况下,单个性能应该只会下降 20% 到 30%。这意味着同样的设置应该能够实现接近每秒 2700 个令牌的总吞吐量,并支持相当多的并发用户。但由于缺乏确切细节,我们只能进行推测。

无论如何,Furiosa 的芯片足够好,LG 的 AI 研究部门现在计划向使用其 Exaone 型号的企业提供由 RNGD 驱动的服务器。

Jeon 表示:“在广泛测试了多种选项之后,我们发现 RNGD 是部署 Exaone 模型的一种非常有效的解决方案。”

与基于 Nvidia RTX Pro Blackwell 的系统类似,LG 的 RNGD 盒将配备最多八个 PCIe 加速器。这些系统将运行 Furiosa 所描述的高度成熟的软件堆栈,其中包括一个 vLLM 版本,这是一种流行的运行时服务模型。

LG 还将提供其代理 AI 平台 ChatExaone,该平台捆绑了一系列用于文档分析、深度研究、数据分析和检索增强生成 (RAG) 的框架。

Furiosa 的说服力远不止于 LG。你可能还记得,据报道,Meta 在今年早些时候曾出价 8 亿美元收购这家初创公司,但最终未能说服 Furiosa 的领导层交出“王国”的钥匙。

Furiosa 受益于对自主 AI 模型、软件和基础设施日益增长的需求,这些模型、软件和基础设施均在自主研发的硬件上进行设计和训练。

然而,要在全球范围内竞争,Furiosa 面临着一些挑战。最值得注意的是,Nvidia 和 AMD 的最新 GPU 不仅比 RNGD 提供更高的性能、内存容量和带宽,而且据我们估计,它们的能效也更高。得益于 Nvidia 早期对机架级架构的投资,其架构也支持更高的并行度,而我们现在才看到芯片制造商开始采用这种设计理念。

话虽如此,值得注意的是,RNGD 的设计过程始于 2022 年,当时 OpenAI 的 ChatGPT 尚未掀起 AI 热潮。当时,像 Bert 这样的模型在语言模型领域占据主流地位。然而,Paik 坚信 GPT 将会蓬勃发展,其底层架构将成为新的常态,这也为他做出使用 HBM 还是 GDDR 显存等决策提供了参考。

Paik 表示:“现在回想起来,我认为我应该做出更大胆的尝试,采用四个 HBM(堆栈),并在一个封装中放置更多的计算芯片。”

我们已经看到许多芯片公司,包括 Nvidia、AMD、SambaNova 等,都采用这种方法来扩展他们的芯片以超越光罩极限。

事后看来,Paik 表示,既然 Furiosa 已经成功证明了其张量压缩处理器架构、HBM 集成和软件堆栈,那么该公司只需要扩大其架构。

“我们拥有非常坚实的构建模块,”他说,“我们非常有信心,当你扩展这个芯片架构时,它将与所有最新的 GPU 芯片竞争。

参考链接

https://www.theregister.com/2025/07/22/sk_furiosa_ai_lg/

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

END

今天是《半导体行业观察》为您分享的第4103期内容,欢迎关注。

推荐阅读

加星标⭐️第一时间看推送,小号防走丢

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊