拆解英伟达1.6T的网络模块

- 2025-07-23 08:53:31

公众号记得加星标⭐️,第一时间看推送不会错过。

来源:内容编译自servethehome。

英伟达此前从A100 升级到H100 系列的一大变化是转向 PCIe Gen5。PCIe Gen5 拥有足够的带宽,可以从 200Gbps 网络过渡到 400Gbps 网络。NVIDIA DGX H100 采用了不同的网络方案,具体来说,它放弃了传统的 PCIe 卡,转而采用名为“Cedar”的模块。

每个 Cedar 模块板载四个 ConnectX-7 控制器。每个控制器提供 400Gbps 的网络带宽。DGX H100 中也有两个 ConnectX-7 控制器,用于连接 2 个 Cedar 模块,每个模块 4 个 ConnectX-7 控制器,每个控制器 400Gbps,即 3.2Tbps 的结构带宽。我们在订购单上没有找到这些控制器,但 SKU 表可以大致了解运行这些控制器所需的带宽。

在 DGX H100 中,这些 Cedar 模块配有专门设计的散热器,用于冷却组件,同时允许气流流向 CPU 和内存托盘的其余部分。这些散热器随后通过环绕 CPU 和内存的跨接电缆连接到后部机箱。在后部,DGX H100 可以使用直连铜缆(DAC)、有源光缆或标准光纤模块。

关于渲染图的简要说明。虽然很多人觉得这看起来像是 Sapphire Rapids,但我听说 NVIDIA 为 DGX H100 提供了不同的主板设计,而且 CPU 也尚未确定。我还听说 CPU 将是 x86 架构,所以要么是 Intel Sapphire Rapids,要么是 AMD Genoa,而不是 Arm 通过 Ampere 的下一代产品或 NVIDIA Grace。Grace 对于这个平台来说已经太迟了。

如果您想知道为什么不在 DGX H100 上使用 BlueField-3,NVIDIA 也提供了解决方案。除了两个 Cedar 模块和 8 个 ConnectX-7 400Gbps 控制器组合外,还配备了两个 PCIe BlueField-3 控制器。这两个 BlueField-3 控制器用于访问存储和用户平面等任务,而 Cedar 模块则专注于计算平面。

我问过 NVIDIA,为什么不直接为 DGX H100 使用标准 PCIe 或 OCP 尺寸的模块。使用 Cedar 模块主要是因为系统空间效率更高,因为它比在系统中添加 8 个 PCIe ConnectX-7 卡要紧凑得多。它还有助于 DGX H100 内部的空气流通。

虽然 Cedar 模块听起来可能非常奇特,但 NVIDIA 告诉我,该公司的网络团队已将其“广泛提供”,可供任何供应商在系统中使用。随着新一代 AI 模型的出现,所需的规模将大大扩大,因此为 AI 系统的计算平面提供大量带宽就显得尤为重要。正因如此,系统中配备了两个 Cedar 模块来提供巨大的带宽。

拥有 1.6Tbps 网络容量的 NVIDIA Cedar 模块内部

简单介绍一下,NVIDIA 为其 DGX 系统定制了网络模块。目前市面上大多数 HGX 8-GPU 平台都使用基于 PCIe 的 GPU,至少在即将推出的搭载 ConnectX-8 的 NVIDIA MGX PCIe 交换板(用于 8x PCIe GPU 服务器)和HGX B300 NVL16之前都是如此。虽然 NVIDIA 表示这些模块可供合作伙伴使用,但多年来大多数合作伙伴都使用了 PCIe NVIDIA ConnectX-7 网卡。Cedar 模块则有所不同,它采用定制的水平尺寸,并将线缆连接到系统后部的光纤机架。

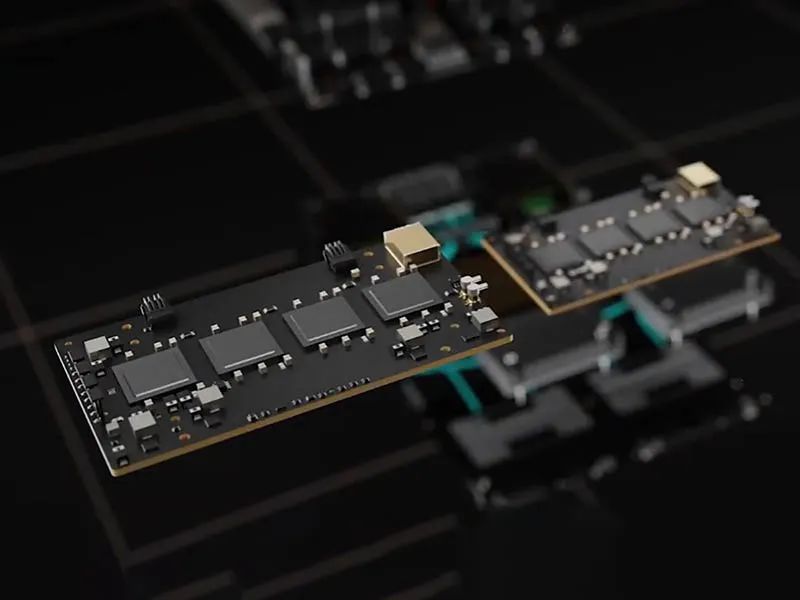

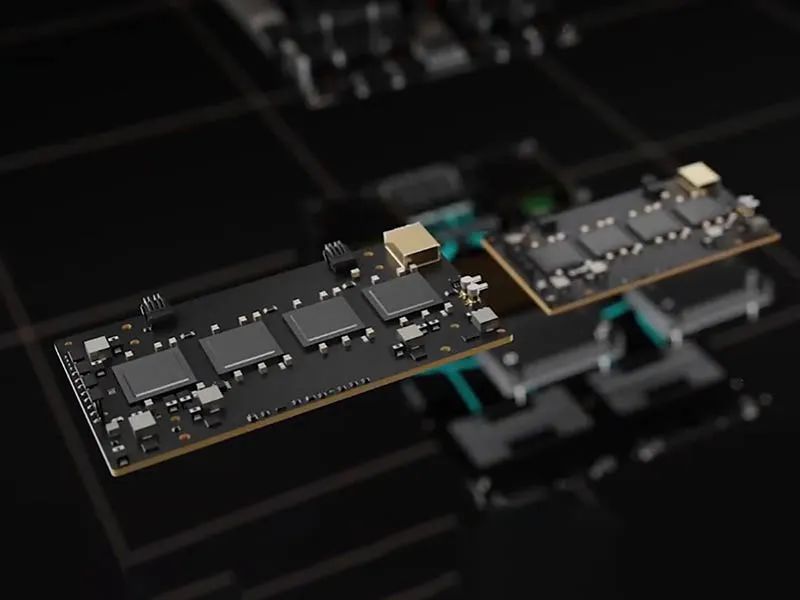

起初,我们对这些模块的最佳印象来自于一个宣传视频的截图。这些截图显然缺少了很多细节。

在 SC24 上,我们展示了Eviden 如何展示四核 NVIDIA ConnectX-7 Cedar 模块。然而,有一个挑战:这些模块如何安装在系统中。

现在我们拿到了真正的模块。这是顶部,上面装着一个用于风冷服务器的散热器。正如你所见,这些模块虽然在运输途中包装得很好,但经历了一段艰难的岁月。

在顶部,我们有四个 NVIDIA ConnectX-7 NIC。

每个都能够实现 400Gbps 的网络吞吐量。

我们经常看不到的是,NVIDIA 既有用于带外管理的连接器,也有用于跨机箱电缆的两个电缆接头。

这是顶部的端口。OOB 端口连接器的设计目的是为了实现性能较低的连接,因此它们相对简单。

这是端口 0 和 OOB 端口 0 的另一个角度。

这是 OOB 端口 1 和端口 1。

在底部,我们有定制的连接器。

在某些方面让人想起 SXM GPU、NVIDIA Grace SuperChip 和 NVIDIA Grace Hopper 部件底部的连接器。

这种做法的一大优势在于,它比八个 PCIe 网卡更加紧凑。在 DGX 环境中,这些定制的水平尺寸更容易制作散热器。或许更重要的是,水平网卡并排放置使得在模块上方放置单个液冷块变得更加容易。这最大限度地减少了系统中冷却板和液冷连接的数量。

这件东西简直可以用“精巧”来形容。这些部件都是定制的,业内只有少数人会用。因此,很多人还没见过这些模块。我们有机会弄到一对,把冷却器拆下来,所以觉得虽然它们的状态不太好,但我们觉得它们仍然很有意思。

未来,HGX B300 的出现将大大降低此类模块的实用性。

参考链接

https://www.servethehome.com/inside-the-nvidia-cedar-module-with-1-6tbps-of-networking-capacity-connectx-7/

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

END

今天是《半导体行业观察》为您分享的第4103期内容,欢迎关注。

推荐阅读

加星标⭐️第一时间看推送,小号防走丢

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊