科学已死?顶刊产出暴增500倍,诺奖级突破却停滞不前,AI 正让科学界陷入高产出、低进步的死亡螺旋

- 2025-07-17 17:36:31

在 AI 浪潮席卷一切的今天,这篇来自 Sayash Kapoor 与 Arvind Narayanan 的深刻分析,如同一剂清醒剂。它勇敢地挑战了AI 加速科学的普遍乐观,揭示了产出与进步之间日益扩大的鸿沟。

我将其译为中文,希望能将这份宝贵的、反直觉的洞见分享给更广大的读者。

AI 会拖慢科学的脚步吗?直面产出与进步的悖论

SAYASH KAPOOR 与 ARVIND NARAYANAN

2025年7月17日

人工智能领域的领袖们描绘了一幅宏伟蓝图:AI 将引领科学实现戏剧性的飞跃。他们预言,我们将能治愈癌症、将人类寿命延长一倍、成功殖民太空,并在未来十年内,完成过去一个世纪才能取得的进步。

这个愿景的出现恰逢其时。考虑到美国联邦科研经费的削减,AI 似乎能完美地取代对庞大科研队伍的需求,成为推动科学发展的核心动力。

至少在技术专家看来,AI 会极大地加速科学发展,这是一个不言自明的常识。他们相信,AI 将全面渗透到科研的每一个环节:从总结文献、激发新想法,到数据分析、实验验证,再到撰写论文,乃至执行同行评审。

然而,历史一再警示我们,许多关于新技术影响的早期预测,最终都错得离谱。

同样,AI 对科学的影响,也可能完全超出我们的直觉。即便个别科学家能从 AI 中获益,也并不意味着整个科学事业会因此繁荣。

当我们从宏观视角审视,科学是一个具有涌现性的复杂系统。它的行为方式常常出人意料,因为它并非一个纯粹的市场。它在奖励真理方面比市场更胜一筹,但在应对技术冲击等其他方面,却显得更为脆弱。

目前来看,AI 对科学造成的是一次不健康的冲击,许多沿用已久的科研流程,都因此被推到了崩溃的边缘。

任何严肃预测 AI 影响的尝试,都必须直面一个核心矛盾:产出-进步悖论。

科学论文的发表数量呈指数级增长,从 1900 年到 2015 年翻了 500 倍。然而,用任何标准来衡量,科学的实际进步速度却几乎停滞,甚至在放缓。

我们必须探究,AI 究竟在如何影响导致这种脱节的深层因素。我们的分析表明,AI 很可能会进一步加剧这种鸿沟。

这并非定论,也未必适用于所有科学领域。如果我们能立刻采取下文建议的措施,或许还能扭转乾坤。

然而不幸的是,无论是 AI 公司、科研资助机构,还是政策制定者,似乎都对科学进步的真正瓶颈视而不见。

他们一味地试图加快产出,这无异于给一条高速公路增加车道,而拥堵的真正原因其实是下游的收费站。 这必将让情况雪上加霜。

目录

科学一直在放缓:产出-进步悖论 进步为何放缓?AI 能否助力? 科学尚未为软件做好准备,遑论 AI AI 或将延长人类对错误理论的依赖 人类的理解力,依然是核心要素 对科学未来的深远影响 结语

一、科学一直在放缓:产出-进步悖论

已发表论文的总数正呈指数级增长,大约每 12 年就翻一番。而发表过论文的研究者总数,增长速度甚至更快。

从 2000 年到 2021 年,全球七大科研资助国(美、中、日、德、韩、英、法)的研发总投入,也惊人地增长了四倍。¹

但这是否就意味着更快的进步?答案是否定的。有些论文能带来改变科学轨迹的根本性突破,而另一些,仅仅是对已知结果的微小改良。

真正的进步,源于我们理解力的突破。

比如,上世纪中叶,我们理解了板块构造学——即大陆是持续移动的。在此之前,地质学家们甚至连正确的问题都提不出来。他们试图解释地球冷却造成的影响,误以为山脉等宏伟地貌由此形成。

在旧的地质学范式下,再多的论文也无法带来与板块构造学同等量级的进步。

因此,完全可能出现一种情况:论文数量指数级暴涨,而进步的速度却并未同步,甚至不增反降。我们如何才能证实这一点?

一个巨大的挑战是,进步不像研究产出那样,拥有清晰、客观的衡量标准。

幸运的是,一个名为元科学(或称“科学的科学”)的完整研究领域,正致力于解答这个问题。元科学运用科学方法来研究科学本身,它关注诸如:研究的可复制性有多高?学术激励机制如何影响科学产出?以及,科学进步的真实速度究竟有多快?

两张图表并排显示,左图的标题是“论文数量和作者数量呈指数级增长”,显示两条急剧上升的线。右图标题是“论文的颠覆性随时间下降”,显示一条逐渐下降的线。

两张图表并排显示,左图的标题是“论文数量和作者数量呈指数级增长”,显示两条急剧上升的线。右图标题是“论文的颠覆性随时间下降”,显示一条逐渐下降的线。左图:论文发表数量和作者数量均呈指数级增长。右图:论文的颠覆性随时间推移而下降。

令人震惊的是,元科学的诸多发现都指向同一个结论:尽管资金、论文和科研人员数量急剧增加,科学进步的步伐确实在放缓。 以下是一些关键证据:

Park 等人的研究发现,颠覆性的科学工作在总产出中的占比越来越小。尽管论文和专利数量呈指数增长,但突破性成果的数量几乎没有变化。

Milojevic 的研究则将新术语的出现视为科学认知边界拓展的标志。他发现,该指标在 21 世纪初达到顶峰后,便进入了停滞期,论文标题中出现的新词汇反而减少了。

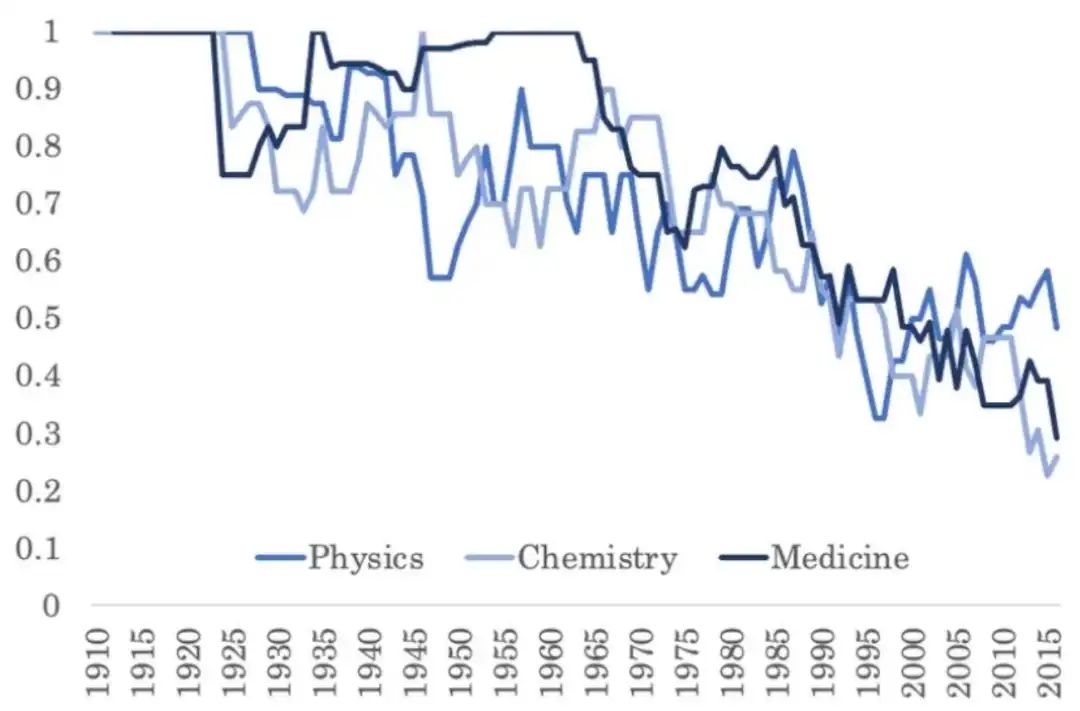

Patrick Collison 和 Michael Nielsen 调查了不同领域的诺贝尔奖得主,请他们评估自己领域最重要的突破。结论是,无论在医学、物理还是化学领域,科学家们普遍认为,早期几十年的成果与近期的成果相比,其重要性不相上下。

Matt Clancy 的分析更为直观。他统计了每年诺奖成果中,有多少是在过去 20 年内发表的。他发现,这一比例从 1970 年的 90% 骤降至 2015 年的 50%。这暗示着,要么是变革性发现的产出变慢了,要么是其价值被认可的时间变长了。

描述每年诺贝尔奖获奖工作的论文中,发表于此前 20 年的比例。图为 10 年移动平均线。

Bloom 等人从经济学视角也得出了类似结论。他们发现,尽管研究人员数量呈指数增长,但经济增长率并未同步提升,这意味着每位研究人员的创新效率正在急剧下降。

研究生产力的衰退。 图中的“生产力”并非基于论文数量,而是基于更能反映真实进步的指标。

当然,上述每项指标都并非完美,它们都只是衡量“进步”的代理指标。

例如,Park 等人用于衡量“颠覆性”的引文模式,可能仅仅反映了学术引用习惯的变迁。事实上,他们的指标未能识别出像 AlphaFold 这样的重大突破。²

但将所有证据拼凑起来,一幅清晰的图景浮现了:与投入的巨量资源相比,科学进步的速度确实在放缓。

科学进步放缓的几条主要证据链总结

二、进步为何放缓?AI 能否助力?

关于进步放缓的原因,存在多种假说。其中一类观点较为宿命,认为这是科学发展的内在规律,比如低垂果实假说——最容易的发现已经被摘取,剩下的问题自然越来越难。

这个想法很符合直觉,但难以令人信服。历史上,我们一次又一次地在科学革命前夜,错误地判断某个领域已趋于饱和,19 世纪 90 年代的物理学就是典型的例子。

更重要的是,虽然低垂的果实会被先摘完,但我们也在不断创造新的工具,站在知识的巨人肩膀上,去触及更高的果实。我们实际上总是在发现新的果树,因此总有新的低垂果实等待采摘。

另一类假说则不那么悲观。它们认为,问题出在我们组织科学实践的方式上,是体制效率的下降导致了投入与进步的脱节。

其中一个极具启发性的观点是:科学之所以放缓,恰恰是因为它试图走得太快。

这是怎么回事?关键在于科学家的注意力是有限的。当每年发表的论文数量过于庞大,新思想的洪流反而会迫使学者们将注意力集中在那些早已成名的、高被引的论文上。

任何偏离学术经典的、具有突破潜力的论文,都极易被淹没在信息的噪音中,难以获得足够的关注,从而无法脱颖而出。

正如 Chu 和 Evans 所言:“大量新出版物的涌入非但没有加速领域范式的更迭,反而巩固了顶级被引论文的地位,阻碍了新工作进入被广泛引用的、众所周知的领域经典之列。”

另一个相关的因果机制,是不发表,就出局的学术激励体系。

因为产出(如论文数量)容易衡量,而进步难以衡量,大学和科研机构便倾向于用前者来评判学者。这种对产出指标的过度强调,似乎还在不断恶化。

物理学诺奖得主彼得·希格斯就曾感慨,在当今的学术环境下,他可能连一份工作都找不到,因为他会被认为产出不够高。

这种机制迫使研究人员规避风险,追求更容易发表的、安全的、增量式的研究,而不是那些可能带来真正突破但风险极高的探索。

这就形成了一个恶性循环:职业激励促使学者发表更多论文,而海量的论文又进一步加剧了注意力的稀释,最终抑制了真正新颖、突破性的研究。

那么,如果进步放缓的根源在于产出过剩,AI 的加入会带来什么?

答案显而易见:AI 将使追逐无意义生产力指标变得前所未有的容易,从而让情况变得更糟。

AI 可能会让个体研究者更高效,但其同质化效应则可能削弱整个科学界的集体创造力。它会加剧注意力的不平等,让新思想的突围之路,变得愈发艰难。

三、科学尚未为软件做好准备,遑论 AI

AI 在科研中的应用,本质上大多属于软件开发。

然而不幸的是,科学家群体普遍是糟糕的软件工程师。在业界早已成为标准的自动化测试、版本控制等实践,在学术界却往往付之阙如或被随意对待。

更严重的是,科学论文的同行评审,几乎从不审查其背后的代码,尽管在计算研究中,真正的科学恰恰就隐藏在代码和数据里。

研究人员不分享代码和数据的现象也极为普遍。一项研究发现,在 1800 篇承诺分享数据的生物医学论文中,高达 93% 未能兑现。

即便代码被分享出来,也往往错漏百出。即便是 Excel 这样简单的工具,也曾在遗传学等领域引发大规模错误,比如基因名被自动更正为日期。整个科学界花了数十年时间,才学会如何负责任地使用基础的统计学。

AI 则打开了一个全新的潘多拉魔盒。

使用 AI 工具的门槛,远低于深入理解并识别其错误所需的专业能力。这意味着,AI 很可能在科学界引发一场错误的雪崩。

事实上,这已经发生了。早在生成式 AI 之前,传统机器学习就已在数百篇论文中导致了错误。在某些领域,绝大多数由 AI 赋能的研究,可能都是有缺陷的。

为什么科学界在软件工程实践上如此滞后?

因为在商业世界,代码的错误会直接导致产品失败和市场份额的流失,企业有强烈的动机去确保软件质量。而在学术界,纠正错误研究的激励微乎其微,导致许多错误结果可以持续存在数年之久。

这并非要将科学完全市场化,而是提醒我们,当科学与产业出现能力差距时,科研机构必须有意识地引入最佳实践,以保障科学的健康发展。

简而言之,科学界需要尽快补上长达半个世纪的软件工程课程。 否则,它对 AI 的拥抱,只会为进步制造阻力,而非顺风。

当然,AI 也可以成为解决方案的一部分。例如,利用 AI 自动检测论文中的错误,或辅助研究人员遵循最佳编程实践。

但这一切的前提是,期刊、大学和资助机构必须进行干预,将激励的重心从单纯的产出,转向对质量控制、知识综合与错误检测的鼓励。

四、AI 或将延长人类对错误理论的依赖

AI 建模与传统科学建模有着根本的不同。传统方法需要先提出一个关于世界如何运作的假说,再用模型去验证和修正它。

而 AI 建模则像一个黑箱。它绕过了建立理解的过程,直接利用过去的数据,去优化对未来的预测准确性。

在商业应用中,这种对预测的极致追求无疑是有效的。但在以探求真理为目标的科学领域,这可能是一种倒退。

我们可以用天文学中的地心说来类比。地心说模型曾是一个预测能力极强的模型,它通过引入名为本轮的复杂修正,能非常精确地预测行星的运行轨迹。

每当观测与预测出现偏差,天文学家就再增加一个本轮来修补模型。这个模型是如此成功,以至于许多现代天文馆至今仍在使用它来计算行星轨迹。

两张图并排显示,左图展示了复杂的地心说模型,行星在围绕地球的轨道上还有许多小圈(本轮)。右图展示了更简单的日心说模型,所有行星都围绕太阳运转。

两张图并排显示,左图展示了复杂的地心说模型,行星在围绕地球的轨道上还有许多小圈(本轮)。右图展示了更简单的日心说模型,所有行星都围绕太阳运转。左图:地心说模型因引入大量本轮而变得异常复杂。右图:日心说模型则展现出无与伦比的简洁之美。

那么,人类是如何从地心说迈向日心说的?

答案并非通过比较两个模型的预测准确性——因为它们的准确度不相上下。真正的突破,是因为日心说为行星运动提供了一个远为简洁、深刻的解释。

这一步的跨越,依靠的是理论上的跃迁,而非预测精度的提升。

现在,让我们回到 AI。AI 毫无疑问是提升预测准确性的利器。但它本身,并不能自然地导向对现象更深层次的理解。

AI 就像一个现代本轮的超级生产者,它可能让科学家们在一个错误的理论框架内,做出越来越精准的预测,从而陷入预测即解释的谬误。

如果 AI 使得错误的理论能做出更准确的预测,它就可能延长我们对这些理论的依赖,从而极大地延缓科学的根本性进步。

没有理解的预测:一项研究表明,一个在 1000 万个行星轨道数据上训练的 AI 模型,能出色地预测轨道,但它并未能发现产生这些轨道的底层引力定律。

五、人类的理解力,依然是核心要素

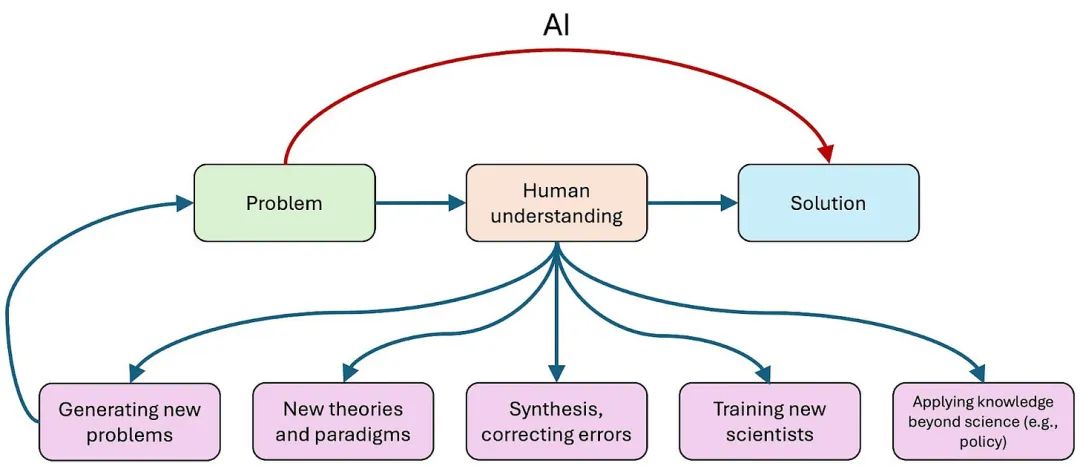

在解决科学问题的过程中,获得解决方案似乎是最终目的,而科学家在此过程中建立的理解,似乎只是一个中间步骤。

但现实恰恰相反。解决问题和发表论文,更像是一种仪式,其通往的真正奖赏,是人类的理解力。没有这种理解,就不会有真正的科学进步。

菲尔兹奖得主威廉·瑟斯顿曾精彩地阐述过这一点。他认为,数学的意义,远不止是得出答案,更重要的是建立人类的理解。

……数学家们真正在做的,是为人们理解和思考数学寻找方法。

计算机的崛起戏剧性地凸显了这一点。例如,当四色地图定理通过大规模计算被证明时,引发了巨大争议。我認為,这并非源于人们对定理真实性的怀疑,而是反映了一种深切的渴望:在知晓答案之外,我们还希望能有一个人类能够理解的证明。

在日常层面,人们常常发现,用计算机大规模计算出的答案并非他们真正想要的东西。他们最终认识到,他们真正想要的,通常不是答案的集合——他们想要的是理解。

瑟斯顿接着讲述了自己的亲身经历。当他在叶状结构理论这一热门领域证明了一系列核心定理后,反常的一幕发生了:人们开始纷纷逃离这个领域。

人们告诉我,我正在扼杀这个领域。研究生们不再研究它,很快,我自己也转向了其他方向。

我不认为这种撤离是因为这个领域在智力上已被榨干——至今仍有许多有趣的问题悬而未决。真正的原因是,我的研究成果是以一种令人生畏、难以理解的方式写成的。

同时,学术界的激励机制只奖励证明定理的人。当最重要的定理已被证明,其他人便失去了深入理解这个领域的动力,因为他们无法借此获得学术声誉。

这个故事深刻地揭示了:当获得解决方案与建立人类理解这两者发生脱节时,一个领域可能因此停滞甚至死亡。

这正是 AI 可能带来的根本性风险。通过自动化地解决问题,AI 可能会侵蚀科学进步的真正基石——人类的理解。

如果我们用 AI 来短路这个建立理解的艰苦过程,就好比在健身房里使用叉车。你当然能用它举起更重的重量,但那根本不是你去健身房的目的。

AI 可能会短路建立人类理解的过程,而这对于科学进步至关重要。

当然,并非所有科学领域都像纯数学那样,以人类理解为最终目标。但在大多数领域,如果我们用 AI 绕过了理解,甚至只保留了理解的幻觉,我们将可能失去培养新一代科学家、发展新理论、综合并纠正已有知识,乃至提出新问题的能力。

六、对科学未来的深远影响

过去十年,科学家们以惊人的速度拥抱 AI,这种速度牺牲了科学体制进行自我调整、建立质量控制规范的一切可能。

结果是,这一趋势很可能会加剧产出-进步悖论,我们发表论文的速度越来越快,但在通往真正科学进步的道路上,却可能越陷越深。

在 2012 年至 2022 年间,使用 AI 的论文数量在 20 个领域中翻了两番——这甚至是在大语言模型普及之前。

那么,科学界应如何应对?

改变科研实践

身处一线的科研人员,在采用 AI 时应更加审慎。草率地使用 AI 或许能带来短期利益,但长远来看,会严重阻碍真正有意义的科学成就。

当然,我们深知个人研究者只是在理性地遵循现有激励机制。因此,真正的变革力量,掌握在期刊、大学、资助机构和政策制定者手中。

大力投资元科学

元科学的研究揭示了科学进步放缓这一惊人事实。但我们对其背后的原因和机制,理解得还远远不够。

考虑到整个科学事业可能正面临着数个数量级的效率衰减,目前对元科学的投资,显得微不足道得令人痛心。

改革激励机制

不发表,就出局的弊病,人尽皆知。改革之所以屡屡失败,除了惯性之外,更深层的原因是:真正的进步,往往只能在数年甚至数十年后才能被识别,这与当下的考评周期完全错配。

但好消息是,随着 AI 让发表论文的成本趋近于零,我们或许将被迫放弃以数量作为衡量标准。

未来的学术评价,或许应更侧重于那些难以被 AI 自动化的工作,比如提出新的理论、创建新的研究范式。

反思 AI 科研工具

对于大型 AI 公司推出的科研工具,我们必须认识到其背后错位的激励机制。他们需要“AI 发现 X!”这样轰动的头条新闻,来维持其无所不能的叙事,从而换取政策上的优待。

因此,我们应对这类新闻时刻保持警惕,其中许多都被严重夸大了。

如果 AI 工具的开发者真心希望帮助科学,我们建议:请瞄准真正的瓶颈,而不是再开发一个文献综述工具。比如,开发能自动发现代码错误的工具,或者能增进人类理解的工具。

评估这些工具的方式也亟待改变。我们不仅要问“它是否节省了时间?”,更要问“它对研究者的理解力有何影响?”以及“它的广泛使用会对整个学术生态带来什么集体性后果?”

目前的评估体系完全忽略了后两个维度,这注定会提供一个极不完整且充满偏见的图景。

七、结语

作为科研人员,我们自己也在日常工作中充满热情地使用 AI。这种身处其中的兴奋感,很容易让我们忘记一个核心区别:AI 对个体科学家的影响,和它对整个科学体制的影响,是两个截然不同的问题。

我们在此处表达的审慎,与我们之前文章的观点一脉相承。在商业世界,市场机制提供了某种程度的质量控制,劣质的 AI 应用会迅速失败。

但在科学领域,新技术的采用和质量控制的过程是脱节的,前者要比后者快得多。

我们对科学的长期未来保持乐观,相信其规范和流程终将迎头赶上。

但就目前而言,这将是一段相当颠簸的旅程。

我们由衷感谢 Eamon Duede 对本文草稿提供的宝贵反馈。

¹ 数据来源于七大研发资助国(美国、中国、日本、德国、韩国、英国和法国)。

² AlphaFold 未被该指标识别为颠覆性成果,常被用作反例。但值得注意的是,AlphaFold 严重依赖于其引用的 17 篇现有研究,因此不完全符合该指标对“颠覆性”的定义。这可能反映了该指标的局限性,也可能说明 AlphaFold 的贡献更多是综合性的,而非纯粹的颠覆。

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊