聊聊大模型推理系统之Hermes:华为云携手高校,推动LLM服务智能化落地

- 2025-07-08 22:45:32

全文约 1800 字,预计阅读时间 5 分钟

随着大语言模型在各行各业的应用日益广泛,如何高效地服务这些模型成为学术界和工业界的共同挑战。最近,由上海交通大学与华为云联合研究团队提出的新系统——Hermes,通过概率需求建模显著提升了 LLM 应用的服务效率,平均完成时间减少超过70% ,尾部延迟降低超过80% 。

本文将带您快速了解这项研究的核心亮点、背景、方法贡献及其行业意义。

核心看点

Hermes 系统首次引入概率需求图(Probabilistic Demand Graph, PDGraph),以结构化方式对 LLM 应用的需求进行建模,解决了传统调度策略无法应对的动态性和不确定性问题。 基于 PDGraph,Hermes 采用 Gittins 策略优化任务排队顺序,最小化平均应用完成时间;同时,结合最少松弛时间优先(Least Slack Time First, LSTF)算法处理具有明确截止时间的任务。 系统还通过后端预热机制,有效缓解冷启动延迟,从而进一步提升整体执行效率。

研究背景

行业痛点

传统的 LLM 服务系统(如 vLLM、Parrot 等)通常采用先来先服务(FCFS)或公平分配资源策略进行调度,但这类方法存在以下问题:

队列效率低下:由于 LLM 应用的任务结构和资源需求高度动态,静态调度策略容易导致头部阻塞,影响整体完成时间。 后端冷启动延迟:LLM 应用常涉及多种异构后端(如 Docker 容器、KV 缓存等),而现有系统缺乏有效的预热机制,导致冷启动延迟显著增加应用响应时间。

创新切入点

为解决上述问题,本研究提出了Hermes 系统,其核心思想是通过概率需求建模实现对 LLM 应用需求的精准预测,并在此基础上进行智能调度与资源预热。该方法不仅考虑了任务之间的依赖关系,还利用历史执行数据不断优化预测精度,实现了更高效的调度与资源配置。

核心贡献

方法创新

1. 提出概率需求图(PDGraph)

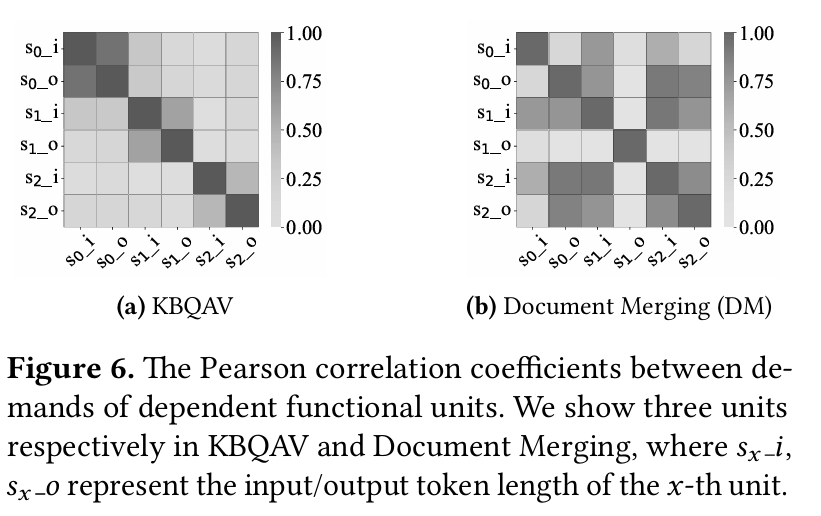

模块化设计:将 LLM 应用拆分为多个功能单元,每个单元描述其所需的资源类型、消耗量以及与其他单元的概率转移关系。 动态建模能力:支持不同后端类型和任务结构的通用建模,适用于各类 LLM 应用场景。 在线估计优化:结合历史执行数据与当前运行状态,持续更新需求预测,提升调度准确性。

示例:在文档合并(Document Merging)应用中,合并请求的输出长度约为 1000 token,而生成查询请求的输出长度则集中在 10~50 token 之间,体现了 PDGraph 对任务稳定性的建模能力。

2. 引入Gittins 策略优化调度

理论基础:Gittins 策略被证明是最小化平均完成时间的最优调度策略,尤其适用于资源需求不确定的任务。 调度优先级计算:通过计算 Gittins 指数(Gittins Index),系统能动态调整任务优先级,避免因过早结束长时间任务而浪费资源。

实验结果表明,在 FacTool-KBQA 和 Code Generation 两种任务并行时,Gittins 策略相比 SPRT 策略能提升高达16% 的完成率。

3. LSTF 算法应对有截止时间的任务

定义松弛时间:S = 截止时间 - 当前时间 - 预期剩余执行时间 优先级排序:按松弛时间升序排列,优先处理最紧急的任务,最大化按时完成率。

在 Deadline 驱动场景下,Hermes-DDL 版本相较 EDF 调度策略,DDL 满意度比率(DSR)提升 1 倍以上。

理论突破

首次将 Gittins 策略应用于 LLM 调度,填补了传统调度理论在不确定性任务中的空白。 构建 PDGraph 数学模型,形式化描述 LLM 应用的功能单元、资源需求及依赖关系,为后续研究提供理论基础。

实证成果

单 GPU 实验:在 LLaMA2-7B 模型上,Hermes 将平均应用完成时间从76.7 秒降至17.4 秒(提升77.3% )。 多 GPU 实验:在 LLaMA3-70B 模型上,Hermes 在高负载下仍将 P95 完成时间控制在62.2 秒以内(对比 VTC 提升45.8% )。 KV 缓存命中率提升:相较 LRU 与 EPWQ 策略,Hermes 分别提升1.11×与0.33×的缓存命中率。 LoRA 缓存命中率提升:相较 EPWQ,Hermes 提升**21.1%**的 LoRA 缓存命中率,加速模型加载过程。

行业意义

推动 LLM 服务技术路线演进

提升调度智能化水平:Hermes 通过引入概率建模与动态调度策略,为未来 LLM 服务系统的智能化发展提供了新方向。 支持多样化后端集成:系统可灵活适配 LLM 与非 LLM 后端(如 Docker、ViT、Diffusion 模型等),推动多模态 AI 应用落地。

与国家标准接轨

符合《新一代人工智能发展规划》中关于“提高算力使用效率”“推进智能服务标准化”的政策导向。 支持绿色低碳目标,通过优化资源利用率降低能耗,契合碳中和战略。

引发产业变革

自动驾驶领域:提升车载 LLM 推理效率,增强实时交互能力。 金融风控场景:加快复杂文本分析与决策流程,提高风险识别速度。 医疗辅助诊断:缩短病历理解与报告生成时间,助力智慧医疗建设。

论文链接与作者背景

论文标题:Efficient Serving of LLM Applications with Probabilistic Demand Modeling 论文地址:https://arxiv.org/abs/2506.14851 第一作者:刘义飞,上海交通大学计算机系博士研究生,深耕分布式系统与 AI 系统优化领域多年。 通讯作者:陈晨,上海交通大学教授,主要研究方向包括大规模机器学习系统与边缘计算。

结语

Hermes 的提出标志着 LLM 应用服务进入了一个全新的智能调度时代。通过概率需求建模、Gittins 策略调度与后端预热机制,Hermes 不仅提升了服务效率,也为未来 LLM 系统的设计提供了坚实的技术基础。相信随着 Hermes 的推广与落地,我们将见证更多高性能、低延迟的 LLM 应用在各行业中开花结果。

推动智能调度变革,Hermes 正在引领 LLM 服务新范式!

-- 完 --

机智流推荐阅读:

1. 一起聊聊Nvidia Blackwell新特性之低比特GEMM

2. 硬刚GPT-4o?阿里开源Ovis-U1:30亿参数实现理解、生成、编辑三位一体,性能刷新SOTA榜单!

3. 中山大学&华为联合提出 Issue Resolution 数据集构建神器SWE-Factory:每条只要$0.024

4. 重磅!谷歌DeepMind等推出BlenderFusion:打通3D图形学与生成AI,实现电影级视觉合成控制!

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

在「机智流」公众号后台回复下方标红内容即可加入对应群聊:

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊