刚刚,实体清单上的独角兽反击!智谱 GLM-4.5 用实力回答美国禁令,高而窄MoE架构首次实战,SWE-bench屠榜!

- 2025-07-29 17:01:07

昨天,智谱 AI发布了一款引人注目的开源模型 GLM-4.5,它的目标直指未来的智能体应用。

核心看点

它提供了 3550 亿和 1060 亿两种参数规模的版本,但其架构十分巧妙。

采用混合专家模型技术,每次运行时只激活一小部分(320 亿或 120 亿)的权重。这意味着更低的显存占用和运行成本。

128K 的超长上下文窗口,让它在处理长篇文档或复杂的工具调用时,也能保持思路清晰,不会中途失忆。

它还有一个聪明的双模式设计:思考与非思考。只有遇到真正复杂的难题,需要深度推理时,它才会全力计算,保证了日常任务的响应速度。

令人惊讶的是,它对硬件的要求并不高,仅需 8 块英伟达 H20 芯片就能运行,是竞争对手 DeepSeek 模型的一半。

在 12 项涵盖推理、编码和智能体任务的 AI 基准测试中,它综合实力排名全球第三。

这里提到的 H20 芯片,是英伟达为了应对美国出口限制,专为中国市场定制的 AI 处理器。尽管性能有所缩水,但对 AI 训练依然堪用,这也是目前国内公司能合法采购到的现实选择。

它的强大,在于集成了三大核心能力于一身:严谨的结构化推理、强大的代码生成、以及流畅的内置函数调用。

这意味着它既能解决复杂问题,也能修复真实的软件漏洞,还能无缝对接外部工具,让智能体的开发变得空前简单。

在高手如云的 12 项高难度推理测试中,它冲上了综合排行榜第三名;即便是轻量版,也稳居第六,实力不容小觑。

学术能力上,它在 MMLU Pro、AIME24 和 GPQA 等多项基准测试中的得分,已非常接近 GPT-4 级别。

实战能力上,它能修复超过 64% 的软件工程类错误,并在真实终端操作测试中表现出色,证明了其强大的“动手能力”。

在模拟真人浏览网页和操作工具的测试中,它的准确率甚至超越了 Claude-4 Opus,展现了出色的自动化导航本领。

它的函数调用成功率高达 90.6%,优于 Claude-4 Sonnet,这意味着基于它构建的智能体工作流将更加稳定可靠。

这一切优异表现的背后,是其独特的高而窄混合专家模型架构。 它通过收缩每个专家的宽度、但大幅增加网络层数的方式,在保证推理能力的同时,实现了计算资源的极致节省。

它的训练方式也很有新意,依赖一个名为 “Slime” 的开源强化学习框架,能高效、稳定地提升模型能力。

同时,它还利用推测解码等技术,在不影响质量的前提下,让模型的响应速度更快一步。

最关键的是,模型权重和代码已经完全开放,并提供与 OpenAI 风格兼容的接口,让所有开发者都能轻松上手,快速融入现有工作流程。

背景

尽管智谱 AI 仍在美国的实体清单上,但这并未阻碍它获得来自阿里巴巴、腾讯和中国政府基金的 15 亿美元投资,并为上市做准备。

不容忽视的趋势

截至 2025 年 7 月,中国已发布了超过 1500 个大语言模型,数量全球第一。本土公司正积极利用开源策略,从价格和生态上挑战西方竞争者。

一个信号

GLM-4.5 的成功表明,美国的芯片限制或许并没能完全扼制中国 AI 的发展步伐。这无疑会给西方巨头带来巨大压力,迫使他们必须重新思考价格策略,或寻找新的护城河。

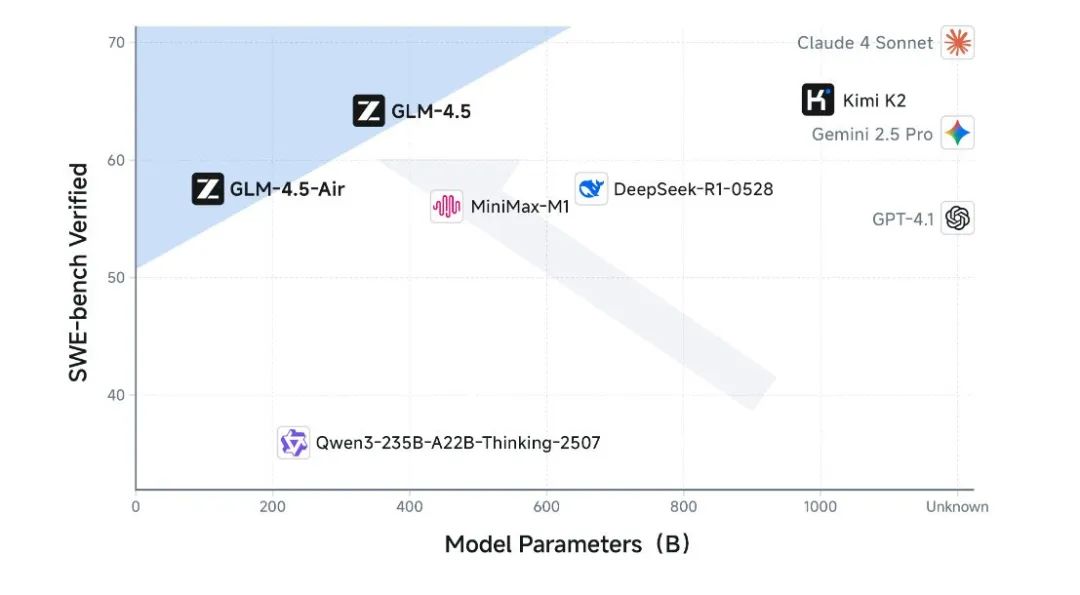

帕累托最优分析

这张图清晰地揭示了 GLM-4.5 的优势所在。它比较了各个模型修复软件 bug 的能力和自身的参数规模。

GLM-4.5 和它的轻量版都位于图表的左上角高效区。

这说明,它们用远小于竞争对手的参数规模,达到了顶尖的性能水平,实现了真正的“降本增效”。

参考资料:

技术报告:https://z.ai/blog/glm-4.5

Hugging Face:https://huggingface.co/zai-org/GLM-4.5

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊