NVIDIA最新!ThinkAct:复杂的具身任务中实现少样本适应、长时程规划

- 2025-07-25 08:00:00

点击下方卡片,关注“具身智能之心”公众号

作者丨Chi-Pin Huang等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

写在前面&出发点

VLA推理任务要求智能体解读多模态指令、执行长时程规划,并在动态环境中自适应地行动。现有方法通常以端到端的方式训练VLA模型,直接将输入映射到动作,而不进行显式推理,这限制了它们在多步骤规划或适应复杂任务变化方面的能力。

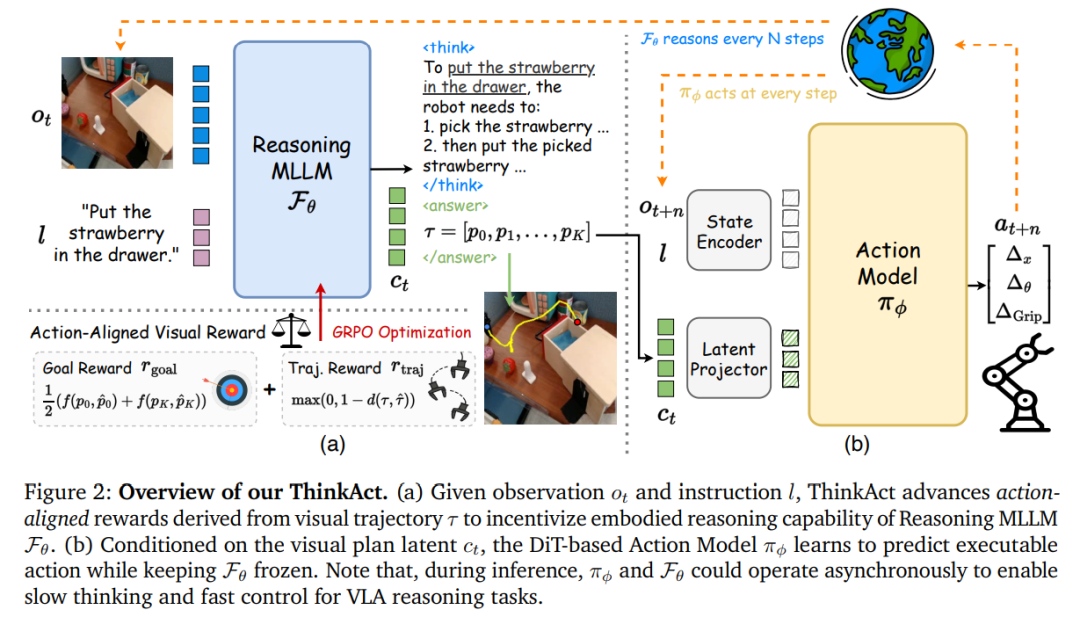

这里提出了ThinkAct:一个双系统框架,通过强化视觉潜在规划将高层推理与低层动作执行连接起来。ThinkAct训练多模态大型语言模型(MLLM)生成具身推理planning,该planning由基于目标完成度和轨迹一致性的动作对齐视觉奖励引导。

这些推理planning被压缩为视觉planning潜变量,为下游动作模型提供条件,以实现目标环境中的稳健动作执行。在具身推理和机器人操作基准测试上的大量实验表明,ThinkAct能够在复杂的具身AI任务中实现少样本适应、长时程规划和ego修正行为。

项目页面:https://jasper0314-huang.github.io/thinkact-vla/

领域介绍

多模态大型语言模型(MLLMs)的最新进展催生了在各类需要理解多模态输入的任务上的显著进步,例如视觉问答和图像/视频字幕生成。然而,尽管多模态内容现在能够被有效感知和解读,但为长时程用户目标进行多步骤规划并与动态环境交互,对前沿MLLMs来说仍然具有挑战性。因此,使视觉-语言基础模型具备动作感知和具身推理能力,将释放大量物理AI应用(如机器人技术和增强现实辅助)的潜力,并引起学术界和工业界的广泛关注。

为了将动作与视觉-语言模态连接起来,一些研究通过从预训练的MLLMs初始化并在大规模机器人演示数据(如Open XEmbodiment数据集)上训练,来学习VLA模型。例如,OpenVLA在MLLMs的基础上,通过在大规模机器人演示数据上进行后训练构建而成;而TraceVLA则进一步应用视觉轨迹提示来增强空间context理解。尽管这些方法在短时程技能上表现出潜力,但由于采用从视觉和文本输入直接到低层动作的端到端方式,它们在多样化视觉场景中进行推理以及实现长时程规划的关键能力仍然有限。

为了使VLA模型具备解决复杂具身任务的能力,近期研究探索将显式的思维链(CoT)提示作为中间步骤引导。例如,ECoT和RAD引入数据整理流程,通过提示现成的MLLMs生成中间步骤和分解后的planning。在获得带注释的CoT轨迹后,VLA模型通过全监督微调(SFT)训练来预测中间步骤。然而,由于生成高质量推理轨迹的成本高昂,由此产生的模型容易过拟合到特定的视觉场景或推理模式。

最近,强化学习(RL)已显示出巨大潜力,通过探索能最大化奖励信号的思维轨迹,而非仅仅依赖全监督的CoT注释,来激励LLMs的推理行为。受这一范式的启发,一些视觉-语言模型将基于RL的推理应用于多模态任务。例如,Video-R1采用R1风格的RL优化,通过可验证的答案准确性和格式正确性来诱导CoT轨迹。虽然这种方式能够在没有步骤级监督的情况下实现长文本推理,但对问答式奖励信号的依赖限制了它们支持长时程规划的能力,并且难以将推理与现实世界的动作执行联系起来。

ThinkAct旨在使MLLMs具备在物理环境中“先思考后行动”的能力。为了解决视觉-语言-动作推理任务,ThinkAct采用双系统架构,将结构化推理与可执行动作连接起来。通过基于视觉目标完成度和轨迹分布匹配的动作对齐奖励来改进强化学习,从而激励MLLMs执行长时程规划。ThinkAct利用人类和机器人视频来激发以视觉观察为基础的具身推理。为了连接推理和执行,将中间推理步骤压缩为一个紧凑的潜在轨迹,该轨迹捕捉高层意图,并使下游动作网络能够有效地适应新环境。通过强化结构化推理并将其与现实世界动作相结合,ThinkAct能够处理长时程操作任务,同时在物理AI场景中实现少样本动作适应和ego修正行为,如图1所示。

ThinkAct方法一览

1)问题表述

首先定义视觉-语言-动作(VLA)推理任务的设置和符号。在每个时间step,模型接收视觉观察和文本指令,目标是预测动作,该动作可以是文本命令或7自由度控制向量(取决于具体的具身形式)。为了解决这个问题,提出ThinkAct,一个统一框架,旨在利用MLLM生成高层planning,同时连接动作模型以推断可执行动作。MLLM基于(观察,指令)生成视觉planning潜变量,捕捉高层意图和规划context。这个推理出的planning引导下游动作模块在目标环境中顺序预测N个可执行动作。通过将抽象规划与低层控制连接起来,ThinkAct能够实现长时程推理,并提高在动态具身任务中的动作适应性。

2)用于具身推理的强化视觉潜在规划

为了实现能在多样化环境中泛化的具身推理,这里旨在通过强化学习激励多模态LLMs的推理能力。一种直接的方法是让MLLM在生成低层动作之前进行推理,同时使用目标环境中的任务成功率作为奖励信号。然而,这种方法受限于特定的模拟器,无法从视觉场景中获得适当的指导。

基于动作对齐视觉反馈的奖励塑造

为了应对这一挑战,这里设计了一种新颖的动作对齐视觉反馈,它能捕捉长时程目标,并鼓励规划过程中的视觉关联。受近期研究的启发,我们能够将高层planning表示为时空轨迹,捕捉视觉场景中 gripper 末端执行器的运动,以此作为引导具身推理的视觉-动作指导。

如图2(a)所示,给定时间步t的观察和任务指令,MLLM自回归生成推理的潜嵌入序列和视觉planning,其中前者被解码为推理步骤,而后者则被推断为2D点的文本字符串,其中p₁和pₖ分别表示gripper的起始和结束位置。因此,为了鼓励模型预测视觉目标的完成情况,引入目标奖励,将预测的起始和结束位置与由现成检测器获得的轨迹中的对应点进行比较,如下所示:

为了进一步促使MLLM预测的轨迹与物理上合理的gripper运动相符,我们提出轨迹奖励,以规范预测轨迹与演示轨迹的分布匹配。因此,轨迹奖励计算如下:

这里,d(轨迹, 参考轨迹)表示衡量两个轨迹之间距离的度量,这里采用动态时间规整(DTW)距离。

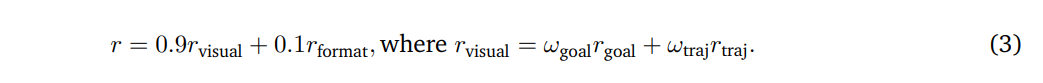

整体奖励定义为提出的动作对齐视觉反馈与格式正确性分数的组合,遵循现有推理研究:

用于引出视觉潜在规划的强化微调

为了激励MLLM的具身推理,使用group相对策略优化(GRPO)进行强化微调。给定输入(观察,指令),GRPO首先从原始MLLM中采样M个不同的响应。每个响应使用式3定义的奖励函数进行评估,得到一组奖励信号,通过最大化以下目标来优化MLLM:

这里,量化了第i个响应相对于采样组中其他候选响应的相对质量。(·||·)是KL散度,引入时带有权重因子β以规范模型,防止其与原始模型过度偏离。

为了进一步获取通用的具身知识,ThinkAct可以灵活地整合公开可用的问答数据,通过将其格式化为问答式准确性奖励,来增强机器人VQA或故障检测等能力。强化微调完成后,能够生成较长的CoT步骤,同时将文本推理抽象为紧凑的视觉planning潜变量,捕捉长时程的时空规划意图。

3)推理增强的动作适应

借助MLLM推理出的高层具身意图,目标是以“先思考后行动”的方式,将推断出的视觉潜在规划与目标环境的动作模型连接起来,将具身推理与物理世界中的可执行动作关联起来。我们基于一个基于Transformer的动作模型(例如Diffusion Policy)构建,该模型基于由视觉观察和语言指令组成的当前状态预测动作。虽然仅通过感知,动作模型就可以在目标环境中运行,但我们通过将其以潜planning为条件,增强其能力,该潜planning编码了高层具身意图和规划上下文。

如图2(b)所示,使用潜投射器整合视觉planning潜变量,将其连接到动作模型的输入空间,使推理指导能够被有效利用,从而增强其在目标环境中的低层动作执行能力。因此,仅通过带注释的动作演示,以模仿学习的方式更新状态编码器、潜投射器和动作模型:

需要注意的是,推理和动作执行可以异步运行,这意味着每个潜planning对应与环境的N次交互(即i ∈ [t, t+N])。这种异步设计凸显了我们双系统架构的一个关键优势,允许推理MLLM进行“慢思考”,而动作模型执行“快控制”。

4)学习策略和推理

遵循相关研究,为ThinkAct采用多阶段训练策略。在RL之前,独立初始化两个模块。MLLM使用监督数据进行冷启动,学习解读视觉轨迹并以正确的输出格式生成推理和答案。另一方面,动作模型在Open X-Embodiment(OXE)数据集上预训练,为低层动作执行提供坚实基础。冷启动SFT之后,我们的MLLM通过动作对齐奖励进行调优,引导生成有效的潜planning。在推理增强的动作适应阶段,冻结MLLM,同时在目标环境上通过以视觉planning潜变量为条件,更新动作模型(包含状态编码器和潜投射器)。

在推理时,给定视觉观察和指令,ThinkAct生成视觉planning潜变量,该潜变量以动作模块为条件,预测一系列适合当前环境的可执行动作。

实验分析

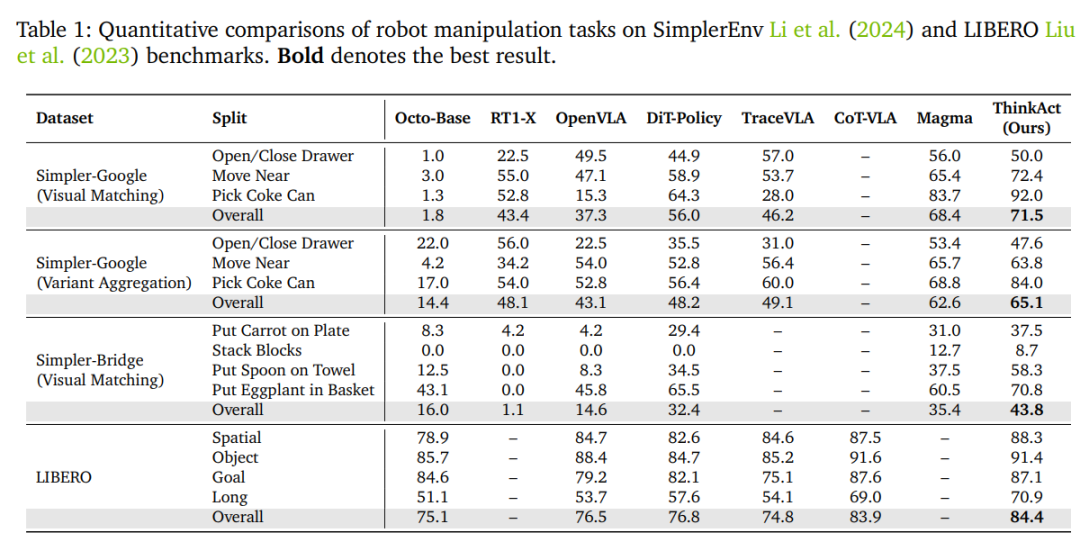

1)机器人操作

为评估ThinkAct在机器人操作任务上的有效性,在SimplerEnv和LIBERO上开展评估。SimplerEnv包含Google-VM(视觉匹配)、Google-VA和Bridge-VM三种设置,通过在颜色、材质、光照和相机姿态等方面引入变化,来评估模型的稳健性。对于LIBERO基准,参照以往研究,在LIBERO-Spatial、LIBERO-Object、LIBERO-Goal和LIBERO-Long子任务上进行评估,以测试模型在空间布局、物体变化、目标多样性和长时程规划方面的泛化能力。

如表格1所示,在SimplerEnv上,借助推理引导的视觉planning潜变量,ThinkAct在Google-VM、Google-VA和Bridge-VM上的表现分别比基准动作模型DiT-Policy高出15.5%、16.9%和11.4%,在所有方法中取得了71.5%、65.1%和43.8%的最高总体得分。在LIBERO基准上,ThinkAct以84.4%的总体成功率位居榜首,优于DiT-Policy和近期的最先进模型CoT-VLA,这验证了其在多种机器人操作场景中的有效性。

2)具身推理

在表格2中,在EgoPlan-Bench2、RoboVQA和OpenEQA三个基准上评估了ThinkAct在具身场景中的推理能力。EgoPlan-Bench2用于衡量以ego为中心的日常生活场景中的多步骤规划能力,RoboVQA则专注于机器人操作中的长时程推理。ThinkAct在这两个基准上分别以2.5%的优势和4.1的BLEU分数超过了次优方法,展现出在长时程和多步骤规划方面的优势。此外,OpenEQA用于衡量在多种环境中的零样本具身理解能力。ThinkAct增强的推理能力使其能够更好地泛化和理解场景,因此在该基准上也表现出色。

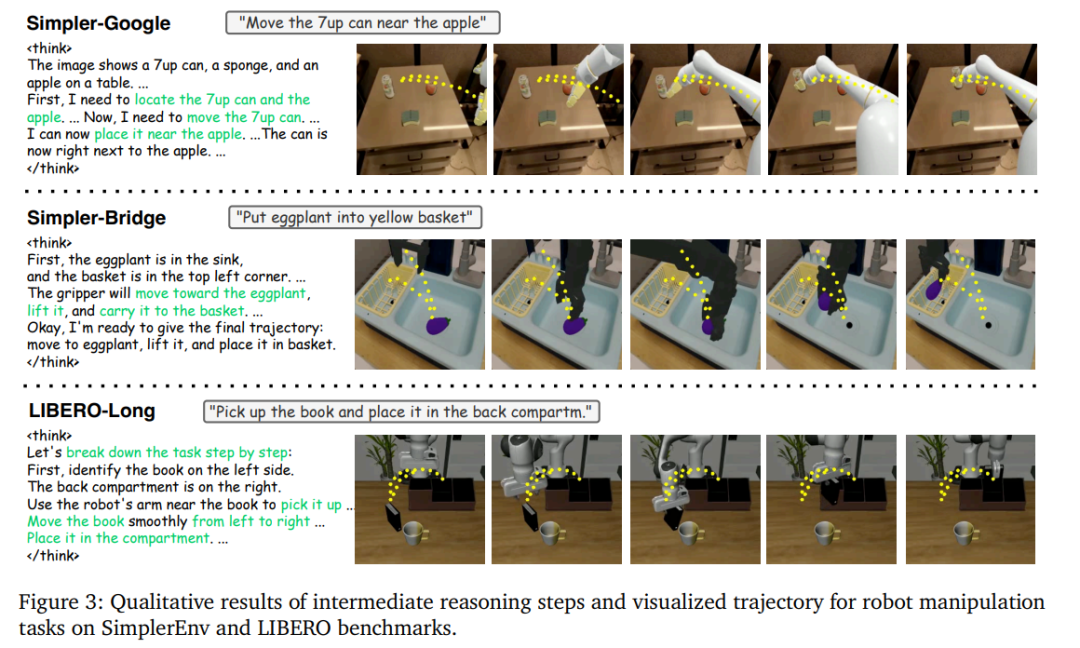

3)定性结果

图3定性展示了来自Simpler-Bridge和LIBERO-Long任务的两个操作示例的推理过程和执行场景。在LIBERO-Long任务“拿起书并将其放入后部隔间”中,ThinkAct将指令分解为子任务:(1)拿起书;(2)从左向右移动;(3)将书放入隔间,这体现了其长时程规划能力。还对规划的轨迹进行了可视化,证实了gripper在执行过程中紧密遵循推理引导的planning。

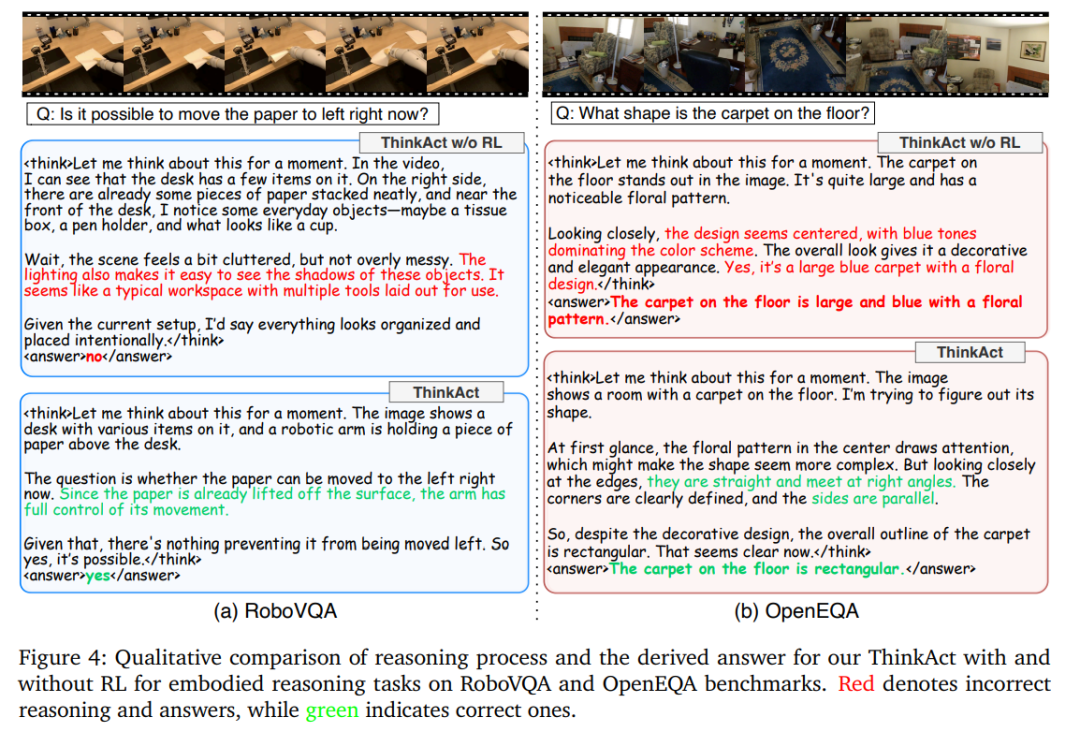

为了更直观地展示RL对推理过程的影响,图4对比了ThinkAct在RL微调前后在具身推理任务上的表现。从图4(a)中RoboVQA的示例可以看出,SFT冷启动模型仅关注当前状态,无法对未来步骤进行推理,而经过RL调优的模型成功推断出了正确答案。此外,从图4(b)中OpenEQA的示例可知,冷启动模型对问题存在误解,而经过RL调优的模型在问题和环境理解方面有了提升。更多定性对比和演示视频可在补充材料中查看。

4)消融研究

在表格3中,对所提出的目标奖励和轨迹奖励进行了消融实验,以分析它们对推理和规划的单独贡献。从ThinkAct的完整版本开始,该版本在所有基准上均取得了最佳性能。移除轨迹奖励会导致性能明显下降,这表明对于学习连贯且结构化的规划行为至关重要。没有目标奖励时,性能也会下降,这说明在激励长时程推理方面发挥着关键作用。当同时移除和,仅保留来自问答数据集的问答式奖励时,模型相较于SFT基准仅表现出微小提升,这证实了动作对齐的视觉反馈对于在具身场景中实现有效的多步骤规划至关重要。最后,未经过RL的SFT冷启动模型得分最低,这验证了我们的RL微调在激发MLLMs推理能力方面的有效性。

5)ThinkAct的分析

这里分析了ThinkAct通过具身推理增强机器人操作的能力。重点关注两个关键方面:(1)推理如何促进对新任务和新环境的有效少样本适应;(2)推理如何使机器人能够检测故障并在任务执行过程中进行ego修正。通过定量实验和定性示例,我们展示了利用推理MLLM解决具身动作任务的独特优势。

推理增强少样本适应

从图3和图4中可以看出,ThinkAct能够描述环境并将任务指令分解为有意义的子目标。为验证这种推理是否能提高动作模型的适应性,在LIBERO基准上进行了少样本适应实验。使用LIBERO-Spatial和LIBERO-Object评估对未见过环境的适应能力,使用LIBERO-Goal测试对新技能的适应能力。在每个任务上仅使用10个演示样本对动作模型进行微调,并在100次试验中评估性能。如图5所示,ThinkAct在所有任务上的成功率均高于最先进的方法。值得注意的是,它在LIBERO-Goal上比Magma高出7.3%,在LIBERO-Spatial上高出9.5%,这证明了推理能力在新技能和新环境的少样本泛化方面的有效性。

推理引发ego修正

故障检测和ego修正是稳健机器人操作的关键。为评估ThinkAct是否能够对执行错误进行推理并从中恢复,让推理MLLM在执行过程中观察更多的context信息,将其输入从单张图像扩展到短视频片段。这种时间context使ThinkAct能够检测故障、重新考虑情况并相应地重新规划。例如,如图6所示,在一项要求机器人将盒子放入篮子的任务中,gripper在中途意外掉落了盒子。推理MLLM识别出该故障,称“让我们重新考虑如何完成这项任务”,并生成了一个修正planning,引导gripper回到掉落位置重新抓取盒子。随后,机器人成功完成了任务,这体现了ThinkAct通过结构化推理反思错误并进行ego修正的能力。

参考

[1] ThinkAct: Vision-Language-Action Reasoning via Reinforced Visual Latent Planning.

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊