VLA模型十大技巧

xbot福利来袭!转发本文到朋友圈,私信木木备注 “获取VLA模型资料”;或在文章评论区留言 “获取VLA模型资料”,即可下载原文!1Token Shuffling(视觉 Token 打散)• 背景:一张图像经过视觉Transformer(如ViT)编码后,会被分割成大量 patch token(如14×14共196个token),多帧图像则产生成百上千个token,导致计算成本飙...

2025-07-17 17:32:07

全网最全英伟达Orin芯片解读

xbot福利来袭!转发本文到朋友圈,私信木木备注 “获取Orin资料”;或在文章评论区留言 “获取Orin资料”,即可下载原文!英伟达 Orin 系列芯片,机器人产品经理必懂的技术指南如果你是一名智能硬件或机器人的产品经理,大概率在开会时听过这样的对话:“这款机器人用 Orin Nano 够吗?”“客户要 4K 多摄像头联动,得上 Orin AGX...

2025-07-16 17:32:30

机器人 VLA (π0) vs 自动驾驶 VLA (MindVLA) 技术差异比较

xbot福利来袭!转发本文到朋友圈后截图私信木木备注 “获取VLA资料”;或在文章评论区留言 “获取VLA资料”,即可下载原文!本文将从 七个技术维度 系统性比较由 Physical Intelligence 推出的机器人 VLA 模型 π0与理想汽车自动驾驶 VLA 模型 MindVLA 之间的异同。从架构设计、感知输入、行为生成、训练数据、实时性、应用场景...

2025-07-15 17:31:44

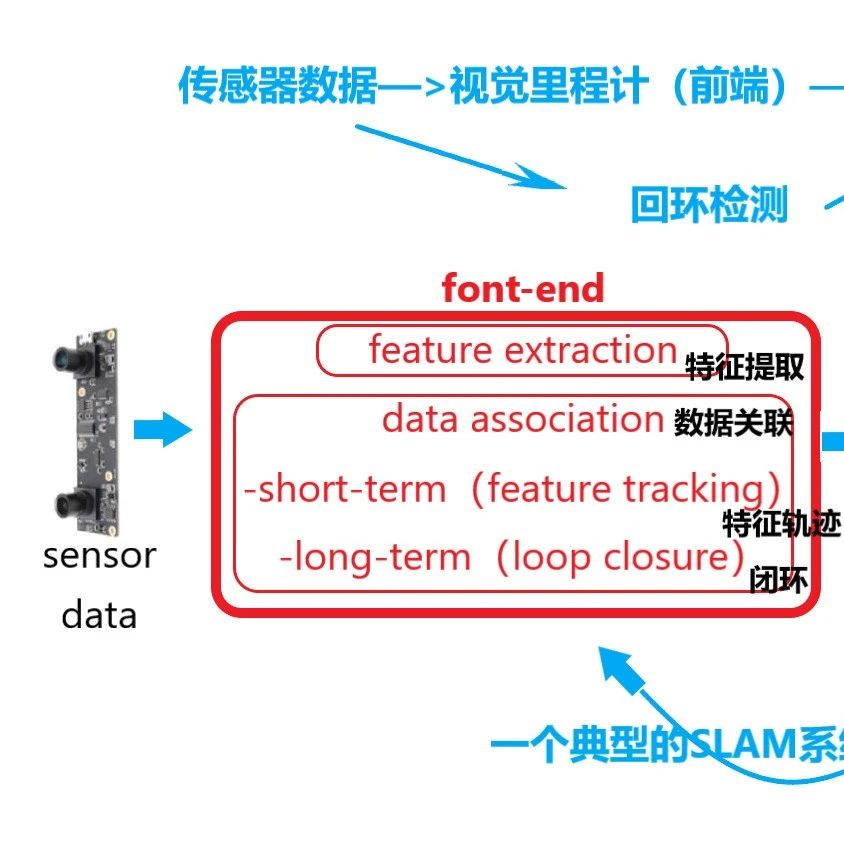

机器人定位与导航学习路线图

xbot福利来袭!转发本文到朋友圈后截图私信木木备注 “获取定位导航资料”;或在文章评论区留言 “获取定位导航资料”,即可下载原文!总目标:掌握SLAM与路径规划的核心原理与工程实现,具备搭建自主导航系统的能力。01SLAM 学习路线(Simultaneous Localization and Mapping)阶段一:SLAM理论基础(1–2个月)学习目标:理解S...

2025-07-14 17:31:31

训一条自己的四足狗吧,Xdog实训一期招募了

整体安排机械狗实训课程版本说明推荐选择建议团队介绍与分工课表安排部分效果

2025-07-10 17:30:00

世界模型技术是否真的能够应用于具身智能领域

技术路线现代世界模型(World Model)的构建主要沿着多条技术路线发展,包括基于Transformer的自回归模型、基于扩散模型的生成模型、NeRF/3D生成模型以及与强化学习结合的方法等。各路线在时序一致性(跨时间的连贯性)、空间一致性(多视角/三维一致性)和物理一致性(遵循物理规律的合理性)方面各有优劣:• Transformer...

2025-07-09 17:52:42

大语言模型人机交互路线(LLM-based)

阶段一:大语言模型基础(1–2个月)01核心目标理解大语言模型的基本架构与工作原理,掌握Prompt设计方法,并能调用API构建基础对话系统。02关键知识点1. Transformer架构组件结构:Self-Attention、Multi-head Attention、Position Embedding编码-解码 vs 纯解码(GPT 系列采用Decoder-only架构)2. 自回归生成机制(Autore...

2025-07-08 17:31:48

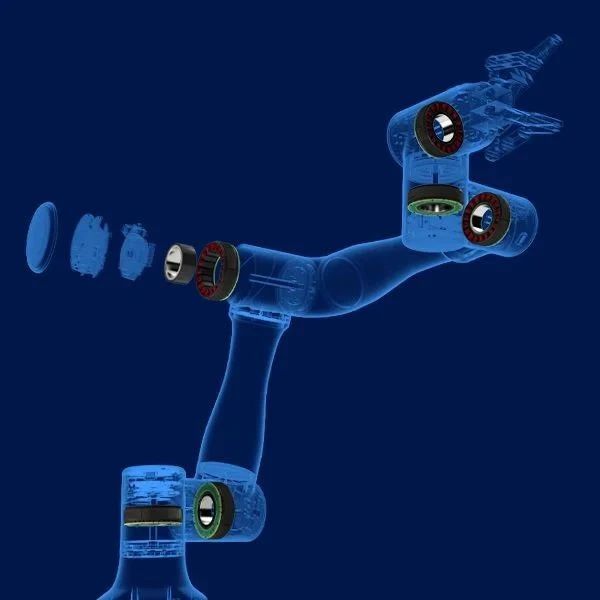

一文了解机器人关节中的力矩电机

力矩电机作为具身智能机器人的 "关节灵魂",正推动机器人运动控制从 "机械执行" 向 "力觉感知" 跨越。本文将系统拆解力矩电机的技术基因、核心优势、关键参数及行业应用,揭示其如何重塑机器人的运动生态。一、力矩电机的技术原点与本质定义1.1 从 "动力源" 到 "力控中枢" 的进化当先进机器人完成高难度动作时,其关节电机...

2025-07-07 17:33:20

智元Genie sim手把手教学

本周日由Vege带来智元Genie sim手把手教学,Genie Sim 是 智元机器人(AgibotTech) 开发的一款 高保真机器人仿真评测平台,专注于为 具身智能(Embodied AI) 提供精准的仿真测试环境,帮助开发者优化机器人算法并减少对物理硬件的依赖。

2025-07-06 12:00:00

全国范围内推具身智能优质岗位

本周推荐NEWS公司介绍北京字节跳动科技有限公司,成立于2012年3月,是最早将人工智能应用于移动互联网场景的科技企业之一,是中国北京的一家信息科技公司。公司以建设“全球创作与交流平台”为愿景。字节跳动的全球化布局始于2015年,“技术出海”是字节跳动全球化发展的核心战略,其旗下产品有今日头条、西瓜视频、抖音、...

2025-07-04 17:36:43