谁说树莓派5跑不了大模型?保姆级部署指南

- 2025-07-30 17:30:00

转自 | 达尔闻说

如果在树莓派5上部署大模型,效果会怎么样呢?

项目介绍

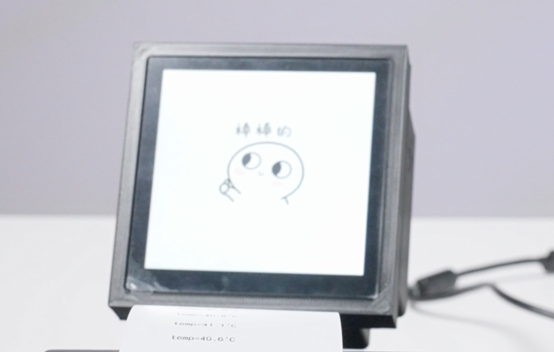

这个项目实现的功能是这样的:

树莓派通过语音识别成文本,并提交给大语言模型的API接口。大语言模型返回的内容,通过屏幕和热敏打印机同时展现出来。

由于热敏打印机打印中文不太方便,通过大语言模型的英文翻译的能力,将我们的语言翻译成英文打印出来。

这样就可以适配到很多的应用场景,比如实时在线翻译问路。

树莓派5可以部署大模型吗?

本次项目使用的是8GB内存的树莓派5。从硬件性能上来看,树莓派搭载了64位的四核Arm Cortex-A76的处理器运行频率能够达到2.4GHz,配备了800MHz的VideoCore VII代的GPU,内存也使用了LPDDR4的SDRAM2的颗粒。

这样的配置虽然也是一台口袋大小的电脑,但相比Jetson Orin Nano和Lattepanda sigma来说,还是有一些差距的,尤其是在处理大模型时,对CPU核心数量 CPU的负载,包括频率、内存带宽等方面都有较高的要求。

一般来说,我们选择大模型时,会优先考虑支持CPU运行且内存占用比较小的模型。树莓派5是可以部署一些经过量化或本身参数量较小。

对硬件要求相对较低的大语言模型,这样的大语言模型还是有不少的:

1)Qwen-1.8B、Qwen-4B等版本,模型参数相对较少,最低内存需求一般建议在4GB左右,8GB的树莓派5正好可以匹配这样的应用。

像树莓派5这类算力资源有限的设备上部署大模型,选择一些低于4B的模型,可以提高响应的速度,增加用户的体验。主要的一些应用方向为一些简单的智能语音聊天项目、图像识别的项目,还包括一些人机交互的项目。

2)微软推出的Phi-3-3.8B的大语言模型,也可以在树莓派上成功地运行,使用的是Ollama运行的框架,并且能够获得不错的token速度。

3)Llama-3-8B模型也可以跑,只是可能稍微慢一点,通过安装Ollama,可在树莓派5上一键启用对话,并且可以支持32K或128K上下文,输出能够达到12K token/s左右。

4)谷歌的Gemma 3的模型,今年刚推出的大模型支持几十种语言的开箱即用,有很多种多模态,能分析图像、文本和短视频等等,在树莓派上部署1B、4B都是非常地适合的。

本次项目在树莓派上,就部署了Gemma 3.2 1B的模型,速度很快,能够完成项目需求。

项目实现过程

curl -fsSL https://ollama.com/install.sh| shollama pull xxx(模型的名字)ollama list

ollama run llama3.2:1b --verboseollama run gemma3:4b –verbose

Sudo systemctl status ollama.service

netstat -natp

单片机常用状态机QP框架的原理

程序员编程最难过的几个阶段!

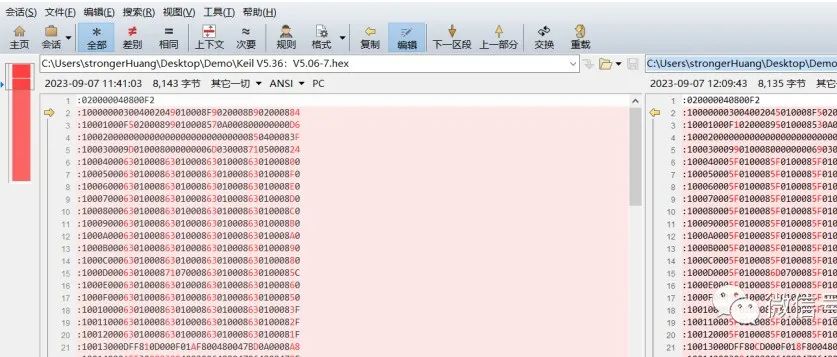

同样的单片机代码,编译后的hex为啥会变?

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊