Jim Keller谈为何选择RISC-V,披露开放芯粒架构细节

- 2025-07-26 09:10:00

7月17日,第五届RISC-V中国峰会在上海张江科学会堂盛大开幕。本次峰会作为全球开源技术领域的重要盛会,吸引了近2000名专业观众线下参与,线上直播覆盖超过50万人次。

Tenstorrent首席执行官Jim Keller与首席架构师练维汉(Wei-Han Lien)在峰会上发表了题为《融算于开,慧启未来》的演讲,系统阐述公司基于RISC-V架构的开放计算战略,并正式推出颠覆性开放式芯粒架构(OCA, Open Chiplet Architecture),为与会者带来了一场关于RISC-V架构与人工智能(AI)深度融合的精彩分享。

Tenstorrent首席执行官Jim Keller

为何选择RISC-V?

Tenstorrent选择RISC-V架构的核心原因在于其卓越的“开放性”与“灵活性”。Jim Keller在演讲中强调,“RISC-V的模块化与可扩展性使其成为AI时代打破架构垄断的关键。”

作为一种全球最开放的CPU架构,RISC-V允许开发者在任何时间、任何地点以自定义方式搭建解决方案。这种开放性让RISC-V不仅是指令集,更是解决问题的工具,吸引了全球众多学者、专家及初创企业以更低成本参与创新,还推动了架构的持续演进。

数据显示,2025年全球RISC-V芯片出货量已突破100亿颗,中国在物联网与边缘计算领域实现90%以上自主设计能力,采用RISC-V的新品研发周期较传统架构缩短40%,成本降低25%。

Jim Keller坚信,在接下来的五年中,RISC-V将迎来比过去十年更多的变化和发展,成为技术创新的关键驱动力。

Tenstorrent在资源支持方面表现出色,构建了丰富的测试架构配置,并搭建了专门的RISC-V架构站,为开发者提供实践平台。在人工智能领域,Tenstorrent积极拥抱开源语言与模型生态,开发了Pytorch编译器及高性能处理代码等工具,助力开发者在AI领域大展身手。

开放芯粒架构(OCA),应对AI算力需求

练维汉在演讲中详细介绍了Tenstorrent的开放式芯粒架构(OCA)。

Tenstorrent首席架构师练维汉(Wei-Han Lien)

据行业报告显示,到2028年,60%-80%的高性能AI系统将基于芯粒架构。经过两年半的研发,Tenstorrent计划于今年底发布OCA,与业界分享其技术成果。OCA的独特之处在于其完全开放,从芯片设计到软件栈均不含任何收费组件,涵盖物理层、传输层、协议层、系统层和软件层等多个抽象层,结构清晰,易于理解。

OCA的优势在于允许公司和研究机构专注于核心竞争力设计,突破传统芯粒架构的封闭性,无需担忧与其他芯粒的兼容性问题。

例如,在汽车系统中,厂商可以轻松集成具有竞争力的芯粒,优化产品性能,同时满足从L1到L4等不同级别自动驾驶系统的算力需求。此外在机器人、高性能计算(HPC)等领域,这种灵活性不仅提升了算力,还降低了成本,使AI技术更具普适性。

据悉,OCA开源标准计划于2025年底发布,已集成于2026年新一代芯粒产品,推动芯粒生态的规模化发展。

打造全球领先AI芯片,关键在于CPU

Tenstorrent在CPU开发上展现出雄心勃勃的计划。

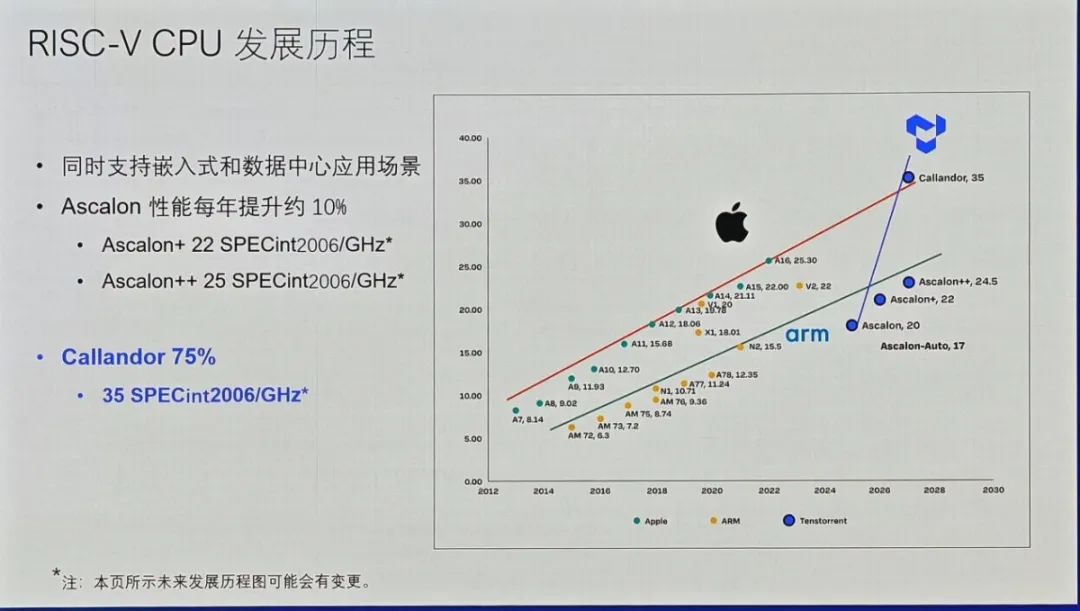

其Athena芯粒拥有8核Ascalon CPU集群,支持物理层到软件层的五层抽象架构,实现多源芯粒即插即用。Ascalon系列处理器预计未来几年性能每年提升约10%,目标是在2027年成为全球最快的CPU。预计同年推出的Callandor处理器(35 SPECint2006/GHz)将具备卓越的编译能力和高效运算性能。

练维汉指出,硬件与优质软件生态的结合是普及化的关键,Tenstorrent通过开源硬件、软件和知识产权,致力于降低设计成本,鼓励多样化架构,开发更亲民的AI产品。

Tenstorrent正积极探索AI在芯片开发中的应用。AI不仅可用于编程、编码、监测、测试和认证,还能加速RTL(寄存器传输级)设计及硬件开发。这种深度融合将重新定义软硬件开发模式,为解决复杂问题提供更高效的工具。

Jim Keller强调,RISC-V不仅是一个软件抓手,更是一个优秀的架构指令集,能够在问题尚未成熟时就提供解决方案。

开放生态,推动AI民主化与普及化

Tenstorrent提出的“AI民主化”战略贯穿整个演讲,其开源策略直接对标英伟达的封闭生态,致力于打造最优化、最亲民的AI架构。

练维汉指出,AI芯片设计成本高昂,通常高达10亿至20亿美元,涵盖硬件、软件、开发系统和主板等多个领域。通过开源,Tenstorrent希望降低这些壁垒,促进广泛参与。其基于RISC-V架构的CPU、即将开源的AI技术以及开源软件系统,均体现了对开放生态的承诺。

据介绍,Tenstorrent的Wormhole系列边缘计算芯片(262 TFLOPS FP8算力)与BlackHole数据中心加速器(745 TFLOPS FP8算力)通过SRAM替代HBM方案,将成本压缩至同类产品的50%-70%。软件层面,TT-NN编译器在MLPerf测试中实现较A100高40%的推理效率,vLLM加速支持使LLaMA-3 70B模型处理速度达120 token/s。

Tenstorrent希望通过开放的方式,刺激合作,降低设计成本,催生更多架构,推出更好、更亲民的AI产品。公司包括TT Forge编译器(基于MLIR框架)、PyTorch生态兼容工具链在内所有的软件开发系统、硬件和IP均采用开放方式,以促进合作、降低成本并推动AI产品的普及化。

练维汉呼吁业界共同参与开发开放的生态系统,设计更多芯片,让AI更加亲民,降低硬件成本。

行业分析机构Tirias Research预测,到2027年,Tenstorrent有望在边缘AI市场占据15%份额。公司当前估值26亿美元,投资者包括贝索斯探险基金、三星等战略资本,其日本半导体振兴计划合作更凸显地缘技术支点价值。

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊