超全面讲透一个算法模型,高斯核!!

- 2025-07-31 15:16:00

哈喽,大家好~

今儿和大家把「高斯核」相关的内容和大家聊聊~

在讲「高斯核」之前,我们先想象一个最简单的场景:你家门口有好多路人,小白同学要判断“离我家门口最近的几个人”对我有多大影响。直觉上,离我家门口越近的人,对我影响越大;离得越远,影响就越小。这个“影响程度”怎么量化呢?高斯核就是一种“先给出一个漂亮的钟形”,按距离远近给权重(影响力)。

高斯核是什么?

1. 数学公式

这里 和 可以是两个数、两个向量、两个像素……

(读作“西格玛”)决定“钟”有多宽:

小,钟形尖锐(很挑“近人”) 大,钟形平缓(也让“远人”稍微有点影响)

2. 钟形曲线

当 (两个点重合),,所以指数里面是 0,。也就是“自己对自己的影响”给 1(最高)。 距离越大,指数变成负数越大, 结果趋近于 0,影响就几乎没有了。 画出来就是经典的“钟形”──中心最高,向两边逐渐下降。

为什么要用高斯核?

平滑/模糊:在图像处理中,用高斯核可以做到“高斯模糊”,把一张照片细节平滑掉,噪点变少。

加权平均:在点云或时间序列里,想让“附近点”比“远处点”更重要,就用高斯核加权平均。

核方法:在机器学习(如支持向量机 SVM)里,高斯核能把原来线性不可分的数据“映射”到一个无限维空间,让你只用内积就能做出强大的分类器。

两个案例

例 1:温度测量平滑

假设小白同学在街上架了十个温度传感器,每个都可能有点误差。

他想得到“某时刻我们这条街的温度趋势”,不想被某个坏掉的传感器拉偏。

做法:把每个传感器温度 按它到街中心的距离 用高斯核加权:

距离街中心近的传感器给大权重,远的给小权重。

这样算出来的 就更平滑、更靠谱。

例 2:图像高斯模糊

小明拍了一张照片,想让背景虚化一点突出前景。

把照片看成一个像素网格:每个像素的新亮度是“周围像素亮度的高斯加权平均”。

距离中心像素近的像素权重高;距离远的权重低,几乎没贡献。

结果就是旁边一点点的像素影响大,远处的细节渐渐模糊掉了。

调整 σ 的效果

σ 很小:只有非常近的点才会有明显权重,像一把“尖锐的小伞”只罩住中心。在图像里就是极度“局部”的模糊,边缘保留更多细节。

σ 很大:很多点都有差不多的权重,像一把“巨大的伞”罩住很广区域。在图像里就是大范围“强模糊”,细节都被揉得差不多了。

总的来说,高斯核 = 一个随着距离呈钟形衰减的“权重函数”

公式:,从图像模糊到平滑数据,再到机器学习的非线性映射,都能看到它的身影。

核心原理&案例

高斯核(Gaussian kernel)是核方法中常用的核函数,属于径向基函数(RBF)的一种,定义如下:

其中:

是两个输入向量; 是欧几里得距离的平方; 是高斯分布的标准差; 表示两个点之间的相似度。

推导过程(从高斯分布到高斯核)

1:从一维高斯分布开始

高斯分布(正态分布)的概率密度函数为:

去掉归一化项和均值项 ,得到:

2:推广到多维空间

对两个向量 ,考虑它们之间的距离平方:

带入高斯形式:

这就是我们常见的 高斯核函数。

完整案例

我们构造一个虚拟二分类数据集,并使用高斯核对其进行特征映射 + 分析 + 可视化。

包括:

创建非线性可分的数据; 用高斯核计算相似度矩阵; 使用 PCA 降维可视化; 用 SVM + RBF 核分类; 数据分析可视化

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_circles

from sklearn.svm import SVC

from sklearn.decomposition import PCA

from sklearn.metrics.pairwise import rbf_kernel

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report, confusion_matrix

# 1. 非线性数据

X, y = make_circles(n_samples=1000, noise=0.1, factor=0.4, random_state=42)

colors = np.array(['#E74C3C', '#3498DB']) # 红/蓝

# 2. 可视化原始数据

plt.figure(figsize=(6,5))

plt.title("原始非线性分布数据", fontsize=14)

plt.scatter(X[:,0], X[:,1], c=colors[y], edgecolor='k', s=50)

plt.xlabel("X1")

plt.ylabel("X2")

plt.grid(True)

plt.show()

# 3. 计算高斯核相似度矩阵

sigma = 0.3

K = rbf_kernel(X, X, gamma=1/(2*sigma**2))

# 4. 可视化相似度矩阵(热图)

plt.figure(figsize=(6,5))

plt.title("高斯核相似度矩阵热图", fontsize=14)

plt.imshow(K, cmap='viridis')

plt.colorbar(label='相似度')

plt.xlabel("样本")

plt.ylabel("样本")

plt.show()

# 5. PCA 对高维相似度空间进行降维(展示映射后特征)

pca = PCA(n_components=2)

X_pca = pca.fit_transform(K)

plt.figure(figsize=(6,5))

plt.title("PCA降维后的核特征空间", fontsize=14)

plt.scatter(X_pca[:,0], X_pca[:,1], c=colors[y], edgecolor='k', s=50)

plt.xlabel("主成分1")

plt.ylabel("主成分2")

plt.grid(True)

plt.show()

# 6. 使用 SVM + RBF 核进行分类

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = SVC(kernel='rbf', gamma=1/(2*sigma**2), C=1)

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

# 7. 分类边界可视化

xx, yy = np.meshgrid(np.linspace(-1.5, 1.5, 500), np.linspace(-1.5, 1.5, 500))

grid = np.c_[xx.ravel(), yy.ravel()]

Z = model.predict(grid).reshape(xx.shape)

plt.figure(figsize=(6,5))

plt.title("SVM + 高斯核分类边界", fontsize=14)

plt.contourf(xx, yy, Z, cmap='coolwarm', alpha=0.6)

plt.scatter(X_test[:, 0], X_test[:, 1], c=colors[y_test], edgecolor='k', s=50)

plt.xlabel("X1")

plt.ylabel("X2")

plt.grid(True)

plt.show()

# 8. 性能指标输出

print("分类报告:")

print(classification_report(y_test, y_pred))

print("混淆矩阵:")

print(confusion_matrix(y_test, y_pred))

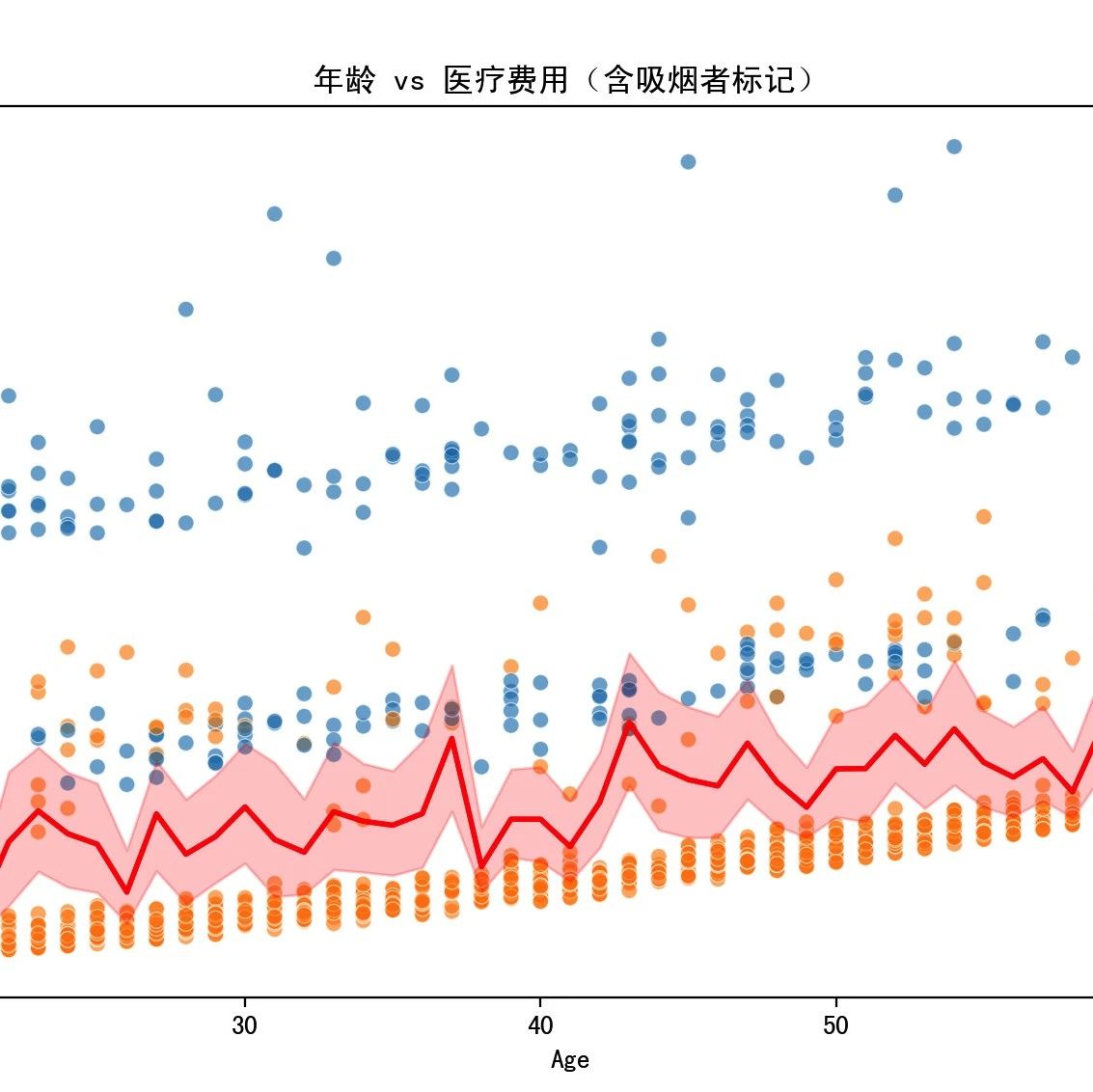

数据分析可视化:

1.原始非线性分布数据:展示问题的非线性本质

2.高斯核相似度热图:揭示哪些样本“相互接近”(相似度高)

3.PCA 降维的核空间图:可视化高斯核后的隐空间结构(本质变线性)

4.SVM 分类边界图:展示高斯核+SVM 是如何解决非线性分类问题的

整个内容,我们用高斯核把原本圈圈状、难分类的数据转化成能分的样子;然后用支持向量机(SVM)来画出清晰的分类边界;最后通过图形和准确率,验证这个方法真的能处理复杂、非线性的问题。

最后

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊