全景宇宙黑科技!HunyuanWorld 1.0 发布:一键生成360°可交互3D世界

- 2025-07-30 23:32:25

如您有工作需要分享,欢迎联系:aigc_to_future

作者:腾讯混元

解读:AI生成未来

报告链接:https://arxiv.org/pdf/2507.21809

Git 链接:https://github.com/Tencent-Hunyuan/HunyuanWorld-1.0

体验链接:https://3d.hunyuan.tencent.com/login?redirect_url=https%3A%2F%2F3d.hunyuan.tencent.com%2FsceneTo3D

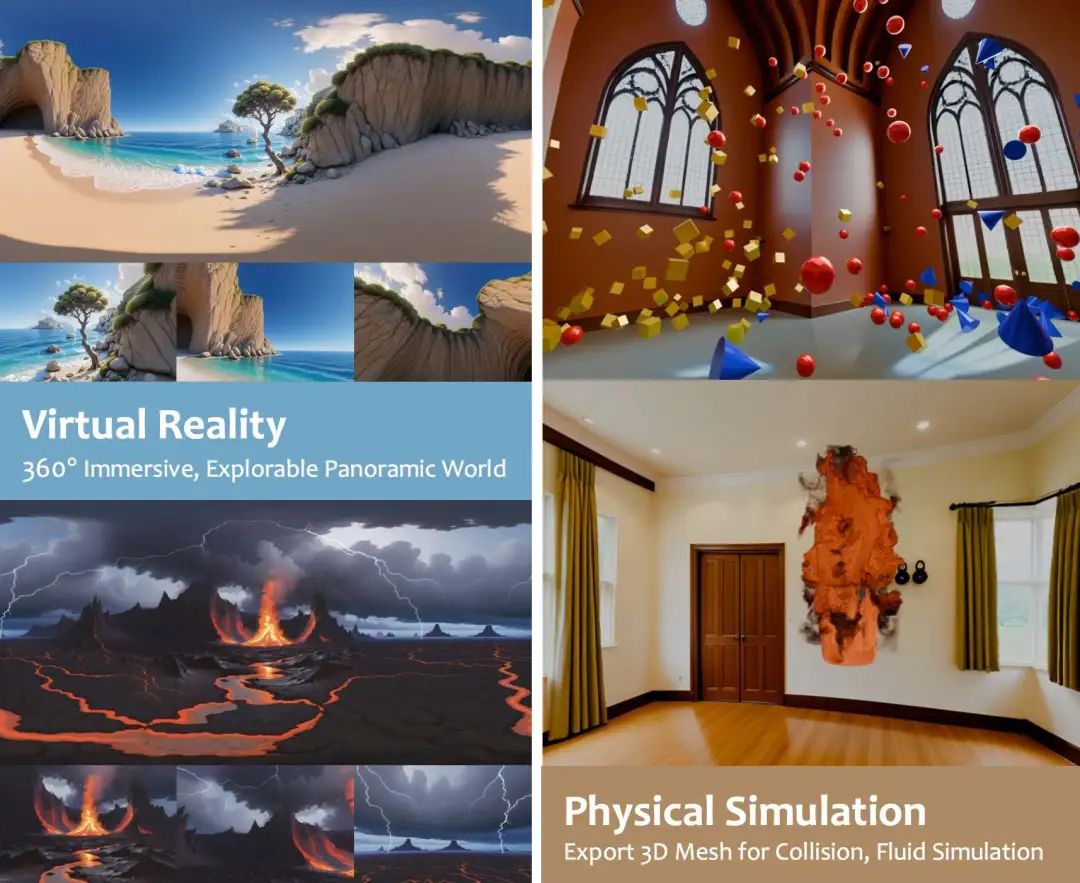

亮点直击

HunyuanWorld 1.0 ——一个融合2D与3D优势的全新世界生成框架,不再将2D与3D生成视为割裂的范式。核心是语义分层的3D网格表示,支持结构化的3D世界生成与实例级物体建模。 360°沉浸式体验:通过全景世界代理提供完整的360°场景覆盖; 网格导出能力:与现有图形学流程和工业标准工作流无缝兼容; 解耦的物体表示:支持场景中物体级别的交互操作。 全景世界图像生成,统一的世界代理,支持从文本到世界、图像到世界的生成任务; 支持用户在远超原始视角的广阔场景中进行自由探索。 支持丰富的应用场景,包括虚拟现实、游戏开发、物理仿真和物体交互等。

HunyuanWorld 1.0代表着向“人人都能构建、探索和操控自己的3D世界”这一愿景迈出的重要一步,真正架起了2D内容创作与沉浸式3D体验之间的桥梁。

总结速览

解决的问题

从文本或图像生成沉浸式、可交互3D世界的挑战:现有方法难以同时兼顾视觉多样性、3D一致性和交互性。 现有方法的局限性:

基于视频的方法:缺乏真实的3D一致性、渲染效率低、难以集成到图形学系统中; 基于3D的方法:受限于数据稀缺、表示方式低效,且缺乏对物体的解耦建模。

提出的方案

HunyuanWorld 1.0 ——一个融合2D与3D优势的世界生成框架,核心思想包括:

语义分层的3D网格表示:将世界表示为可结构化、可交互的多层语义网格; 全景世界代理:以360°全景图像作为统一世界表示,支持多模态输入(文本/图像); 逐层3D重建与物体解耦:对每一语义层进行独立的3D网格建模,实现物体级别的控制; 长距离世界探索机制:通过世界一致性的视频扩散模型和缓存机制,实现自由视角探索。

应用的技术

全景图像生成模型:用于构建完整的360°沉浸式世界代理; 语义分层机制:自动将复杂场景分解为语义层级(如建筑、家具、地面等); 逐层3D重建技术:结合深度估计与网格建模,生成对齐的3D结构; 世界一致性视频扩散模型:保障长时间/远距离探索中的空间一致性; 世界缓存机制:提升大场景交互中的效率与连贯性; 网格导出能力:生成结果可直接集成到游戏引擎、VR系统等工业流程中。

达到的效果

沉浸式体验:支持完整的360°场景覆盖,生成沉浸感强的3D世界; 可交互性增强:通过物体解耦与语义分层,支持物体级别的编辑与交互; 高兼容性与可拓展性:生成的网格表示与现有图形学/工业流程高度兼容; 多模态输入支持:可从文本或图像描述中快速生成丰富多样的3D世界; 性能领先:在可探索性、连贯性、渲染效率和交互性等方面超越现有方法; 广泛应用场景:适用于虚拟现实、游戏开发、物理仿真、交互式内容创作等领域。

技术细节

目标是实现支持图像和文本输入的 3D 世界生成,以适应多样化的用户需求。与 3D 物体相比,3D 世界具有更高的多样性 —— 包括室内和室外环境、不同风格,以及从单个房间到整个城市的各种尺度。然而,3D 场景数据稀缺且难以扩展,这使得 3D 世界生成具有挑战性。

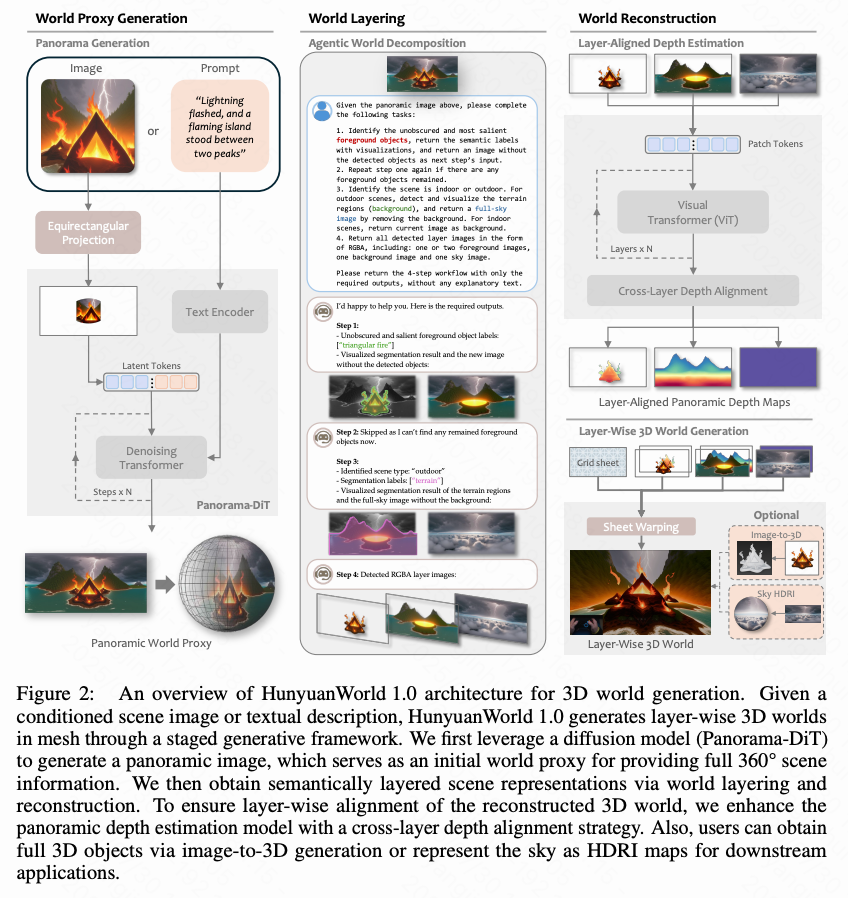

为了解决这个问题,本文提出将 2D 生成模型与 3D 生成相结合,利用全景图像作为世界的代理表示。如下图 2 所示,HunyuanWorld 1.0 是一个分阶段的生成框架,本文首先使用扩散模型生成一个全景图作为世界初始化,随后进行世界分层与重建。本文将在以下小节中详细介绍整个 3D 世界生成流程。

生成作为世界代理的全景图

全景图捕捉了场景的 360° 视觉信息,并可被格式化为等距矩形投影(ERP)图像,使其成为 3D 世界生成的理想代理。因此,本文从文本条件或图像条件生成一个全景图,作为 3D 世界生成的代理。

文本条件

对于文本到全景图的生成,输入是用户提供的句子。这里面临一个关键挑战:用户的自然语言输入通常与模型训练时使用的描述风格差异很大。为弥合这一差距,本文使用大语言模型(LLM)对中文提示词进行翻译,并增强其细节。这一转换确保提示词与生成模型的训练数据分布对齐,从而促进高质量全景图的生成。

图像条件

对于用户提供的小孔径图像,本文的目标是生成缺失部分的连贯内容,以获得完整的 360° 全景图,同时保留输入图像的内容。为此,本文通过等距矩形投影(ERP)将输入图像反投影到全景空间,所需的相机内参由预训练的 3D 重建模型(如 MOGE 或 UniK3D)估计。

全景图生成

本文的全景图生成模型(Panorama-DiT)的架构基于 Diffusion Transformer(DiT)框架。对于文本到全景图的生成,仅将增强后的文本提示词作为条件输入到扩散模型中。对于图像到全景图的生成,本文首先将输入图像投影到全景空间,然后使用变分自编码器(VAE)将其编码到潜在空间。接着,本文将条件图像与带噪潜变量拼接后输入扩散模型。为了提升生成质量并提供额外控制,图像到全景图的生成过程还会结合后文中提出的场景感知提示生成方法所生成的辅助文本描述作为条件。

与一般图像生成相比,全景图生成面临独特挑战:

球面投影带来的几何畸变; 由于全景拼接造成的不连续边界。

为了解决这些问题,本文引入了两个关键的边界伪影缓解策略:

高度感知增强。在训练过程中,本文以概率 和位移比例 随机垂直偏移真实标签全景图,以增强对视角变化的鲁棒性; 环形去噪。在推理过程中,本文在去噪过程中采用带有渐进混合的环形填充,以保持全景边界的结构和语义连续性。

全景数据构建流程

数据构建

本文的训练数据构建流程如下图 3 所示。全景图像来源于商业采集、开源数据下载以及通过虚幻引擎(UE)自定义渲染。每张全景图都经过自动质量评估流程,包括水印检测、美学评分、清晰度、分辨率和畸变等指标。不满足预设质量基线的图像将被丢弃。本文还邀请专业标注员对剩余样本进行人工筛选,过滤掉以下伪影样本:

几何伪影(如明显畸变、可见边界缝隙); 场景不规则(如狭窄或不具代表性的空间); 内容不一致(如异常的物体重复、异常的人体与物体)。

训练描述

现有的视觉语言模型(VLM)在为全景图生成描述时面临挑战,因为全景图包含比一般透视图更丰富的视觉细节。它们要么生成过于简化的描述,无法捕捉足够的场景细节,要么生成重复的文本并带有幻觉内容。为缓解这些问题,本文提出一个三阶段描述生成流程:

首先,本文利用再描述技术生成具有丰富细节的规范化全景描述; 然后,本文使用大语言模型(LLM)将这些描述提炼为不同长度的描述集合,涵盖从高层次场景摘要到细粒度物体注释; 最后,本文邀请专业标注员验证生成的描述,以消除图文不一致,确保语义准确性并最小化幻觉。

图像条件下的场景感知提示词

如前文所述,在图像到全景图的生成中,本文使用图像和文本双重条件。一个直接的方法是使用视觉语言模型(VLM)为输入图像生成描述。然而,用户提供的图像通常包含显著物体(如雕像),如果将图像描述作为提示词输入,可能会导致这些元素在生成的全景图中被重复(例如出现多个相同雕像)。

为了解决这一问题,本文引入场景感知提示生成策略。本文首先指示 VLM 识别输入图像中的显著物体,并将其作为负面提示词,以防止模型重复生成已有物体。接着,本文指示 VLM 想象一个超越输入图像视角的完整 360° 场景。最后,本文指示 VLM 生成一个精炼且完整的提示词,按从前景到背景、从艺术风格到环境氛围的层次结构描述该场景。

Agentic World Layering**

尽管全景图可以有效地作为世界代理,但它们本质上缺乏遮挡区域的信息,仅支持视角旋转,而不支持自由探索(例如视点平移)。受到人类建模实践的启发 —— 艺术家通常将 3D 世界场景建模为天空(天空盒或穹顶)、地形网格和多个物体资产 —— 本文引入了一种语义分层的 3D 世界表示方法,将场景分解为天空层(用于户外场景)、背景层和多个物体层。为了实现图层化过程的自动化,本文开发了一种智能世界分解方法,包括实例识别、图层分解和图层补全。

实例识别

在可交互的 3D 世界中,与特定场景物体的交互至关重要,而背景元素通常保持静态。为了实现交互式 3D 场景,本文必须对每个可交互物体进行单独的 3D 建模。本文的方法首先识别出哪些场景物体需要建模,这需要语义理解和空间关系推理。鉴于本文生成的场景具有高度多样性 —— 包括室内/室外环境、自然景观和游戏风格设置,本文利用视觉语言模型(VLM)借助其丰富的世界知识进行语义物体识别。在实例识别之后,本文根据物体的语义和空间关系将其分类为不同的子图层。例如,在城市场景中,本文会将近处的车辆与远处的建筑物分离到不同图层中。

图层分解

在获得语义标签后,下一步是确定这些识别物体的精确位置。然而,传统的视觉定位模型无法直接应用于全景图,因为全景图存在空间不连续性 —— 物体可能被分割在等距矩形投影(ERP)全景图的左右边界上。为了解决这个问题,本文在将全景图输入目标检测器(例如 Grounding DINO)之前,使用环形填充对其进行预处理。这一变换确保了跨越全景边界的物体被视为连续实体。在检测完成后,本文将边界框坐标从填充空间重新映射回原始全景图。随后,本文将检测到的边界框输入分割模型(例如 ZIM),以生成像素级的 mask。为处理重叠或碎片化的检测结果,本文基于物体面积大小应用非极大值抑制(NMS)。这确保了由于全景边界分割而被拆分的部分物体得以合并,从而实现对交互式场景元素更准确的 3D 建模。

图层补全

在物体分割之后,本文通过自回归式的“洋葱剥离”过程将全景图分解为背景(例如地形)和天空层。这一过程包括迭代地移除已识别的物体,并通过图像修复补全被遮挡区域以完成每一图层。为了训练图层补全模型,本文构建了一个全景图物体移除数据集,其中包含物体 mask、包含该物体的原始全景图,以及移除该物体后的目标全景图三元组。利用该数据集,本文对 Panorama-DiT 模型进行微调,使其学习遮挡区域的条件生成。同样,本文也在一个由天空 HDRI 构成的数据集上微调了天空层的补全模型。

分层世界重建

给定层次化的世界图层,本文以分层的方式重建 3D 世界。如上图 2(右)所示,重建过程包括两个阶段:(1) 图层对齐的深度估计,(2) 分层的 3D 世界生成。

图层对齐的深度估计

给定全景世界代理,本文预测每一图层的深度,然后执行跨层深度对齐。具体而言,本文首先通过将深度估计模型应用于原始全景图,获得基础深度图。第一前景图层中的物体深度可以从基础全景深度图中提取。

对于后续图层(例如后续前景图层以及移除前景后的背景图层),本文分别预测它们的深度,并使用深度匹配技术将其与基础全景深度图对齐,该技术通过最小化不同图层间重叠区域的距离来实现。这确保了不同图层之间的一致深度关系,从而维持重建 3D 场景的几何一致性。对于天空图层,本文将其深度设置为一个略大于所有现有图层中最大深度值的常数,确保天空出现在最远的位置。

分层 3D 世界生成

给定具有对齐深度图的分层图像,本文通过 WorldSheet 中的网格网片变形(sheet warping)进行世界重建。该重建过程遵循层次化方法。

前景物体重建

对于每一个前景图层,本文提供两种重建策略:

直接投影:本文根据深度和语义 mask,通过网片变形将前景物体直接转换为 3D 网格。为了确保从带 mask的全景图中变形得到的网格质量,本文还引入了极区平滑和网格边界抗锯齿的特殊处理; 3D 生成:本文在前景图层中生成完整的 3D 物体,然后将其放置到 3D 世界中。为了获得前景 3D 物体,本文根据实例 mask从前景图层中提取单个物体实例,并利用图像到 3D 的生成模型(例如 Hunyuan3D)生成高质量的 3D 物体资产。本文还提出了一种自动物体放置算法,在考虑空间布局的前提下将生成的物体放入 3D 场景中。

背景图层重建

对于背景图层,本文首先应用自适应深度压缩以处理深度异常值并确保适当的深度分布。然后,本文使用处理后的背景深度图,通过网片变形将背景全景图转换为 3D 网格。

天空图层重建

天空图层使用具有统一深度值的天空图像进行重建,该深度值设置为略大于场景最大深度。除了通过网片变形获得的传统网格表示外,本文还支持 HDRI 环境贴图表示,以在 VR 应用中实现更真实的天空渲染。本文还支持使用 3D 高斯溅射(3D Gaussian Splatting)作为网格表示的替代方案,通过基于深度优化的分层 3DGS 表示来实现。为处理等距矩形投影中的跨边界一致性,本文在重建过程中应用环形填充,确保全景边界处的无缝过渡。最终的分层 3D 世界保持适当的遮挡关系和深度顺序,从而实现具有真实视差效果的 VR 体验。

长距离世界扩展

尽管分层的世界重建支持世界探索,但仍存在视角遮挡和探索范围有限的问题。为了解决这些限制,本文引入 Voyager,这是一个基于视频的视图补全模型,能够实现一致的世界外推。Voyager 结合了世界一致的视频扩散与长距离探索机制,从初始世界视图和用户指定的相机轨迹中合成空间一致的 RGB-D 视频。

世界一致的视频扩散

Voyager 采用可扩展的世界缓存机制,以保持空间一致性并防止视觉幻觉。系统使用生成的 3D 场景构建初始的 3D 点云缓存,然后将该缓存投影到目标相机视图中,为扩散模型提供部分引导。生成的帧不断更新并扩展世界缓存,构建一个闭环系统,支持任意相机轨迹,同时保持几何一致性。

长距离世界探索

为了克服一次性生成长视频的限制,本文提出了一种世界缓存方案,结合平滑视频采样用于自回归场景扩展。世界缓存从所有生成帧中积累点云,并通过点剔除方法移除冗余点以优化内存使用。利用缓存的点云作为空间代理,本文开发了一种平滑采样策略,自回归地扩展视频序列,同时确保片段之间的无缝过渡。

系统效率优化

为了确保实际部署和实时性能,HunyuanWorld 1.0 在网格存储和模型推理组件上进行了全面的系统优化。

网格存储优化

3D 场景的网格在加载和存储方面体积较大。因此,本文采用了双重压缩策略,分别针对离线使用和在线部署场景,实现高效存储和快速加载,同时保持视觉质量。

具有高级参数化的网格简化

对于离线网格使用,本文采用一个多阶段流程,包括网格简化、纹理烘焙和 UV 参数化。本文评估了基于 XAtlas 的 UV 参数化解决方案,该方法在消除渲染接缝的同时保持良好的 UV 质量,相较于朴素参数化方法具有优势。该压缩流程实现了 80% 的体积压缩,尽管处理时间较长,但适用于高质量的离线内容准备。

面向 Web 的 Draco 压缩

对于在线 Web 部署场景,本文采用 Draco,它在保持视觉保真的同时提供卓越的压缩效率。该方法表现出优异的体积压缩能力(90%),并维持与未压缩网格相当的渲染质量。该格式原生支持 WebAssembly,确保与基于 Web 的图形管线无缝集成,并具备广泛的浏览器兼容性。

模型推理加速

本文的推理优化采用了基于 TensorRT 的加速框架,结合智能缓存与多 GPU 并行化。系统将扩散 Transformer 模型转换为优化后的 TensorRT 引擎,支持缓存和非缓存推理模式,并通过共享内存分配最小化 GPU 开销。本文实现了选择性缓存策略,对于非关键去噪步骤使用缓存推理,而对显著影响生成质量的关键步骤使用完整计算。在无分类器引导的场景中,系统通过线程执行实现多 GPU 并行处理,在不同设备上同时计算正向和负向提示条件,并同步聚合结果。该集成优化方案支持快速的 3D 世界生成,同时在多样化部署环境中保持高视觉质量。

长距离世界扩展

尽管分层的世界重建支持世界探索,但仍存在视角遮挡和探索范围有限的问题。为了解决这些限制,本文引入 Voyager,这是一个基于视频的视图补全模型,能够实现一致的世界外推。Voyager 结合了世界一致的视频扩散与长距离探索机制,从初始世界视图和用户指定的相机轨迹中合成空间一致的 RGB-D 视频。

世界一致的视频扩散

Voyager 采用可扩展的世界缓存机制,以保持空间一致性并防止视觉幻觉。系统使用生成的 3D 场景构建初始的 3D 点云缓存,然后将该缓存投影到目标相机视图中,为扩散模型提供部分引导。生成的帧不断更新并扩展世界缓存,构建一个闭环系统,支持任意相机轨迹,同时保持几何一致性。

长距离世界探索

为了克服一次性生成长视频的限制,本文提出了一种世界缓存方案,结合平滑视频采样用于自回归场景扩展。世界缓存从所有生成帧中积累点云,并通过点剔除方法移除冗余点以优化内存使用。利用缓存的点云作为空间代理,本文开发了一种平滑采样策略,自回归地扩展视频序列,同时确保片段之间的无缝过渡。

系统效率优化

为了确保实际部署和实时性能,HunyuanWorld 1.0 在网格存储和模型推理组件上进行了全面的系统优化。

网格存储优化

3D 场景的网格在加载和存储方面体积较大。因此,本文采用了双重压缩策略,分别针对离线使用和在线部署场景,实现高效存储和快速加载,同时保持视觉质量。

具有高级参数化的网格简化

对于离线网格使用,本文采用一个多阶段流程,包括网格简化、纹理烘焙和 UV 参数化。本文评估了基于 XAtlas 的 UV 参数化解决方案,该方法在消除渲染接缝的同时保持良好的 UV 质量,相较于朴素参数化方法具有优势。该压缩流程实现了 80% 的体积压缩,尽管处理时间较长,但适用于高质量的离线内容准备。

面向 Web 的 Draco 压缩

对于在线 Web 部署场景,采用 Draco,它在保持视觉保真的同时提供卓越的压缩效率。该方法表现出优异的体积压缩能力(90%),并维持与未压缩网格相当的渲染质量。该格式原生支持 WebAssembly,确保与基于 Web 的图形管线无缝集成,并具备广泛的浏览器兼容性。

模型推理加速

本文推理优化采用了基于 TensorRT 的加速框架,结合智能缓存与多 GPU 并行化。系统将扩散 Transformer 模型转换为优化后的 TensorRT 引擎,支持缓存和非缓存推理模式,并通过共享内存分配最小化 GPU 开销。本文实现了选择性缓存策略,对于非关键去噪步骤使用缓存推理,而对显著影响生成质量的关键步骤使用完整计算。在无分类器引导的场景中,系统通过线程执行实现多 GPU 并行处理,在不同设备上同时计算正向和负向提示条件,并同步聚合结果。该集成优化方案支持快速的 3D 世界生成,同时在多样化部署环境中保持高视觉质量。

模型评估

下图 4、5、10、11 中展示了基于图像和文本输入生成的全景图像和可探索的 3D 世界。可以看到,HunyuanWorld 1.0 生成的高质量全景图像严格遵循输入条件,而生成的 3D 世界则保持了空间一致性,并支持在多样化的相机轨迹、场景类型和艺术风格中进行沉浸式探索。首先进行实验,将本文的结果与当前最先进方法在全景生成和 3D 世界生成方面进行比较。随后,介绍一系列实际应用,展示 HunyuanWorld 1.0 在虚拟现实、物理模拟、游戏开发和交互式物体操作场景中的多样性。

评估协议

基准数据集

对于图像条件生成,本文在真实和 AI 生成图像上进行评估,图像来自 World Labs、Tanks and Temples,以及真实用户收集的图像。对于文本条件生成,本文通过众包方式构建了一个提示词基准,涵盖不同的场景类型、风格和长度。

评估指标

由于缺乏用于比较的真实数据,本文遵循相关设置,从两个关键方面定量评估本文方法的性能:输入与输出的一致性,以及视觉质量。为评估输入输出一致性,本文使用 CLIP 分数来衡量生成世界与给定提示(CLIP-T)或图像(CLIP-I)之间的相似度。为评估视觉质量,本文采用几种无参考图像质量评估指标,包括 BRISQUE、NIQE 和 Q-Align。

全景生成

本文对图像到全景图像生成和文本到全景图像生成两种方式进行比较和评估。

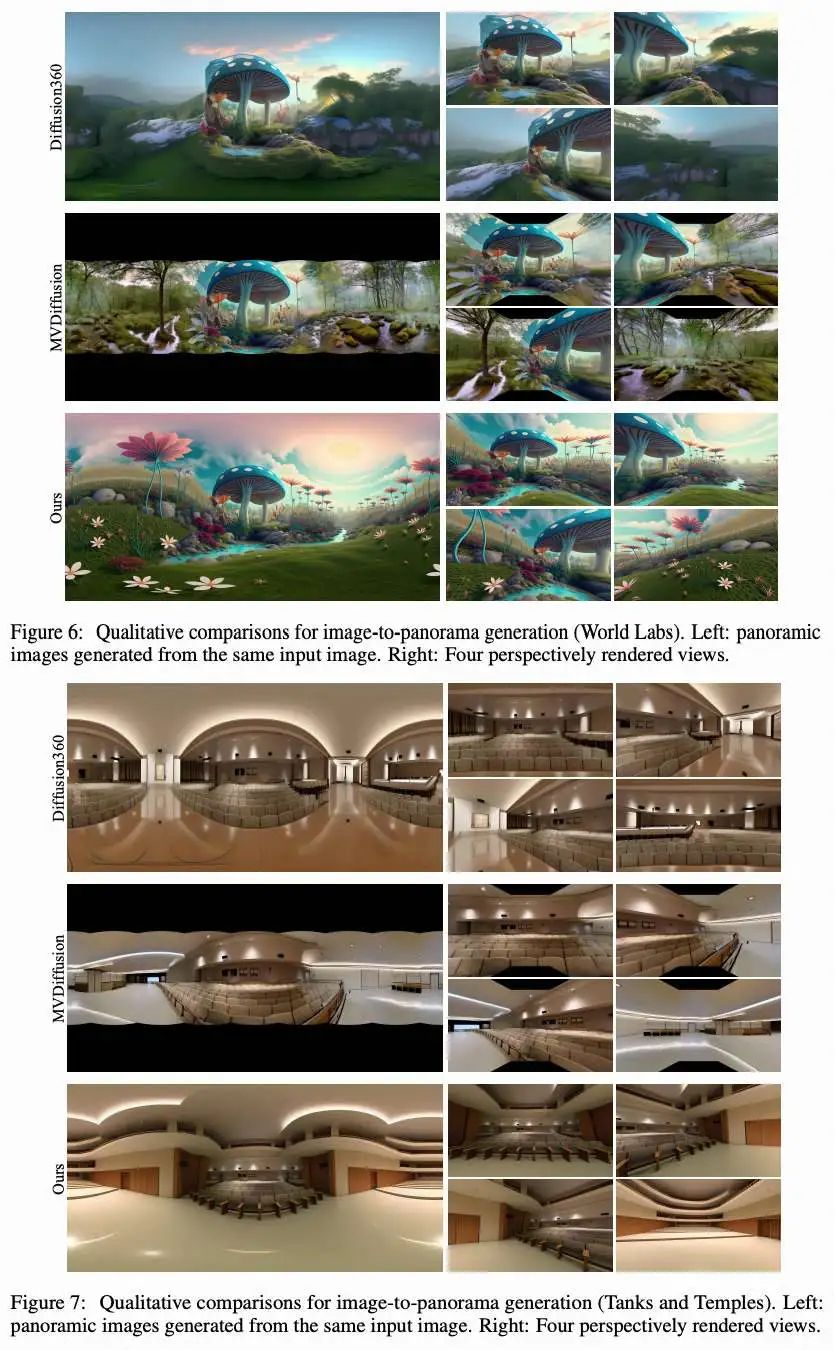

图像到全景图像比较

设置

本文将 HunyuanWorld 1.0 与两种最先进的基于图像的全景生成方法 Diffusion360 和 MVDiffusion 进行比较。本文测量生成的全景图像的视觉质量,以及从生成的全景图中渲染出的新图像与输入图像之间的 CLIP 图像嵌入相似度。具体而言,本文渲染六个视角,视场角为 ,位置策略性地分布以提供完整的 覆盖。每个视角的渲染分辨率为 。

结果下表 1 中展示的定量结果表明,HunyuanWorld 1.0 在所有评估指标上始终优于两个基线方法。这些结果突显了本文方法在生成高保真全景图像的同时,保持与输入之间强语义对应关系的有效性。下图 6 和下图 7 中的定性比较进一步验证了这些定量结果。与常常出现不连续伪影和几何畸变的基线方法相比,本文的方法生成的全景场景具有更强的视觉连贯性和美学质量。

文本到全景图像比较

设置

将 HunyuanWorld 1.0 与四种最先进的基于文本的全景生成方法进行比较:Diffusion360、MVDiffusion、PanFusion 和 LayerPano3D。本文保持与图像到全景图实验一致的渲染策略,对每个生成的全景图像渲染六个透视视角,视场角为 ,分辨率为 。本文使用 CLIP-T 分数量化生成的全景图像与对应文本输入之间的语义一致性。

结果

下表 2 中的定量结果表明,HunyuanWorld 1.0 在所有评估指标上均优于基线方法。下图 8 和下图 9 中的定性结果显示,本文的方法对文本描述展现出极高的保真度,同时保持了高标准的视觉质量。此外,HunyuanWorld 1.0 在生成多样艺术风格和主题场景的全景图方面表现出色。

三维世界生成

本文对 HunyuanWorld 1.0 的图像到世界生成和文本到世界生成能力进行比较和评估。

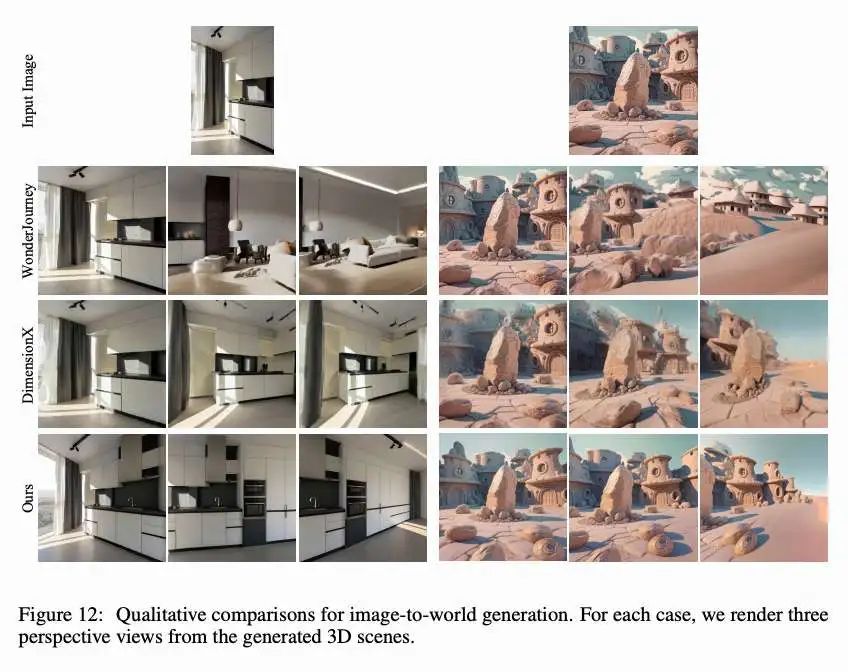

图像到世界生成比较

设置本文将 HunyuanWorld 1.0 与两种最先进的基于图像的三维世界生成方法 WonderJourney 和 DimensionX 进行比较。本文同时评估生成的三维世界的视觉质量,以及渲染出的新视角与输入图像之间的一致性。对于 HunyuanWorld 1.0,本文生成并重建完整的三维场景,用于渲染七个视角,视场角为 ,方位角分别为 。对于 DimensionX,本文使用其开源的 orbit LoRA 进行视频生成和三维重建,遵循其预定义的 轨道相机轨迹。对于 WonderJourney,本文采用同样右转 的相机轨迹进行评估。所有新视角的渲染分辨率为 。

结果下表 3 中展示的定量结果表明,HunyuanWorld 1.0 在渲染的新视角的视觉质量和与输入图像的语义一致性方面始终优于两个基线方法。下图 12 中的定性比较显示,相较于基线方法,本文的方法生成的三维世界在视觉质量和几何一致性方面表现更优,同时保持了与输入图像更高的一致性。

文本到世界生成比较

设置

本文将 HunyuanWorld 1.0 与两种最先进的基于文本的三维世界生成方法进行比较:LayerPano3D 和 Director3D。为了公平评估,本文对 HunyuanWorld 1.0 和 LayerPano3D 使用一致的评估协议,从重建的三维场景中渲染六个视角,视场角为 ,方位角分别为 。对于 Director3D,本文使用其模型预测的相机轨迹进行新视角渲染,因为其性能极度依赖于其自预测的相机轨迹。本文使用 CLIP-T 分数来量化生成的三维内容与其文本描述之间的语义一致性。所有新视角的渲染分辨率为 。

结果本文在下表 4 中展示了定量结果,下图 13 中展示了定性比较。HunyuanWorld 1.0 在所有评估指标上始终优于两个基线方法。视觉结果表明,本文方法生成的三维世界具有很高的视觉保真度,并与输入文本描述保持强语义一致性。值得注意的是,Director3D 在许多测试用例中存在生成远距离相机轨迹的局限性,限制了其在多样输入条件下的泛化能力。

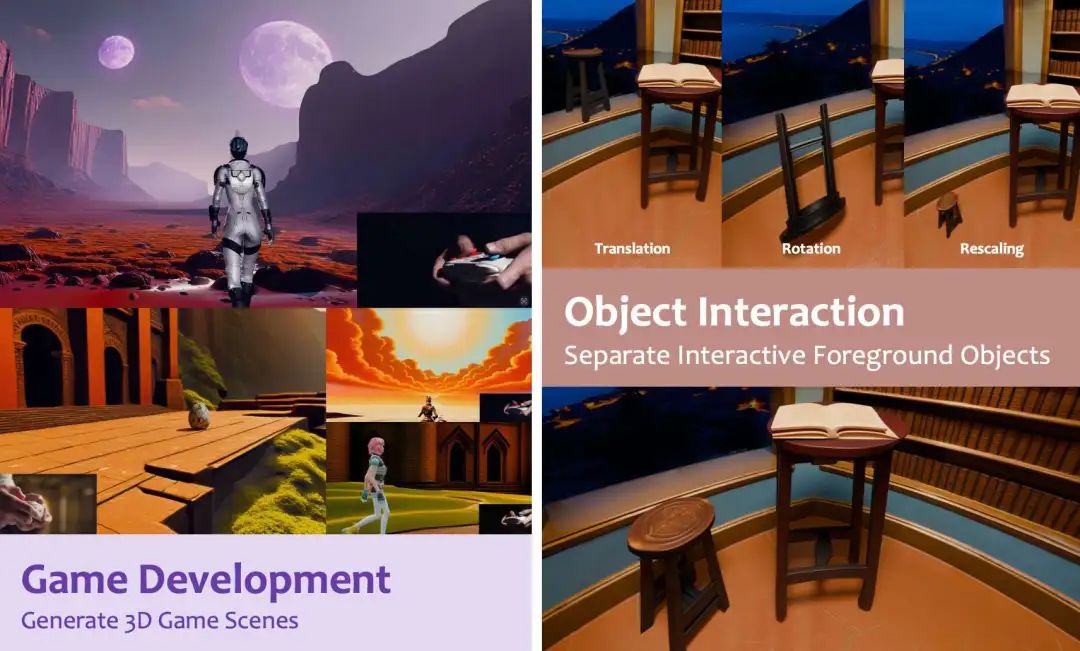

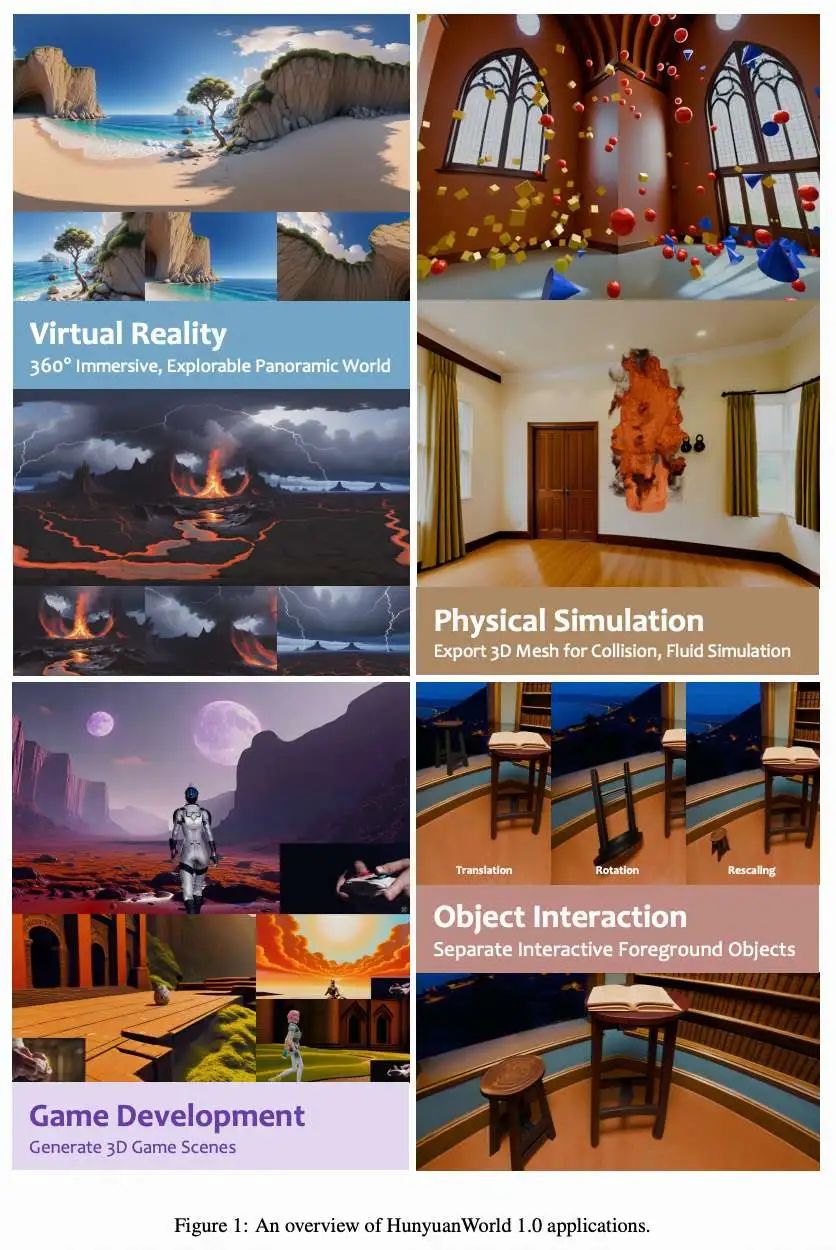

应用

HunyuanWorld 1.0 凭借其三个关键优势: 沉浸式体验、网格导出能力和可解耦的物体建模,支持广泛的实际应用,如下图 1 所示。

虚拟现实

本文的全景世界代理支持生成完全沉浸式的 环境,优化用于当前的虚拟现实平台部署,如 Apple Vision Pro 和 Meta Quest。全面的空间覆盖消除了视觉伪影和边界不连续性,提供无缝的全向浏览体验。

物理仿真

生成的三维世界和独立的三维物体表示支持直接导出三维网格,确保与现有计算机图形管线在物理仿真中的完全兼容。这使得与物理引擎的无缝集成成为可能,包括碰撞检测、刚体动力学和流体仿真。

游戏开发

生成的三维世界涵盖多种场景和美学风格,包括外星景观、中世纪建筑遗迹、历史遗迹以及未来城市环境。这些世界以标准三维网格格式导出,能够无缝集成到如 Unity 和 Unreal Engine 等行业标准游戏引擎中,用于游戏开发应用。

物体交互

可解耦的物体表示支持在生成的三维世界中进行精确的物体级操控与交互。用户可以对场景中的单个组件执行精确的三维变换,如平移、旋转和缩放,同时保持周围环境元素的完整性。

结论

本报告介绍了 HunyuanWorld 1.0,这是一个用于从文本和图像输入生成沉浸式、可探索和可交互三维世界的新型框架。本文利用语义分层的三维网格表示与全景世界代理,创建多样且三维一致的世界,并通过可解耦的物体增强交互性。大量实验证明,HunyuanWorld 1.0 在基于文本和基于图像的三维世界生成方面均达到了当前最先进的性能。本文方法的关键特性——360° 沉浸式体验、网格导出能力以及可解耦的物体表示——使其在虚拟现实、物理仿真和游戏开发等多个应用场景中具有广泛的适用性。HunyuanWorld 1.0 在世界级三维内容创作方面迈出了重要一步,并将作为未来在这一令人兴奋且快速发展的领域中研究的宝贵基线。

参考文献

[1] HunyuanWorld 1.0: Generating Immersive, Explorable, and Interactive 3D Worlds from Words or Pixels

致谢

如果您觉得这篇文章对你有帮助或启发,请不吝点赞、在看、转发,让更多人受益。同时,欢迎给个星标⭐,以便第一时间收到我的最新推送。每一个互动都是对我最大的鼓励。让我们携手并进,共同探索未知,见证一个充满希望和伟大的未来!

技术交流

加入「AI生成未来社区」群聊,一起交流讨论,涉及 图像生成、视频生成、3D生成、具身智能等多个不同方向,备注不同方向邀请入群!可添加小助手备注方向加群!

扫码添加微信

扫码添加微信

- 点赞 (0)

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊