为什么不推荐研究生搞强化学习研究?

- 2025-07-20 08:00:00

作者 | Kit Kitkat 编辑 | 大模型之心Tech

原文链接:https://www.zhihu.com/question/1900927726795334198

点击下方卡片,关注“大模型之心Tech”公众号

>>点击进入→大模型没那么大Tech技术交流群

本文只做学术分享,如有侵权,联系删文,自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

写在前面

我已经很久没答学术上的问题了,因为最近审的申请书一半都是强化学习相关的?所以知乎老给我推强化学习的各种东西……我就来简单的谈一谈强化学习吧。

强化学习如果说你要是读到硕士研究生为止,哪怕你读的是清华北大的,最重要的基本功就是调包,搞清楚什么时候该调什么包就可以了,其次就是怎么排列组合,怎么缩小解空间,对一些算法只需要有个基本的流程性了解就好了。

如果你读的是博士,建议换个方向,我觉得在现在的强化学习上雕花就是浪费时间和生命,当然你要是以发很多papers,混个教职当然可以,就是你可能很久都做不出真正很好的工作来,混口饭吃也不注重这个。

我对强化学习的感受就是古老且原始,感觉就好像现在我还拿着一个iphone 初代在用,没有原生多任务,有好多研究者给这个上头魔改了一下做了个伪的多任务,但是仍然改变不了它的本体是2g手机的本质,所以在上面折腾来折腾去的意义有限。

或者从另一个角度来看,我耳边响起了星际穿越这部电影的配音。

强化学习主线

强化学习的主线,可以按照两种方法来分:

A. Model based/ Model Free B. Value-based/Policy-based (+混合 AxC) ,数学上掌握起来不难,一般懂的人给讲一讲一个周基本上各种各样的算法全部都能掌握了,本质都差不多的。

写的具体一点就是:

1.1 Value-based 1.2 Policy-based

Model-based

2.1 Value-based 2.2 Policy-based 2.3 Actor-Critic

Model-free

这些方法都建立在MDP这个上头,说的更加符合课本一点,其基础就是贝尔曼公式、时序差分、蒙特卡洛这个东西,后面对RL的所有攻击基本上都是基于这三个最核心的内容。

为什么不推荐搞强化学习研究?

说说为啥我不推荐搞强化学习研究,我发现极少人愿意去讲强化学习的这些问题,可能是怕说了以后影响门派香火吧:

我先提一提本质上的第1个问题:样本利用效率低

我原来最早入门机器学习的课本是概率图模型(PGMs),所以对这些比较敏感一点,我感觉强化学习就是利用蒙特卡洛(MC)或时序差分(TD)方法,近似地做动态规划。所以PGMs当年遇到的样本利用效率极低的问题,强化学习也跑不了。

所以很多解决方案一看就很熟悉了,就是把当年PGMs里面那一套移植了一下:

模型学习与结构化建模:像PGM一样显式学习环境动态的概率结构(如状态转移和奖励分布),利用模型生成“虚拟经验”或做规划。流派:Model-based RL等。

变分推断与贝叶斯方法:借鉴PGM的变分推断和贝叶斯推断,建模策略/价值函数/环境参数的不确定性,用于高效探索和样本复用。流派:Bayesian DQN、Bayesian Policy Optimization、Soft Actor-Critic等。

重要性采样与加权经验复用:利用PGM里的重要性采样思想,对采集到的经验进行加权复用,提高样本利用率。流派:离线RL、优先经验回放等。

层次化结构与因果推断:借鉴PGM的层次化和因果建模思想,分层抽象决策和归因,提升泛化与数据利用率。流派:Hierarchical RL等。

消息传递与结构化规划:PGM中的信念传播和结构化推断,可在RL的多智能体、网络化环境等情形下提升局部决策效率和样本共享。流派:某些多智能体RL。

最终结论:当年PGMs搞这个搞定了没有?明显没有!这些东西可能在强化学习里面看起来很复杂,但是这个是PGMs的基础理论,要是不会我上头说的这些推导,你基本上等于没有学过PGM。你说RL能在这个框架下搞定样本利用率低的问题吗,我个人觉得,显然不能,这个是框架决定了上限,你和我说一个2G手机改改能和5G的上网一样快?如果真的可以,我反而觉得PGMs的复活会比RL更早。

我再说说第2个问题吧:泛化能力堪忧!

这个我们在做PGMs的时候也同样遇到的,RL事实上问题的症结也是类似的,就是假设太强了。

PGM的强假设很多体现在公式“背后”, PGM的很多假设体现在模型结构、推断过程和理论证明里,往往是“间接”的。

独立同分布(IID):虽然所有采样和期望都假设样本独立,但PGM推断/估计过程中很少会在主公式上直接写出IID,而是隐含在分布分解与采样机制里。

马尔可夫性:PGM的马尔可夫假设(如一阶马尔可夫链、马尔可夫网络等),更多作为结构约束体现在图结构里,不总是在损失/目标函数上显式出现。

共轭分布:选择共轭分布主要是为了推断可解和计算方便,也很少在优化目标里直接体现,而是在参数更新和边缘化步骤才用上。

RL的强假设往往更“显式”更“硬”, RL中的这些假设常常作为更新规则的直接依据,公式“表面”就能看到,一旦假设被破坏,算法很容易失效。

马尔可夫性:Bellman方程、策略评估、TD误差等都直接假定下一步只由当前状态和动作决定,这在所有RL的核心公式里明晃晃地写着。

IID与经验复用:很多RL方法在采样或经验回放时,直接要求数据独立且分布不变,但现实中经验池、环境变化导致分布漂移问题极其突出。

奖励函数与环境动力学:RL几乎所有公式都假定奖励和状态转移分布是已知或能被模型学到的,现实中常常难以满足。

结论:首先,这些假设是在是太强了,根本不符合实际,其次,相比之下我觉得PGM会稍好一点,RL可以改的和PGM差不多,把PGM那个东西也可以移植一部分进来,那一弄不就是PGM的翻版了。同样的,当年PGMs解决这个问题了吗,没有没有没有!

别的问题我就不多说了,就是这两个问题事实上是RL当前遇到大困境的来源,那怎么办,解决的方案其实就是把RL自己的命给革了,这个就是Bellman equation,TD, MC带来的本质性问题。如果RL的发展方向是搞各种算法移植PGMs的思想的话,那PGM的昨天不就是RL的明天吗?RL其实最应该做的就是重新思考大框架,就像手机一样,2G时代终将落幕,希望今后的研究者带我们进入一个新的世界。

最后再说一句

其实RL也没有那么不行,当年做统计机器学习的时候不也是有很多很好的应用,在有限的条件下可以用RL。

RL的具体思路和深度学习的思路不太一致,这个从我上面的分析中也能看出来,因此RL可以作为辅助性方法,千万不要把RL当成一个主方法,当你用其他方法真的没法解决的时候,用一下RL死马当活马搞一下看看。 如果要真的用RL,其中最关键的是要严格定义RL的搜索空间,缓解采样效率低的问题,另外最好能根据先验限制RL的应用环境,避免泛化性能弱的问题。

大模型之心Tech知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

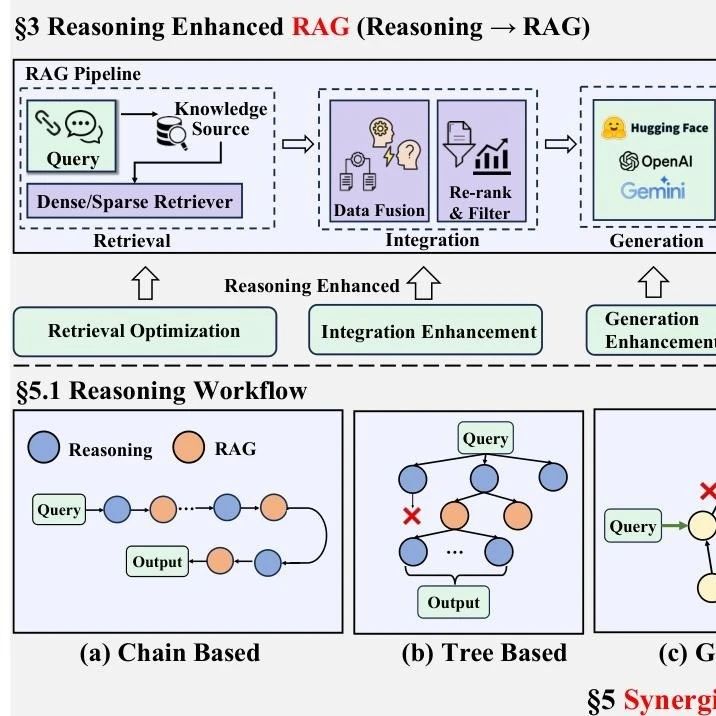

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,加入后3天内不满意可随时退款,欢迎扫码加入一起学习一起卷!

扫码添加微信

扫码添加微信

- 点赞 0

-

分享

微信扫一扫

-

加入群聊

扫码加入群聊

扫码加入群聊